Global katastrofrisk

|

| Framtidsstudier |

|---|

| Koncept |

| Tekniker |

| Teknikbedömning och prognoser _ |

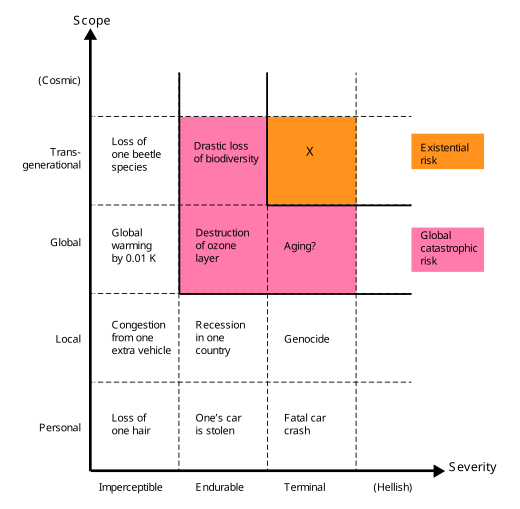

En global katastrofrisk eller ett domedagsscenario är en hypotetisk framtida händelse som kan skada mänskligt välbefinnande på en global skala, till och med äventyra eller förstöra den moderna civilisationen . En händelse som kan orsaka mänsklig utrotning eller permanent och drastiskt inskränka mänsklighetens potential är känd som en " existentiell risk ".

Under de senaste två decennierna har ett antal akademiska och ideella organisationer etablerats för att undersöka globala katastrofala och existentiella risker, formulera potentiella begränsningsåtgärder och antingen förespråka eller genomföra dessa åtgärder.

Definition och klassificering

Definiera globala katastrofrisker

Termen global katastrofrisk "saknar en skarp definition", och syftar generellt (löst) på en risk som kan orsaka "allvarlig skada på mänskligt välbefinnande på global skala".

Mänskligheten har drabbats av stora katastrofer tidigare. Vissa av dessa har orsakat allvarliga skador men var bara lokala till sin omfattning – t.ex. digerdöden ha resulterat i döden av en tredjedel av Europas befolkning, 10 % av den globala befolkningen vid den tiden. Vissa var globala, men var inte lika allvarliga – t.ex. influensapandemin 1918 uppskattningsvis 3–6 % av världens befolkning. De flesta globala katastrofrisker skulle inte vara så intensiva att de dödade majoriteten av livet på jorden, men även om man gjorde det skulle ekosystemet och mänskligheten så småningom återhämta sig (i motsats till existentiella risker ).

På liknande sätt, i Catastrophe: Risk and Response , pekar Richard Posner ut och grupperar händelser som åstadkommer "fullständig störtning eller ruin" på en global, snarare än en "lokal eller regional", skala. Posner lyfter fram sådana händelser som värda särskild uppmärksamhet på kostnads-nyttoskäl eftersom de direkt eller indirekt skulle kunna äventyra mänsklighetens överlevnad som helhet.

Definiera existentiella risker

Existentiella risker definieras som "risker som hotar förstörelsen av mänsklighetens långsiktiga potential." Förekomsten av en existentiell risk (en existentiell katastrof ) skulle antingen orsaka direkt mänsklig utrotning eller oåterkalleligt låsa in ett drastiskt sämre tillstånd. Existentiella risker är en underklass av globala katastrofrisker, där skadan inte bara är global utan också terminal och permanent, vilket förhindrar återhämtning och därigenom påverkar både nuvarande och alla framtida generationer.

Icke-utrotningsrisker

Medan utrotning är det mest uppenbara sättet på vilket mänsklighetens långsiktiga potential kan förstöras, finns det andra, inklusive oåterkallelig kollaps och oåterställbar dystopi . En katastrof som är tillräckligt allvarlig för att orsaka den mänskliga civilisationens permanenta, oåterkalleliga kollaps skulle utgöra en existentiell katastrof, även om den inte skulle utrotas. På samma sätt, om mänskligheten föll under en totalitär regim, och det inte fanns någon chans till återhämtning, skulle en sådan dystopi också vara en existentiell katastrof. Bryan Caplan skriver att "kanske skulle en evighet av totalitarism vara värre än utrotning". ( George Orwells roman Nineteen Eighty-Four föreslår ett exempel.) Ett dystopiskt scenario delar nyckeldragen i civilisationens utplåning och oåterkalleliga kollaps – före katastrofen stod mänskligheten inför ett stort antal ljusa framtider att välja mellan; efter katastrofen är mänskligheten för alltid låst i ett fruktansvärt tillstånd.

Potentiella riskkällor

Potentiella globala katastrofrisker klassificeras konventionellt som antropogena eller icke-antropogena faror. Exempel på icke-antropogena risker är en asteroidnedslagshändelse , ett supervulkanutbrott , en dödlig gammastrålning , en geomagnetisk storm som förstör elektronisk utrustning, naturliga långsiktiga klimatförändringar , fientligt utomjordiskt liv eller den förutsägbara solen som förvandlas till en röd jätte stjärna som uppslukar jorden.

Antropogena risker är de som orsakas av människor och inkluderar de som är relaterade till teknik, styrning och klimatförändringar. Teknologiska risker inkluderar skapandet av artificiell intelligens som inte är i linje med mänskliga mål, bioteknik och nanoteknik . Otillräcklig eller illasinnad global styrning skapar risker inom det sociala och politiska området, såsom globalt krig och kärnvapenförintelse , bioterrorism som använder genetiskt modifierade organismer , cyberterrorism som förstör kritisk infrastruktur som elnätet , eller misslyckandet med att hantera en naturlig eller konstruerad pandemi . Globala katastrofrisker inom området för styrning av jordens system inkluderar global uppvärmning , miljöförstöring , utrotning av arter , svält till följd av ojämlik resursfördelning, mänsklig överbefolkning , missväxt och ohållbart jordbruk .

Metodologiska utmaningar

Forskning om arten och begränsningen av globala katastrofrisker och existentiella risker är föremål för en unik uppsättning utmaningar och är som ett resultat inte lätt att utsättas för de vanliga normerna för vetenskaplig rigoritet. Det är till exempel varken genomförbart eller etiskt att studera dessa risker experimentellt. Carl Sagan uttryckte detta när det gäller kärnvapenkrig: "Att förstå de långsiktiga konsekvenserna av kärnvapenkrig är inte ett problem som kan experimentell verifieras". Dessutom förändras många katastrofrisker snabbt i takt med att tekniken går framåt och bakgrundsförhållandena, såsom geopolitiska förhållanden, förändras. En annan utmaning är den allmänna svårigheten att exakt förutsäga framtiden över långa tidsskalor, särskilt för antropogena risker som beror på komplexa mänskliga politiska, ekonomiska och sociala system. Förutom kända och påtagliga risker kan oförutsägbara utrotningshändelser av svarta svanar inträffa, vilket utgör ytterligare ett metodologiskt problem.

Brist på historiskt prejudikat

Mänskligheten har aldrig drabbats av en existentiell katastrof och om en sådan skulle inträffa skulle det nödvändigtvis vara utan motstycke. Därför utgör existentiella risker unika utmaningar för förutsägelse, till och med mer än andra långtidshändelser, på grund av observationsselektionseffekter . Till skillnad från de flesta händelser, är misslyckandet med att en fullständig utrotningshändelse inträffade i det förflutna inte bevis mot deras sannolikhet i framtiden, eftersom varje värld som har upplevt en sådan utrotningshändelse har inga observatörer, så oavsett deras frekvens, observerar ingen civilisation existentiella risker i dess historia. Dessa antropiska frågor kan delvis undvikas genom att titta på bevis som inte har sådana urvalseffekter, såsom asteroidkratrar på månen, eller direkt utvärdera den sannolika effekten av ny teknik.

För att förstå dynamiken i en aldrig tidigare skådad, oåterkallelig global civilisationskollaps (en typ av existentiell risk), kan det vara lärorikt att studera de olika lokala civilisationskollapser som har inträffat genom mänsklighetens historia. Till exempel har civilisationer som Romarriket slutat i en förlust av centraliserad förvaltning och en stor civilisationsomfattande förlust av infrastruktur och avancerad teknologi. Men dessa exempel visar att samhällen verkar vara ganska motståndskraftiga mot katastrofer; till exempel överlevde det medeltida Europa digerdöden utan att drabbas av något som liknade en civilisationskollaps trots att man förlorade 25 till 50 procent av sin befolkning.

Incitament och samordning

Det finns ekonomiska skäl som kan förklara varför så lite ansträngning läggs på existentiell riskminskning. Det är ett globalt allmännytta , så vi bör förvänta oss att det underförsörjs av marknaderna. Även om en stor nation investerar i riskreducerande åtgärder, kommer den nationen att åtnjuta endast en liten bråkdel av fördelen med att göra det. Dessutom är existentiell riskreduktion en mellan generationerna , eftersom de flesta av fördelarna med existentiell riskreduktion skulle åtnjutas av framtida generationer, och även om dessa framtida människor i teorin kanske skulle vara villiga att betala betydande summor för existentiell riskminskning, finns det ingen mekanism. för en sådan transaktion existerar.

Kognitiva fördomar

Många kognitiva fördomar kan påverka människors bedömning av betydelsen av existentiella risker, inklusive omfattningsokänslighet , hyperbolisk diskontering , tillgänglighetsheuristik , konjunktionsfelet , affektheuristiken och övertroendeeffekten .

Omfattning okänslighet påverkar hur dåliga människor anser att mänsklighetens utrotning är. Till exempel, när människor är motiverade att donera pengar till altruistiska ändamål, ökar inte den kvantitet de är villiga att ge linjärt med frågans omfattning: människor är ungefär lika villiga att förhindra dödsfall av 200 000 eller 2 000 fåglar. På samma sätt är människor ofta mer bekymrade över hot mot individer än mot större grupper.

Eliezer Yudkowsky teoretiserar att räckviddsförsummelse spelar en roll i allmänhetens uppfattning om existentiella risker:

Betydligt större siffror, som 500 miljoner dödsfall, och särskilt kvalitativt olika scenarier som utrotningen av hela den mänskliga arten, verkar trigga ett annat sätt att tänka... Människor som aldrig skulle drömma om att skada ett barn hör om existentiella risker, och säg, "Tja, den mänskliga arten kanske inte riktigt förtjänar att överleva".

Alla tidigare förutsägelser om mänsklig utrotning har visat sig vara falska. För vissa gör detta att framtida varningar verkar mindre trovärdiga. Nick Bostrom hävdar att frånvaron av mänsklig utrotning i det förflutna är svaga bevis för att det inte kommer att finnas någon mänsklig utrotning i framtiden, på grund av överlevande partiskhet och andra antropiska effekter .

Sociobiologen E. O. Wilson hävdade att: "Orsaken till denna närsynta dimma, hävdar evolutionsbiologer, är att den faktiskt var fördelaktig under alla utom de senaste årtusendena av de två miljoner åren av existensen av släktet Homo... En premie lades på stor uppmärksamhet på den närmaste framtiden och tidig reproduktion, och lite annat. Katastrofer av en omfattning som inträffar bara en gång med några århundraden glömdes bort eller omvandlades till myter."

Föreslagen begränsning

Flerlagers försvar

Försvar i djupet är ett användbart ramverk för att kategorisera riskreducerande åtgärder i tre försvarsskikt:

- Förebyggande : Minska sannolikheten för att en katastrof inträffar i första hand. Exempel: Åtgärder för att förhindra utbrott av nya mycket smittsamma sjukdomar.

- Svar : Förhindrar en skalning av en katastrof till global nivå. Exempel: Åtgärder för att förhindra eskalering av ett småskaligt kärnvapenutbyte till ett totalt kärnvapenkrig.

- Motståndskraft : Att öka mänsklighetens motståndskraft (mot utrotning) när den står inför globala katastrofer. Exempel: Åtgärder för att öka livsmedelssäkerheten under en kärnkraftsvinter.

Människans utrotning är mest sannolikt när alla tre försvaret är svaga, det vill säga "genom risker som vi sannolikt inte kommer att förhindra, osannolikt att framgångsrikt reagera på och osannolikt att vara motståndskraftiga mot".

De existentiella riskerna utan motstycke utgör en speciell utmaning vid utformningen av riskreducerande åtgärder eftersom mänskligheten inte kommer att kunna lära sig av tidigare händelser.

Finansiering

Vissa forskare hävdar att både forskning och andra initiativ som rör existentiell risk är underfinansierade. Nick Bostrom säger att mer forskning har gjorts om Star Trek , snowboard eller dyngbaggar än om existentiella risker. Bostroms jämförelser har kritiserats som "high-handed". Från och med 2020 Biological Weapons Convention en årlig budget på 1,4 miljoner USD.

Överlevnadsplanering

Vissa forskare föreslår etablering på jorden av en eller flera självförsörjande, avlägsna, permanent ockuperade bosättningar speciellt skapade i syfte att överleva en global katastrof. Ekonomen Robin Hanson hävdar att en tillflyktsort som permanent hyser så få som 100 personer avsevärt skulle förbättra chanserna för mänsklig överlevnad under en rad globala katastrofer.

Livsmedelslagring har föreslagits globalt, men den monetära kostnaden skulle bli hög. Dessutom skulle det sannolikt bidra till de nuvarande miljontals dödsfall per år på grund av undernäring . År 2022 modellerade ett team under ledning av David Denkenberger kostnadseffektiviteten hos motståndskraftiga livsmedel till säkerhet med artificiell allmän intelligens (AGI) och fann "~98-99% förtroende" för en högre marginell påverkan av arbete med motståndskraftiga livsmedel. Vissa survivalists lager överlevnadsretreater med fleråriga matförråd.

Svalbard Global Seed Vault är begravd 400 fot (120 m) inne i ett berg på en ö i Arktis . Den är utformad för att hålla 2,5 miljarder frön från mer än 100 länder som en försiktighetsåtgärd för att bevara världens grödor. Det omgivande berget är -6 °C (21 °F) (från 2015) men valvet hålls vid -18 °C (0 °F) av kylskåp som drivs av lokalt kol.

Mer spekulativt, om samhället fortsätter att fungera och om biosfären förblir beboelig, kan kaloribehovet för den nuvarande mänskliga befolkningen i teorin tillgodoses under en långvarig frånvaro av solljus, givet tillräcklig förhandsplanering. Förmodade lösningar inkluderar att odla svamp på den döda växtbiomassan som lämnats i kölvattnet av katastrofen, omvandla cellulosa till socker eller mata naturgas till metansmältande bakterier.

Globala katastrofrisker och global styrning

Otillräcklig global styrning skapar risker på det sociala och politiska området, men styrmekanismerna utvecklas långsammare än tekniska och sociala förändringar. Det finns oro från regeringar, den privata sektorn såväl som allmänheten över bristen på styrningsmekanismer för att effektivt hantera risker, förhandla och döma mellan olika och motstridiga intressen. Detta understryks ytterligare av en förståelse för samverkan mellan globala systemrisker. I avsaknad av eller förutseende av global styrning kan nationella regeringar agera individuellt för att bättre förstå, mildra och förbereda sig för globala katastrofer.

Planer för klimatberedskap

År 2018 efterlyste Romklubben större klimatförändringsåtgärder och publicerade sin klimatplan, som föreslår tio åtgärder för att begränsa den globala medeltemperaturökningen till 1,5 grader Celsius. Under 2019 publicerade klubben dessutom den mer omfattande Planetary Emergency Plan.

Det finns bevis som tyder på att ett kollektivt engagemang i de känslomässiga upplevelser som dyker upp under övervägande av den mänskliga artens sårbarhet inom ramen för klimatförändringar gör det möjligt för dessa upplevelser att vara adaptiva. När kollektivt engagemang och bearbetning av känslomässiga upplevelser är stödjande kan detta leda till tillväxt i motståndskraft, psykologisk flexibilitet, tolerans för känslomässiga upplevelser och samhällsengagemang.

Rymdkolonisering

Rymdkolonisering är ett föreslaget alternativ för att förbättra chanserna att överleva ett utrotningsscenario. Lösningar av denna omfattning kan kräva megaskalig ingenjörskonst .

Astrofysikern Stephen Hawking förespråkade kolonisering av andra planeter i solsystemet när tekniken fortskrider tillräckligt, för att förbättra chansen för människans överlevnad från planetomfattande händelser som globalt termonukleärt krig.

Miljardären Elon Musk skriver att mänskligheten måste bli en flerplanetär art för att undvika utrotning. Musk använder sitt företag SpaceX för att utveckla teknik som han hoppas ska användas i koloniseringen av Mars .

Flytta jorden

Om några miljarder år kommer solen att expandera till en röd jätte som sväljer jorden. Detta kan undvikas genom att flytta jorden längre ut från solen och hålla temperaturen ungefär konstant. Det kan åstadkommas genom att justera banorna för kometer och asteroider så att de passerar nära jorden på ett sådant sätt att de tillför energi till jordens omloppsbana. Eftersom solens expansion är långsam, skulle ungefär ett sådant möte vart 6 000:e år räcka. [ citat behövs ]

Skeptiker och motståndare

Psykologen Steven Pinker har kallat existentiell risk för en "värdelös kategori" som kan distrahera från verkliga hot som klimatförändringar och kärnvapenkrig.

Organisationer

The Bulletin of the Atomic Scientists (uppskattad 1945) är en av de äldsta globala riskorganisationerna, som grundades efter att allmänheten blev orolig över potentialen för atomkrigföring i efterdyningarna av andra världskriget. Den studerar risker förknippade med kärnvapenkrig och energi och upprätthåller välkända Doomsday Clock som etablerades 1947. Foresight Institute (uppskattat 1986) undersöker riskerna med nanoteknik och dess fördelar. Det var en av de tidigaste organisationerna som studerade de oavsiktliga konsekvenserna av att annars ofarlig teknologi har gått åt helvete i global skala. Det grundades av K. Eric Drexler som postulerade " gray goo ".

Från och med 2000 skapade ett växande antal forskare, filosofer och teknikmiljardärer organisationer som ägnade sig åt att studera globala risker både inom och utanför den akademiska världen.

Oberoende icke-statliga organisationer (NGOs) inkluderar Machine Intelligence Research Institute (uppskattat 2000), som syftar till att minska risken för en katastrof orsakad av artificiell intelligens, med donatorer inklusive Peter Thiel och Jed McCaleb . Nuclear Threat Initiative (uppskattat 2001) syftar till att minska globala hot från nukleära, biologiska och kemiska hot och att begränsa skador efter en händelse. Den upprätthåller ett säkerhetsindex för kärnmaterial. Lifeboat Foundation (uppskattad 2009) finansierar forskning för att förhindra en teknisk katastrof. Merparten av forskningspengarna finansierar projekt vid universiteten. Global Catastrophic Risk Institute (uppskattat 2011) är en USA-baserad ideell, partipolitisk tankesmedja grundad av Seth Baum och Tony Barrett. GCRI gör forskning och policyarbete över olika risker, inklusive artificiell intelligens, kärnvapenkrig, klimatförändringar och asteroidpåverkan. Global Challenges Foundation (est. 2012), baserad i Stockholm och grundad av Laszlo Szombatfalvy , släpper en årlig rapport om tillståndet för globala risker. Future of Life Institute (est. 2014) arbetar för att minska extrema, storskaliga risker från transformativa teknologier, samt styra utvecklingen och användningen av dessa teknologier för att gynna allt liv, genom bidragsgivning, policyförespråkande i USA, Europa Unionen och Förenta Nationerna, och utbildningsverksamhet. Elon Musk , Vitalik Buterin och Jaan Tallinn är några av dess största givare. The Center on Long-Term Risk (est. 2016), tidigare känt som Foundational Research Institute, är en brittisk organisation inriktad på att minska riskerna för astronomiskt lidande ( s-risker) från framväxande teknologier.

Universitetsbaserade organisationer inkluderar Future of Humanity Institute (est. 2005) som forskar i frågorna om mänsklighetens långsiktiga framtid, särskilt existentiella risker. Det grundades av Nick Bostrom och är baserat vid Oxford University. Center for the Study of Existential Risk (uppskattat 2012) är en Cambridge University-baserad organisation som studerar fyra stora tekniska risker: artificiell intelligens, bioteknik, global uppvärmning och krigföring. Alla är konstgjorda risker, som Huw Price förklarade för nyhetsbyrån AFP, "Det verkar vara en rimlig förutsägelse att någon gång under detta eller nästa århundrade kommer intelligensen att fly från biologins begränsningar". Han tillade att när detta händer "är vi inte längre de smartaste sakerna som finns" och kommer att riskera att bli utlämnade till "maskiner som inte är skadliga, utan maskiner vars intressen inte inkluderar oss." Stephen Hawking var en tillförordnad rådgivare. Millennium Alliance for Humanity and the Biosphere är en Stanford University-baserad organisation som fokuserar på många frågor relaterade till global katastrof genom att föra samman medlemmar av den akademiska världen inom humaniora. Det grundades av bland annat Paul Ehrlich . Stanford University har också Center for International Security and Cooperation som fokuserar på politiskt samarbete för att minska globala katastrofrisker. Center for Security and Emerging Technology etablerades i januari 2019 vid Georgetowns Walsh School of Foreign Service och kommer att fokusera på policyforskning av framväxande teknologier med en initial tonvikt på artificiell intelligens. De fick ett anslag på 55 miljoner USD från Good Ventures enligt förslag från Open Philanthropy .

Andra riskbedömningsgrupper är baserade i eller ingår i statliga organisationer. Världshälsoorganisationen WHO ) inkluderar en avdelning som kallas Global Alert and Response (GAR) som övervakar och reagerar på global epidemikris. GAR hjälper medlemsländerna med utbildning och samordning av insatser vid epidemier. United States Agency for International Development ( USAID) har sitt Emerging Pandemic Threats Program som syftar till att förebygga och begränsa naturligt genererade pandemier vid källan. Lawrence Livermore National Laboratory har en avdelning som kallas Global Security Principal Directorate som forskar på regeringens vägnar frågor som biosäkerhet och terrorismbekämpning.

Se även

- Apokalyptisk och postapokalyptisk fiktion

- kapprustning med artificiell intelligens

- Katalysmisk polskiftehypotes

- Gemenskapens motståndskraft

- Domedagskult

- Eskatologi

- Extrem risk

- Misslyckat tillstånd

- Fermi paradox

- Framsyn (psykologi)

- Jordens framtid

- Solsystemets framtid

- Geoteknik

- Global riskrapport

- Bra filter

- Holocen utrotning

- Påverkanshändelse

- Lista över globala frågor

- Kärnvapenspridning

- Problem med yttre sammanhang

- Planetära gränser

- Sällsynta händelser

- Den sjätte utrotningen: en onaturlig historia

- Social degeneration

- Samhällskollaps

- Samhällsomvandling

- Spekulativ evolution

- Survivalism

- Svansrisk

- The Precipice: Existentiell risk och mänsklighetens framtid

- Tidslinje för den avlägsna framtiden

- Universums ultimata öde

- Världsforskares varning till mänskligheten

Vidare läsning

- Avin, Shahar; Wintle, Bonnie C.; Weitzdörfer, Julius; ó Héigeartaigh, Seán S.; Sutherland, William J.; Rees, Martin J. (2018). "Klassificering av globala katastrofrisker" . Futures . 102 : 20–26. doi : 10.1016/j.futures.2018.02.001 .

- Corey S. Powell (2000). "Tjugo sätt världen skulle kunna ta slut plötsligt" , Discover Magazine

- Derrick Jensen (2006) Slutspel ( ISBN 1-58322-730-X ).

- Donella Meadows (1972). Gränserna för tillväxt ( ISBN 0-87663-165-0 ).

- Edward O. Wilson (2003). Livets framtid . ISBN 0-679-76811-4

- Holt, Jim , "The Power of Catastrophic Thinking" (recension av Toby Ord , The Precipice: Existential Risk and the Future of Humanity , Hachette, 2020, 468 s.), The New York Review of Books , vol. LXVIII, nr. 3 (25 februari 2021), s. 26–29. Jim Holt skriver (s. 28): "Oavsett om du söker efter ett botemedel mot cancer, eller gör en akademisk eller konstnärlig karriär, eller engagerad i att etablera mer rättvisa institutioner, är ett hot mot mänsklighetens framtid också ett hot mot betydelsen av det du gör."

- Huesemann, Michael H. och Joyce A. Huesemann (2011). Technofix: Why Technology Won't Save Us or the Environment , Kapitel 6, "Sustainability or Collapse", New Society Publishers , Gabriola Island, British Columbia, Kanada, 464 sidor ( ISBN 0865717044 ).

- Jared Diamond , Collapse: How Societies Choose to Fail or Succeed , Penguin Books , 2005 och 2011 ( ISBN 9780241958681 ).

- Jean-Francois Rischard (2003). High Noon 20 globala problem, 20 år att lösa dem . ISBN 0-465-07010-8

- Joel Garreau , Radical Evolution , 2005 ( ISBN 978-0385509657 ).

- John A. Leslie (1996). The End of the World ( ISBN 0-415-14043-9 ).

- Joseph Tainter , (1990). The Collapse of Complex Societies , Cambridge University Press , Cambridge, Storbritannien ( ISBN 9780521386739 ).

- Martin Rees (2004). Vår sista timme: En forskares varning: Hur terror, misstag och miljökatastrofer hotar mänsklighetens framtid under detta århundrade – på jorden och bortom . ISBN 0-465-06863-4

- Roger-Maurice Bonnet och Lodewijk Woltjer , Att överleva 1 000 århundraden kan vi göra det? (2008), Springer-Praxis Books.

- Toby Ord (2020). Avgrunden - existentiell risk och mänsklighetens framtid . Bloomsbury Publishing. ISBN 9781526600219

externa länkar

- "Är vi på väg mot civilisationens kollaps?" . BBC . 19 februari 2019.

- MacAskill, William (5 augusti 2022). "The Case for Longtermism" . New York Times .

- "What a way to go" från The Guardian . Tio forskare nämner de största farorna för jorden och bedömer chanserna att de kommer att hända. 14 april 2005.

- Mänskligheten hotas av en perfekt storm av kriser – studera . The Guardian . 6 februari 2020.

- Årsrapporter om global risk av Global Challenges Foundation

- Center på långsiktig risk

- Global katastrofriskpolicy

- Stephen Petranek: 10 ways the world could end , ett TED-föredrag