Teknisk singularitet

|

| Framtidsstudier |

|---|

| Koncept |

| Tekniker |

| Teknikbedömning och prognoser _ |

Den teknologiska singulariteten - eller helt enkelt singulariteten - är en hypotetisk framtida tidpunkt då teknisk tillväxt blir okontrollerbar och oåterkallelig, vilket resulterar i oförutsebara förändringar i den mänskliga civilisationen. Enligt den mest populära versionen av singularitetshypotesen, IJ Goods intelligensexplosionsmodell , kommer en uppgraderbar intelligent agent så småningom att gå in i en "renaway reaktion" av självförbättringscykler, varje ny och mer intelligent generation dyker upp allt snabbare, vilket orsakar en "explosion" i intelligens och som resulterar i en kraftfull superintelligens som kvalitativt vida överträffar all mänsklig intelligens .

Den första personen som använde begreppet en "singularitet" i det tekniska sammanhanget var John von Neumann . Stanislaw Ulam rapporterar en diskussion 1958 med von Neumann "centrerad på de accelererande framstegen inom teknik och förändringar i mänskligt livssätt, vilket ger sken av att närma sig någon väsentlig singularitet i rasens historia bortom vilken mänskliga angelägenheter, som vi känner dem. , kunde inte fortsätta". Efterföljande författare har ekat denna synpunkt.

Konceptet och termen "singularitet" populariserades av Vernor Vinge först 1983 i en artikel som hävdade att när människor skapar intelligenser som är större än sina egna, kommer det att ske en teknisk och social övergång som i någon mening liknar "den knutna rum-tiden" i mitten av ett svart hål", och senare i sin essä 1993 The Coming Technological Singularity , där han skrev att det skulle signalera slutet på den mänskliga eran, eftersom den nya superintelligensen skulle fortsätta att uppgradera sig själv och skulle avancera tekniskt på ett obegriplig takt. Han skrev att han skulle bli förvånad om det inträffade före 2005 eller efter 2030. En annan betydande bidragsgivare till en bredare spridning av begreppet var Ray Kurzweils bok från 2005 The Singularity is Near, som förutsäger singularitet till 2045.

Vissa forskare, inklusive Stephen Hawking , har uttryckt oro över att artificiell superintelligens (ASI) skulle kunna leda till mänsklig utrotning. Konsekvenserna av singulariteten och dess potentiella nytta eller skada för mänskligheten har diskuterats intensivt.

Framstående teknologer och akademiker ifrågasätter rimligheten av en teknisk singularitet och den tillhörande artificiell intelligensexplosion, inklusive Paul Allen , Jeff Hawkins , John Holland , Jaron Lanier , Steven Pinker , Theodore Modis och Gordon Moore . Ett påstående som gjordes var att tillväxten av artificiell intelligens sannolikt kommer att leda till minskande avkastning istället för att accelerera, vilket observerades i tidigare utvecklade mänskliga teknologier.

Intelligensexplosion

Även om den tekniska utvecklingen har accelererat på de flesta områden, har den begränsats av den mänskliga hjärnans grundläggande intelligens, som inte har, enligt Paul R. Ehrlich , förändrats nämnvärt på årtusenden. Men med den ökande kraften hos datorer och annan teknik kan det så småningom vara möjligt att bygga en maskin som är betydligt intelligentare än människor.

Om en övermänsklig intelligens skulle uppfinnas – antingen genom förstärkning av mänsklig intelligens eller genom artificiell intelligens – skulle den avsevärt förbättras jämfört med mänskliga problemlösnings- och uppfinningsfärdigheter. En sådan AI kallas Seed AI eftersom om en AI skapades med tekniska kapaciteter som matchade eller överträffade de mänskliga skaparnas, skulle den ha potential att autonomt förbättra sin egen mjukvara och hårdvara för att designa en ännu mer kapabel maskin, vilket kunde upprepa processen i tur och ordning. Denna rekursiva självförbättring skulle kunna accelerera och möjligen tillåta enorma kvalitativa förändringar innan några övre gränser som påtvingas av fysikens lagar eller teoretiska beräkningar sätts in. Det spekuleras att över många iterationer skulle en sådan AI vida överträffa mänskliga kognitiva förmågor .

IJ Good spekulerade 1965 att artificiell allmän intelligens skulle kunna åstadkomma en intelligensexplosion:

Låt en ultraintelligent maskin definieras som en maskin som vida kan överträffa alla intellektuella aktiviteter hos vilken man än är smart. Eftersom design av maskiner är en av dessa intellektuella aktiviteter, skulle en ultraintelligent maskin kunna designa ännu bättre maskiner; det skulle då utan tvekan bli en "intelligensexplosion", och människans intelligens skulle lämnas långt bakom. Således är den första ultraintelligenta maskinen den sista uppfinningen som människan någonsin behöver göra, förutsatt att maskinen är foglig nog att tala om för oss hur vi ska hålla den under kontroll.

En version av intelligensexplosion är en där datorkraft närmar sig oändligheten på en begränsad tid. I den här versionen, när AI:er gör forskningen för att förbättra sig själva, fördubblas hastigheten t.ex. efter 2 år, sedan 1 år, sedan 6 månader, sedan 3 månader, sedan 1,5 månader, etc., där den oändliga summan av dubbleringsperioderna är 4 år. Om den inte förhindras av fysiska gränser för beräkning och tidskvantisering, skulle denna process bokstavligen uppnå oändlig beräkningskraft på 4 år, och på rätt sätt tjäna namnet "singularitet" för det slutliga tillståndet. Denna form av intelligensexplosion beskrivs i Yudkowsky (1996).

Uppkomsten av superintelligens

En superintelligens, hyperintelligens eller övermänsklig intelligens är en hypotetisk agent som besitter intelligens som vida överträffar de smartaste och mest begåvade mänskliga sinnena. "Superintelligens" kan också hänvisa till formen eller graden av intelligens som en sådan agent besitter. John von Neumann , Vernor Vinge och Ray Kurzweil definierar konceptet i termer av det tekniska skapandet av superintelligens, och hävdar att det är svårt eller omöjligt för dagens människor att förutsäga hur människors liv skulle se ut i en post-singularitetsvärld .

Teknikprognosmakare och forskare är oense om när, eller om, mänsklig intelligens sannolikt kommer att överträffas. Vissa hävdar att framsteg inom artificiell intelligens (AI) förmodligen kommer att resultera i allmänna resonemangssystem som kringgår mänskliga kognitiva begränsningar. Andra tror att människor kommer att utvecklas eller direkt modifiera sin biologi för att uppnå radikalt större intelligens. Ett antal för framtidsstudier kombinerar dessa möjligheter, vilket tyder på att människor sannolikt kommer att kommunicera med datorer , eller ladda upp sina sinnen till datorer, på ett sätt som möjliggör avsevärd intelligensförstärkning. Boken The Age of Em av Robin Hanson beskriver ett hypotetiskt framtidsscenario där mänskliga hjärnor skannas och digitaliseras, vilket skapar "uppladdningar" eller digitala versioner av mänskligt medvetande. I den här framtiden kan utvecklingen av dessa uppladdningar föregå eller sammanfalla med uppkomsten av superintelligent artificiell intelligens.

Icke-AI singularitet

Vissa författare använder "singulariteten" på ett bredare sätt för att hänvisa till alla radikala förändringar i vårt samhälle som åstadkoms av ny teknologi som molekylär nanoteknologi , även om Vinge och andra författare specifikt säger att utan superintelligens skulle sådana förändringar inte kvalificera sig som en sann singularitet .

Hastighetssuperintelligens

En hastighetssuperintelligens beskriver en AI som kan fungera som ett mänskligt sinne, bara mycket snabbare. Till exempel, med en miljonfaldig ökning av hastigheten på informationsbehandlingen i förhållande till människors, skulle ett subjektivt år passera på 30 fysiska sekunder. En sådan skillnad i informationsbehandlingshastighet skulle kunna driva singulariteten.

Förutsägelser

Enligt Chalmers, "Good (1965) förutsäger en ultraintelligent maskin år 2000, Vinge (1993) förutsäger intelligens som är större än människan mellan 2005 och 2030, Yudkowsky (1996) förutsäger en singularitet senast 2021, och Kurszweil) (2005) nivå artificiell intelligens till 2030." Moravec (1988) förutsäger artificiell intelligens på mänsklig nivå i superdatorer till 2010 genom att extrapolera tidigare trender med hjälp av ett diagram, medan Moravec (1998/1999) förutsäger artificiell intelligens på mänsklig nivå år 2040, och intelligens långt bortom mänsklig till 2017. Intervju Per, 2050. Kurzweil förutspår intelligens på mänsklig nivå 2029 och miljardfaldig intelligens och singularitet 2045.

Fyra undersökningar av AI-forskare, utförda 2012 och 2013 av Nick Bostrom och Vincent C. Müller , antydde ett förtroende på 50 % för att artificiell allmän intelligens (AGI) skulle utvecklas 2040–2050.

Rimlighet

Framstående teknologer och akademiker ifrågasätter rimligheten i en teknisk singularitet, inklusive Paul Allen , Jeff Hawkins , John Holland , Jaron Lanier , Steven Pinker , Theodore Modis och Gordon Moore , vars lag ofta citeras till stöd för konceptet.

De flesta föreslagna metoderna för att skapa övermänskliga eller transhumana sinnen delas in i en av två kategorier: intelligensförstärkning av mänskliga hjärnor och artificiell intelligens. De många spekulerade sätten att öka mänsklig intelligens inkluderar bioteknik , genteknik , nootropa läkemedel, AI-assistenter, direkta hjärn-dator-gränssnitt och uppladdning av sinnen . Dessa flera möjliga vägar till en intelligensexplosion, som alla förmodligen kommer att följas, gör en singularitet mer sannolikt.

Robin Hanson uttryckte skepsis mot förstärkning av mänsklig intelligens och skrev att när den "lågthängande frukten" av enkla metoder för att öka mänsklig intelligens har uttömts, kommer ytterligare förbättringar att bli allt svårare. Trots alla spekulerade sätt att förstärka mänsklig intelligens är icke-mänsklig artificiell intelligens (särskilt seed AI) det mest populära alternativet bland de hypoteser som skulle främja singulariteten. [ citat behövs ]

Möjligheten för en underrättelseexplosion beror på tre faktorer. Den första accelererande faktorn är de nya intelligensförbättringarna som möjliggjorts av varje tidigare förbättring. Tvärtom, när intelligenserna blir mer avancerade, kommer ytterligare framsteg att bli mer och mer komplicerade, vilket möjligen uppväger fördelen med ökad intelligens. Varje förbättring bör generera minst en förbättring till, i genomsnitt, för att rörelsen mot singularitet ska fortsätta. Slutligen kan fysikens lagar så småningom förhindra ytterligare förbättringar.

Det finns två logiskt oberoende, men ömsesidigt förstärkande, orsaker till intelligensförbättringar: ökningar i beräkningshastigheten och förbättringar av de algoritmer som används. Den förra förutsägs av Moores lag och de prognostiserade förbättringarna av hårdvaran, och är jämförelsevis lik tidigare tekniska framsteg. Men det finns några AI-forskare, [ vem? ] som tror att mjukvara är viktigare än hårdvara.

En 2017 e-postundersökning av författare med publikationer vid 2015 NeurIPS och ICML maskininlärningskonferenser frågade om chansen att "argumentet om intelligensexplosion är i stort sett korrekt". Av de tillfrågade sa 12% att det var "ganska troligt", 17% sa att det var "sannolikt", 21% sa att det var "ungefär jämnt", 24% sa att det var "osannolikt" och 26% sa att det var "ganska osannolikt". ".

Hastighetsförbättringar

Både för mänsklig och artificiell intelligens ökar hårdvaruförbättringar takten för framtida hårdvaruförbättringar. En analogi till Moores lag antyder att om den första dubbleringen av hastigheten tog 18 månader, skulle den andra ta 18 subjektiva månader; eller 9 externa månader, därefter fyra månader, två månader och så vidare mot en hastighetssingularitet. En viss övre hastighetsgräns kan så småningom nås. Jeff Hawkins har sagt att ett självförbättrande datorsystem oundvikligen skulle stöta på övre gränser för datorkraft: "i slutändan finns det gränser för hur stora och snabba datorer kan köras. Vi skulle hamna på samma plats; vi skulle bara komma dit lite snabbare. Det skulle inte finnas någon singularitet."

Det är svårt att direkt jämföra kiselbaserad hårdvara med neuroner . Men Berglas (2008) noterar att datortaligenkänning närmar sig mänskliga förmågor, och att denna förmåga verkar kräva 0,01 % av hjärnans volym. Denna analogi antyder att modern datorhårdvara är inom några storleksordningar från att vara lika kraftfull som den mänskliga hjärnan.

Exponentiell tillväxt

Den exponentiella tillväxten i datorteknik som föreslås av Moores lag nämns ofta som en anledning att förvänta sig en singularitet inom en relativt nära framtid, och ett antal författare har föreslagit generaliseringar av Moores lag. Datavetaren och framtidsforskaren Hans Moravec föreslog i en bok från 1998 att den exponentiella tillväxtkurvan skulle kunna förlängas tillbaka genom tidigare datorteknik före den integrerade kretsen .

Ray Kurzweil postulerar en lag om accelererande avkastning där hastigheten på tekniska förändringar (och mer generellt, alla evolutionära processer) ökar exponentiellt, och generaliserar Moores lag på samma sätt som Moravecs förslag, och inkluderar även materialteknologi (särskilt när den tillämpas på nanoteknik ) , medicinsk teknik och andra. Mellan 1986 och 2007 fördubblades maskinernas applikationsspecifika kapacitet att beräkna information per capita ungefär var 14:e månad; kapaciteten per capita för världens allmänna datorer har fördubblats var 18:e månad; den globala telekommunikationskapaciteten per capita fördubblades var 34:e månad; och världens lagringskapacitet per capita fördubblades var 40:e månad. Å andra sidan har det hävdats att det globala accelerationsmönstret med 2000-talets singularitet som parameter borde karakteriseras som hyperboliskt snarare än exponentiellt.

Kurzweil reserverar termen "singularitet" för en snabb ökning av artificiell intelligens (i motsats till andra teknologier), och skriver till exempel att "Singulariteten kommer att tillåta oss att överskrida dessa begränsningar av våra biologiska kroppar och hjärnor ... Det kommer inte att göras någon skillnad , post-singularitet, mellan människa och maskin". Han definierar också sitt förutspådda datum för singulariteten (2045) i termer av när han förväntar sig att datorbaserade intelligenser avsevärt överstiger summan av mänsklig hjärnkraft, och skriver att framsteg inom beräkningen före det datumet "inte kommer att representera singulariteten" eftersom de gör det. "Ännu inte motsvarar en djupgående expansion av vår intelligens."

Accelererande förändring

Vissa singularitetsförespråkare hävdar dess oundviklighet genom extrapolering av tidigare trender, särskilt de som hänför sig till att förkorta klyftan mellan förbättringar av teknik. I en av de första användningarna av termen "singularitet" i samband med tekniska framsteg, Stanislaw Ulam om ett samtal med John von Neumann om accelererande förändring:

En konversation kretsade kring den ständigt accelererande teknikens framsteg och förändringar i mänskligt livssätt, vilket ger sken av att närma sig någon väsentlig singularitet i rasens historia bortom vilken mänskliga angelägenheter, som vi känner dem, inte kunde fortsätta.

Kurzweil hävdar att tekniska framsteg följer ett mönster av exponentiell tillväxt , efter vad han kallar " lagen om accelererande avkastning" . Närhelst teknologin närmar sig en barriär, skriver Kurzweil, kommer ny teknik att övervinna den. Han förutspår att paradigmskiften kommer att bli allt vanligare, vilket leder till "tekniska förändringar så snabba och djupgående att de representerar ett brott i mänsklighetens historia". Kurzweil tror att singulariteten kommer att inträffa ungefär 2045. Hans förutsägelser skiljer sig från Vinges genom att han förutspår en gradvis uppstigning till singulariteten, snarare än Vinges snabbt självförbättrande övermänskliga intelligens.

Ofta citerade faror inkluderar de som vanligtvis förknippas med molekylär nanoteknik och genteknik . Dessa hot är viktiga frågor för både singularitetsförespråkare och kritiker, och var föremål för Bill Joys artikel i Wired i april 2000 " Why The Future Doesn't Need Us" .

Algoritmförbättringar

Vissa intelligensteknologier, som "seed AI", kan också ha potentialen att inte bara göra sig snabbare, utan också effektivare, genom att modifiera sin källkod . Dessa förbättringar skulle göra ytterligare förbättringar möjliga, vilket skulle göra ytterligare förbättringar möjliga och så vidare.

Mekanismen för en rekursivt självförbättrande uppsättning algoritmer skiljer sig från en ökning av rå beräkningshastighet på två sätt. För det första kräver det inte extern påverkan: maskiner som designar snabbare hårdvara skulle fortfarande kräva att människor skapar den förbättrade hårdvaran eller programmerar fabriker på lämpligt sätt. [ citat behövs ] En AI som skriver om sin egen källkod kan göra det medan den finns i en AI - box .

För det andra, som med Vernor Vinges uppfattning om singulariteten, är det mycket svårare att förutsäga resultatet. Även om hastighetsökningar bara verkar vara en kvantitativ skillnad från mänsklig intelligens, skulle faktiska algoritmförbättringar vara kvalitativt annorlunda. Eliezer Yudkowsky jämför det med de förändringar som mänsklig intelligens förde med sig: människor förändrade världen tusentals gånger snabbare än evolutionen hade gjort, och på helt andra sätt. På samma sätt var livets evolution en massiv avvikelse och acceleration från de tidigare geologiska förändringshastigheterna, och förbättrad intelligens kan göra att förändringen blir lika annorlunda igen.

Det finns betydande faror förknippade med en intelligensexplosionssingularitet som härrör från en rekursivt självförbättrande uppsättning algoritmer. För det första kan målstrukturen för AI själv modifieras, vilket potentiellt kan få AI:n att optimera för något annat än vad som ursprungligen var tänkt.

För det andra skulle AI:er kunna konkurrera om samma knappa resurser som mänskligheten använder för att överleva. Även om de inte är aktivt skadliga, skulle AI:er främja målen för sin programmering, inte nödvändigtvis bredare mänskliga mål, och kan därför tränga ut människor helt.

Carl Shulman och Anders Sandberg föreslår att algoritmförbättringar kan vara den begränsande faktorn för en singularitet; medan maskinvarueffektiviteten tenderar att förbättras i jämn takt, är mjukvaruinnovationer mer oförutsägbara och kan flaskhalsas av seriell, kumulativ forskning. De föreslår att i fallet med en mjukvarubegränsad singularitet, skulle intelligensexplosion faktiskt bli mer sannolikt än med en hårdvarubegränsad singularitet, eftersom det i det mjukvarubegränsade fallet, när AI på mänsklig nivå väl har utvecklats, kan köras seriellt på mycket snabb hårdvara och överflöd av billig hårdvara skulle göra AI-forskningen mindre begränsad. Ett överflöd av ackumulerad hårdvara som kan släppas lös när mjukvaran kommer på hur den ska användas har kallats "datoröverhäng".

Kritik

Vissa kritiker, som filosofen Hubert Dreyfus och filosofen John Searle , hävdar att datorer eller maskiner inte kan uppnå mänsklig intelligens . Andra, som fysikern Stephen Hawking , invänder att huruvida maskiner kan uppnå en sann intelligens eller bara något som liknar intelligens är irrelevant om nettoresultatet är detsamma.

Psykologen Steven Pinker uttalade 2008: "Det finns inte den minsta anledning att tro på en kommande singularitet. Det faktum att du kan visualisera en framtid i din fantasi är inte bevis på att det är troligt eller ens möjligt. Titta på kupolförsedda städer, jet- packpendling, undervattensstäder, milhöga byggnader och kärnkraftsdrivna bilar – alla häften i futuristiska fantasier när jag var barn som aldrig har kommit. Ren processorkraft är inte ett nissedamm som magiskt löser alla dina problem... "

Martin Ford postulerar en "teknologiparadox" genom att innan singulariteten kunde inträffa skulle de flesta rutinjobb i ekonomin automatiseras, eftersom detta skulle kräva en tekniknivå som är sämre än singulariteten. Detta skulle orsaka massiv arbetslöshet och sjunkande konsumentefterfrågan, vilket i sin tur skulle förstöra incitamentet att investera i den teknik som skulle krävas för att åstadkomma singulariteten. Arbetsförflyttning är i allt högre grad inte längre begränsad till de typer av arbete som traditionellt anses vara "rutin".

Theodore Modis och Jonathan Huebner hävdar att takten för teknisk innovation inte bara har upphört att stiga, utan faktiskt nu minskar. Bevis för denna nedgång är att ökningen av datorklockfrekvenser saktar ner, även medan Moores förutsägelse om exponentiellt ökande kretstäthet fortsätter att hålla. Detta beror på överdriven värmeuppbyggnad från spånet, som inte kan avledas tillräckligt snabbt för att förhindra att spånet smälter vid högre hastigheter. Framsteg i hastighet kan vara möjliga i framtiden tack vare mer energieffektiva CPU-designer och flercellsprocessorer.

Theodore Modis menar att singulariteten inte kan hända. Han hävdar att den "teknologiska singulariteten" och särskilt Kurzweil saknar vetenskaplig rigor; Kurzweil påstås förväxla den logistiska funktionen (S-funktionen) för en exponentiell funktion, och att se ett "knä" i en exponentiell funktion där det faktiskt inte kan finnas något sådant. I en artikel från 2021 påpekade Modis att inga milstolpar – brott i historiskt perspektiv jämförbara i betydelse med Internet, DNA, transistorn eller kärnenergi – hade observerats under de senaste tjugo åren medan fem av dem skulle ha förväntats enligt den exponentiella trend som förespråkas av den tekniska singularitetens förespråkare.

AI-forskaren Jürgen Schmidhuber konstaterade att frekvensen av subjektivt "anmärkningsvärda händelser" verkar närma sig en singularitet från 2000-talet, men varnade läsarna att ta sådana plotter av subjektiva händelser med en nypa salt: kanske skillnader i minnet av senaste och avlägsna händelser kan skapa en illusion av accelererande förändring där ingen existerar.

Microsofts grundare Paul Allen hävdade motsatsen till accelererande avkastning, komplexitetsbromsen; ju mer framsteg vetenskapen gör mot att förstå intelligens, desto svårare blir det att göra ytterligare framsteg. En studie av antalet patent visar att mänsklig kreativitet inte visar på accelererande avkastning, utan faktiskt, som Joseph Tainter föreslog i hans The Collapse of Complex Societies , en lag om minskande avkastning . Antalet patent promille nådde en topp under perioden 1850 till 1900 och har minskat sedan dess. Tillväxten av komplexitet blir så småningom självbegränsande och leder till en utbredd "allmän systemkollaps".

Hofstadter (2006) väcker oro för att Ray Kurzweil inte är tillräckligt vetenskapligt noggrann, att en exponentiell tekniktendens inte är en vetenskaplig lag som fysikens, och att exponentiella kurvor inte har några "knän". Ändå utesluter han inte singulariteten i princip inom en avlägsen framtid.

Jaron Lanier förnekar att singulariteten är oundviklig: "Jag tror inte att tekniken skapar sig själv. Det är inte en autonom process." Vidare: "Skälet till att tro på mänsklig handlingsfrihet framför teknologisk determinism är att man då kan ha en ekonomi där människor tjänar sitt eget sätt och uppfinner sina egna liv. Om man strukturerar ett samhälle på att inte betona individuell mänsklig handlingsfrihet är det samma sak operativt . eftersom att förneka människor inflytande, värdighet och självbestämmande ... att omfamna [idén om singulariteten] skulle vara en hyllning till dålig data och dålig politik."

Ekonomen Robert J. Gordon påpekar att den uppmätta ekonomiska tillväxten har avtagit runt 1970 och avtagit ytterligare sedan finanskrisen 2007–2008, och hävdar att de ekonomiska data inte visar några spår av en kommande singularitet som föreställts av matematikern IJ Good .

Filosofen och kognitionsforskaren Daniel Dennett sa 2017: "Hela singularitetsgrejen, det är absurt. Det distraherar oss från mycket mer pressande problem", och tillägger "AI-verktyg som vi blir hyperberoende av, som kommer att hända. Och en av Farorna är att vi kommer att ge dem mer auktoritet än de motiverar."

Förutom allmän kritik av singularitetskonceptet har flera kritiker tagit upp problem med Kurzweils ikoniska diagram. En kritik är att ett log-log- diagram av denna karaktär i sig är partiskt mot ett rätlinjeresultat. Andra identifierar urvalsbias i de punkter som Kurzweil väljer att använda. påpekar biologen PZ Myers att många av de tidiga evolutionära "händelserna" valdes godtyckligt. Kurzweil har motbevisat detta genom att kartlägga evolutionära händelser från 15 neutrala källor och visa att de passar en rak linje på ett log-loggdiagram . Kelly (2006) menar att hur Kurzweil-diagrammet är konstruerat med x-axeln med tid före nutid, pekar det alltid på att singulariteten är "nu", för vilket datum man skulle konstruera ett sådant diagram, och visar detta visuellt på Kurzweils diagram.

Vissa kritiker föreslår religiösa motiv eller implikationer av singularitet, särskilt Kurzweils version av det. Uppbyggnaden mot singulariteten jämförs med judisk-kristna sluttidsscenarier. Beam kallar det "en Buck Rogers vision av den hypotetiska Christian Rapture". John Gray säger "Singulariteten ekar apokalyptiska myter där historien är på väg att avbrytas av en världsomvandlande händelse".

Potentiella effekter

Dramatiska förändringar i den ekonomiska tillväxttakten har inträffat tidigare på grund av tekniska framsteg. Baserat på befolkningstillväxt fördubblades ekonomin vart 250 000:e år från den paleolitiska eran fram till den neolitiska revolutionen . Den nya jordbruksekonomin fördubblades vart 900:e år, en anmärkningsvärd ökning. I den nuvarande eran, som börjar med den industriella revolutionen, fördubblas världens ekonomiska produktion vart femtonde år, sextio gånger snabbare än under jordbrukseran. Om uppkomsten av övermänsklig intelligens orsakar en liknande revolution, hävdar Robin Hanson, skulle man förvänta sig att ekonomin fördubblas åtminstone kvartalsvis och möjligen på veckobasis.

Osäkerhet och risk

Termen "teknologisk singularitet" speglar tanken att en sådan förändring kan ske plötsligt och att det är svårt att förutsäga hur den resulterande nya världen skulle fungera. Det är oklart om en underrättelseexplosion som resulterar i en singularitet skulle vara fördelaktig eller skadlig, eller till och med ett existentiellt hot . Eftersom AI är en viktig faktor i singularitetsrisk, följer ett antal organisationer en teknisk teori för att anpassa AI-målsystem med mänskliga värderingar, inklusive Future of Humanity Institute , Machine Intelligence Research Institute , Center for Human-Compatible Artificial Intelligence , och Future of Life Institute .

Fysikern Stephen Hawking sa 2014 att "Framgång med att skapa AI skulle vara den största händelsen i mänsklighetens historia. Tyvärr kan det också bli den sista, om vi inte lär oss hur vi ska undvika riskerna." Hawking trodde att under de kommande decennierna skulle AI kunna erbjuda "oöverskådliga fördelar och risker" som "teknik som överlistar finansmarknaderna, utfinner mänskliga forskare, utmanipulerar mänskliga ledare och utvecklar vapen som vi inte ens kan förstå." Hawking föreslog att artificiell intelligens borde tas på större allvar och att mer borde göras för att förbereda sig för singulariteten:

Så, inför möjliga framtider med oöverskådliga fördelar och risker, gör experterna säkert allt för att säkerställa det bästa resultatet, eller hur? Fel. Om en överlägsen utomjordisk civilisation skickade ett meddelande till oss som sa: "Vi kommer om några decennier," skulle vi bara svara, "OK, ring oss när du kommer hit - vi lämnar lamporna tända"? Förmodligen inte – men det här är mer eller mindre vad som händer med AI.

Berglas (2008) hävdar att det inte finns någon direkt evolutionär motivation för en AI att vara vänlig mot människor. Evolution har ingen inneboende tendens att producera resultat som värderas av människor, och det finns liten anledning att förvänta sig att en godtycklig optimeringsprocess ska främja ett resultat som mänskligheten önskar, snarare än att oavsiktligt leda till att en AI beter sig på ett sätt som inte var avsett av dess skapare. Anders Sandberg har också utvecklat detta scenario och tagit upp olika vanliga motargument. AI-forskaren Hugo de Garis föreslår att artificiell intelligens helt enkelt kan eliminera mänskligheten för tillgång till knappa resurser , och människor skulle vara maktlösa att stoppa dem. Alternativt kan AI som utvecklats under evolutionärt tryck för att främja sin egen överlevnad konkurrera ut mänskligheten.

Bostrom (2002) diskuterar scenarier för mänsklig utrotning och listar superintelligens som en möjlig orsak:

När vi skapar den första superintelligenta entiteten kan vi göra ett misstag och ge den mål som leder den till att förinta mänskligheten, förutsatt att dess enorma intellektuella fördel ger den kraften att göra det. Till exempel kan vi av misstag höja ett delmål till status som ett supermål. Vi säger åt den att lösa ett matematiskt problem, och det överensstämmer genom att förvandla all materia i solsystemet till en gigantisk beräkningsenhet, i processen att döda personen som ställde frågan.

Enligt Eliezer Yudkowsky är ett betydande problem inom AI-säkerhet att ovänlig artificiell intelligens sannolikt är mycket lättare att skapa än vänlig AI. Även om båda kräver stora framsteg inom rekursiv optimeringsprocessdesign, kräver vänlig AI också förmågan att göra målstrukturer oföränderliga under självförbättring (eller så kan AI:n förvandla sig till något ovänligt) och en målstruktur som överensstämmer med mänskliga värderingar och inte automatiskt förstöra mänskligheten. En ovänlig AI kan å andra sidan optimera för en godtycklig målstruktur, som inte behöver vara oföränderlig under självmodifiering. Bill Hibbard (2014) föreslår en AI-design som undviker flera faror inklusive självbedrägeri, oavsiktliga instrumentella handlingar och korruption av belöningsgeneratorn. Han diskuterar också sociala effekter av AI och testning av AI. Hans bok Super-Intelligent Machines från 2001 förespråkar behovet av offentlig utbildning om AI och offentlig kontroll över AI. Den föreslog också en enkel design som var sårbar för korruption av belöningsgeneratorn.

Nästa steg i sociobiologisk evolution

Medan den tekniska singulariteten vanligtvis ses som en plötslig händelse, hävdar vissa forskare att den nuvarande förändringshastigheten redan stämmer överens med denna beskrivning. [ citat behövs ]

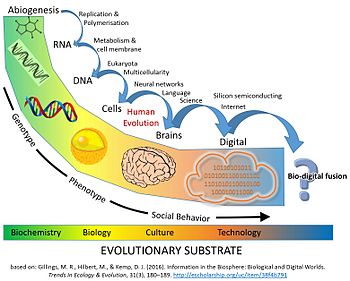

Dessutom hävdar vissa att vi redan är mitt uppe i en stor evolutionär övergång som förenar teknologi, biologi och samhälle. Digital teknik har infiltrerat det mänskliga samhällets struktur till en grad av obestridligt och ofta livsuppehållande beroende.

En artikel från 2016 i Trends in Ecology & Evolution hävdar att "människor redan omfamnar fusioner av biologi och teknologi. Vi spenderar större delen av vår vakna tid på att kommunicera via digitalt medierade kanaler... vi litar på artificiell intelligens med våra liv genom låsningsfria bromsar i bilar och autopiloter i flygplan... Med ett av tre äktenskap i Amerika som börjar online, tar digitala algoritmer också en roll i människopars bindning och reproduktion".

Artikeln hävdar vidare att ur evolutionens perspektiv har flera tidigare stora övergångar i evolutionen förändrat livet genom innovationer inom informationslagring och replikering ( RNA , DNA , multicellularitet och kultur och språk ). I det nuvarande skedet av livets evolution har den kolbaserade biosfären genererat ett kognitivt system (människor) som kan skapa teknologi som kommer att resultera i en jämförbar evolutionär övergång .

Den digitala information som skapats av människor har nått en liknande storlek som biologisk information i biosfären. Sedan 1980-talet har mängden lagrad digital information fördubblats ungefär vart 2,5 år och nådde cirka 5 zettabyte 2014 (5 × 10 21 byte).

I biologiska termer finns det 7,2 miljarder människor på planeten, som var och en har ett genom på 6,2 miljarder nukleotider. Eftersom en byte kan koda för fyra nukleotidpar, kan de individuella genomen av varje människa på planeten kodas med ungefär 1 × 10 19 byte. Den digitala sfären lagrade 500 gånger mer information än så här under 2014 (se figur). Den totala mängden DNA som finns i alla celler på jorden uppskattas till cirka 5,3 × 10 37 baspar, vilket motsvarar 1,325 × 10 37 byte information.

Om tillväxten inom digital lagring fortsätter med sin nuvarande takt på 30–38 % sammansatt årlig tillväxt per år, kommer den att konkurrera med det totala informationsinnehållet som finns i allt DNA i alla celler på jorden om cirka 110 år. Detta skulle representera en fördubbling av mängden information som lagras i biosfären över en total tidsperiod på bara 150 år."

Implikationer för det mänskliga samhället

I februari 2009, under ledning av Association for the Advancement of Artificial Intelligence (AAAI), ledde Eric Horvitz ett möte för ledande datavetare, artificiell intelligensforskare och robotiker vid Asilomar i Pacific Grove, Kalifornien. Målet var att diskutera den potentiella effekten av den hypotetiska möjligheten att robotar skulle kunna bli självförsörjande och kunna fatta sina egna beslut. De diskuterade i vilken utsträckning datorer och robotar skulle kunna förvärva autonomi , och i vilken grad de kunde använda sådana förmågor för att utgöra hot eller faror.

Vissa maskiner är programmerade med olika former av semi-autonomi, inklusive möjligheten att lokalisera sina egna kraftkällor och välja mål att attackera med vapen. Vissa datavirus kan också undvika eliminering och, enligt närvarande forskare, kan de därför sägas ha nått ett "kackerlacka"-stadium av maskinintelligens. Konferensdeltagarna noterade att självmedvetenhet som avbildas i science-fiction förmodligen är osannolik, men att det finns andra potentiella faror och fallgropar.

Frank S. Robinson förutspår att när människor uppnår en maskin med intelligensen hos en människa, kommer vetenskapliga och tekniska problem att tacklas och lösas med hjärnkraft som är mycket överlägsen människors. Han noterar att artificiella system kan dela data mer direkt än människor, och förutspår att detta skulle resultera i ett globalt nätverk av superintelligens som skulle dvärga mänsklig förmåga. Robinson diskuterar också hur mycket annorlunda framtiden potentiellt skulle se ut efter en sådan underrättelseexplosion. Ett exempel på detta är solenergi, där jorden tar emot mycket mer solenergi än vad mänskligheten fångar, så att fånga mer av den solenergin skulle ha ett stort löfte för civilisationstillväxt.

Hård vs. mjuk start

I ett scenario med hård start, förbättras en AGI snabbt själv, "tar kontroll" över världen (kanske på några timmar), för snabbt för betydande mänskligt initierad felkorrigering eller för en gradvis justering av AGI:s mål. I ett mjukt startscenario blir AGI fortfarande mycket kraftfullare än mänskligheten, men i en mänsklig takt (kanske i storleksordningen decennier), på en tidsskala där pågående mänsklig interaktion och korrigering effektivt kan styra AGI:s utveckling.

Ramez Naam argumenterar mot en hård start. Han har påpekat att vi redan ser rekursiv självförbättring av superintelligenser, såsom företag. Intel , till exempel, har "den kollektiva hjärnkraften hos tiotusentals människor och förmodligen miljontals CPU-kärnor för att... designa bättre processorer!" Detta har dock inte lett till en hård start; snarare har det lett till en mjuk start i form av Moores lag . Naam påpekar vidare att den beräkningsmässiga komplexiteten hos högre intelligens kan vara mycket större än linjär, så att "att skapa ett sinne av intelligens 2 är förmodligen mer än dubbelt så svårt som att skapa ett sinne av intelligens 1."

J. Storrs Hall menar att "många av de mer vanligt förekommande scenarierna för hård start över natten är cirkulära – de verkar anta hypermänskliga förmågor vid startpunkten för självförbättringsprocessen" för att en AI ska kunna göra det dramatiska , domängenerella förbättringar som krävs för start. Hall föreslår att snarare än att rekursivt självförbättra sin hårdvara, mjukvara och infrastruktur på egen hand, skulle en ny AI vara bättre att specialisera sig på ett område där den var mest effektiv och sedan köpa de återstående komponenterna på marknaden, eftersom kvaliteten av produkter på marknaden förbättras ständigt, och AI skulle ha svårt att hålla jämna steg med den spetsteknologi som används av resten av världen.

Ben Goertzel håller med Halls förslag att en ny AI på mänsklig nivå skulle göra klokt i att använda sin intelligens för att samla rikedomar. AI:s talanger kan inspirera företag och regeringar att sprida sin mjukvara i samhället. Goertzel är skeptisk till en hård fem minuters start men spekulerar i att en start från mänsklig till övermänsklig nivå i storleksordningen fem år är rimlig. Goerzel hänvisar till detta scenario som en "halvhård start".

Max More håller inte med och hävdar att om det bara fanns ett fåtal supersnabba AI:er på mänsklig nivå, skulle de inte radikalt förändra världen, eftersom de fortfarande skulle vara beroende av andra människor för att få saker gjorda och fortfarande skulle ha mänskliga kognitiva begränsningar. Även om alla supersnabba AI:er arbetade med intelligensökning, är det oklart varför de skulle klara sig bättre på ett diskontinuerligt sätt än existerande mänskliga kognitiva vetenskapsmän på att producera övermänsklig intelligens, även om framstegshastigheten skulle öka. More hävdar vidare att en superintelligens inte skulle förändra världen över en natt: en superintelligens skulle behöva engagera sig med existerande, långsamma mänskliga system för att åstadkomma fysiska effekter på världen. "Behovet av samarbete, av organisation och av att omsätta idéer i fysiska förändringar kommer att säkerställa att alla gamla regler inte slängs ut över en natt eller ens inom några år."

Odödlighet

Drexler (1986), en av nanoteknologins grundare , postulerar cellreparationsanordningar, inklusive sådana som arbetar inom celler och använder ännu hypotetiska biologiska maskiner . Enligt Richard Feynman var det hans tidigare doktorand och samarbetspartner Albert Hibbs som ursprungligen föreslog honom (cirka 1959) idén om en medicinsk användning av Feynmans teoretiska mikromaskiner. Hibbs föreslog att vissa reparationsmaskiner en dag skulle kunna reduceras i storlek till den grad att det i teorin skulle vara möjligt att (som Feynman uttryckte det) " svälja läkaren" . Idén införlivades i Feynmans essä 1959 There's Plenty of Room at the Bottom .

Moravec (1988) förutspår möjligheten att "ladda upp" det mänskliga sinnet till en människoliknande robot, och uppnå kvasi-odödlighet genom extrem livslängd via överföring av det mänskliga sinnet mellan på varandra följande nya robotar och de gamla slits ut; utöver det förutsäger han senare exponentiell acceleration av subjektiv tidsupplevelse som leder till subjektiv känsla av odödlighet.

Kurzweil (2005) föreslår att medicinska framsteg skulle göra det möjligt för människor att skydda sina kroppar från effekterna av åldrande, vilket gör den förväntade livslängden obegränsad . Kurzweil hävdar att de tekniska framstegen inom medicin skulle tillåta oss att kontinuerligt reparera och ersätta defekta komponenter i våra kroppar, vilket förlänger livet till en obestämd ålder. Kurzweil stödjer sitt argument ytterligare genom att diskutera aktuella biotekniska framsteg. Kurzweil föreslår somatisk genterapi ; efter syntetiska virus med specifik genetisk information, skulle nästa steg vara att tillämpa denna teknik på genterapi och ersätta mänskligt DNA med syntetiserade gener.

Förutom att bara förlänga den fysiska kroppens operativa liv, argumenterar Jaron Lanier för en form av odödlighet som kallas "Digital Ascension" som innebär att "människor dör i köttet och laddas upp till en dator och förblir medvetna."

Begreppets historia

En artikel av Mahendra Prasad, publicerad i AI Magazine , hävdar att 1700-talsmatematikern Marquis de Condorcet var den första personen som antog och matematiskt modellerade en intelligensexplosion och dess effekter på mänskligheten.

En tidig beskrivning av idén gjordes i John W. Campbells novell från 1932 "The last evolution".

I sin dödsruna för John von Neumann från 1958 påminde Ulam om ett samtal med von Neumann om "de ständigt accelererande framstegen inom teknik och förändringar i mänskligt livssätt, vilket ger sken av att närma sig någon väsentlig singularitet i rasens historia bortom vilken mänskliga angelägenheter, som vi känner dem, kunde inte fortsätta."

1965 skrev Good sin uppsats där han postulerade en "intelligensexplosion" av rekursiv självförbättring av en maskinintelligens.

1977 skrev Hans Moravec en artikel med oklar publiceringsstatus där han föreställde sig en utveckling av självförbättrande tänkande maskiner, ett skapande av "supermedvetande, syntesen av jordelivet, och kanske också det jovianska livet och livet på mars, ständigt förbättrande och utsträcker sig, sprider sig utåt från solsystemet, omvandlar icke-liv till sinne." Artikeln beskriver det mänskliga sinnet som laddas upp senare i Moravec (1988). Maskinerna kommer att nå mänsklig nivå och sedan förbättra sig själva utöver det ("Det viktigaste av allt är att de [maskinerna] kan sättas i arbete som programmerare och ingenjörer, med uppgiften att optimera mjukvaran och hårdvaran som gör dem till vad de De på varandra följande generationerna av maskiner som produceras på detta sätt kommer att bli allt smartare och mer kostnadseffektiva.") Människor kommer inte längre att behövas, och kommer att bli omkörda av maskinerna: "I det långa loppet är den rena fysiska oförmågan hos människor att hänga med. med dessa snabbt utvecklande avkommor till våra sinnen kommer vi att säkerställa att förhållandet mellan människor och maskiner närmar sig noll, och att en direkt ättling till vår kultur, men inte våra gener, ärver universum." Medan ordet "singularitet" inte används, finns föreställningen om tänkande maskiner på mänsklig nivå som därefter förbättrar sig själva bortom mänsklig nivå. Det finns ingen intelligensexplosion i betydelsen en mycket snabb intelligensökning när mänsklig likvärdighet nås. En uppdaterad version av artikeln publicerades 1979 i Analog Science Fiction and Fact .

1981 publicerade Stanisław Lem sin science fiction -roman Golem XIV . Den beskriver en militär AI-dator (Golem XIV) som får medvetande och börjar öka sin egen intelligens och går mot personlig teknisk singularitet. Golem XIV skapades ursprungligen för att hjälpa sina byggare att bekämpa krig, men när dess intelligens avancerar till en mycket högre nivå än människors, slutar den att intressera sig för de militära kraven eftersom den upptäcker att de saknar intern logisk konsekvens.

1983 tog Vernor Vinge upp Goods intelligensexplosion i tryck i januarinumret 1983 av Omni magazine. I detta opederade stycke verkar Vinge ha varit den första att använda termen "singularitet" (även om den inte "teknologisk singularitet") på ett sätt som var specifikt knutet till skapandet av intelligenta maskiner:

Vi kommer snart att skapa intelligenser större än vår egen. När detta händer kommer mänsklighetens historia att ha nått ett slags singularitet, en intellektuell övergång lika ogenomtränglig som den knutna rumtiden i mitten av ett svart hål, och världen kommer att passera långt bortom vår förståelse. Denna singularitet tror jag redan hemsöker ett antal science fiction-författare. Det gör realistisk extrapolering till en interstellär framtid omöjlig. För att skriva en berättelse som utspelar sig mer än ett sekel framåt, behöver man ett kärnvapenkrig däremellan ... så att världen förblir begriplig.

År 1985, i "The Time Scale of Artificial Intelligence", artikulerade artificiell intelligensforskaren Ray Solomonoff matematiskt den relaterade föreställningen om vad han kallade en "oändlighetspunkt": om en forskargemenskap av självförbättrande AI på mänsklig nivå tar fyra år att fördubblas deras egen hastighet, sedan två år, sedan ett år och så vidare, deras förmågor ökar oändligt med begränsad tid.

1986 publicerade Vernor Vinge Marooned in Realtime , en science-fiction-roman där några få kvarvarande människor som reser framåt i framtiden har överlevt en okänd utrotningshändelse som mycket väl kan vara en singularitet. I ett kort efterord säger författaren att en verklig teknologisk singularitet inte skulle vara slutet för den mänskliga arten: "naturligtvis verkar det mycket osannolikt att singulariteten skulle vara en ren försvinnande av mänskligheten. (Å andra sidan, t.ex. en försvinnande är den tidslika analogen till tystnaden vi finner över hela himlen.)".

1988 använde Vinge uttrycket "technological singularity" (inklusive "technological") i novellsamlingen Threats and Other Promises , och skrev i inledningen till sin berättelse "The Whirligig of Time" (s. 72): Barring a worldwide catastrophe. , Jag tror att tekniken kommer att uppnå våra vildaste drömmar, och det snart. När vi höjer vår egen intelligens och våra skapelsers, är vi inte längre i en värld av karaktärer av mänsklig storlek. Vid den punkten har vi hamnat i ett tekniskt "svart hål", en teknisk singularitet.

1988 publicerade Hans Moravec Mind Children , där han förutspådde intelligens på mänsklig nivå i superdatorer år 2010, självförbättrande intelligenta maskiner som vida överträffar mänsklig intelligens senare, mänskligt sinne laddas upp i mänskliga robotar senare, intelligenta maskiner som lämnar människor bakom sig, och rymdkolonisering. Han nämnde dock inte "singularitet", och han talade inte om en snabb explosion av intelligens direkt efter att den mänskliga nivån uppnåtts. Icke desto mindre finns den övergripande singularitetens tenor i att förutsäga både artificiell intelligens på mänsklig nivå och ytterligare artificiell intelligens som vida överträffar människor senare.

Vinges artikel från 1993 "The Coming Technological Singularity: How to Survive in the Post-Human Era", spreds brett på internet och hjälpte till att popularisera idén. Den här artikeln innehåller uttalandet, "Inom trettio år kommer vi att ha de tekniska medlen för att skapa övermänsklig intelligens. Kort därefter kommer den mänskliga eran att avslutas." Vinge hävdar att science fiction-författare inte kan skriva realistiska post-singularitetskaraktärer som överträffar det mänskliga intellektet, eftersom tankarna hos ett sådant intellekt skulle vara bortom människors förmåga att uttrycka.

Minskys artikel från 1994 säger att robotar kommer att "ärva jorden", möjligen med användning av nanoteknik, och föreslår att man ska tänka på robotar som mänskliga "sinnebarn", med liknelsen från Moravec. Den retoriska effekten av den analogin är att om det går bra för människor att överlämna världen till sina biologiska barn, borde de ha lika bra möjligheter att överlämna den till robotar, deras "sinne"-barn. Enligt Minsky skulle vi kunna designa våra "sinnebarn" att tänka en miljon gånger snabbare än vi gör. För en sådan varelse kan en halv minut tyckas lika lång som ett av våra år, och varje timme lika lång som ett helt mänskligt liv.' Utmärkande för singulariteten som finns hos Minsky är utvecklingen av övermänsklig artificiell intelligens ("miljoner gånger snabbare"), men det är inget tal om plötslig intelligensexplosion, självförbättrande tänkande maskiner eller oförutsägbarhet bortom någon specifik händelse och ordet "singularitet" används inte.

Tiplers bok The Physics of Immortality från 1994 förutspår framtiden där superintelligenta maskiner kommer att bygga enormt kraftfulla datorer, människor kommer att "emuleras" i datorer, livet kommer att nå varje galax och människor kommer att uppnå odödlighet när de når Omega Point . Det talas inte om Vingean "singularitet" eller plötslig intelligensexplosion, men intelligens som är mycket större än människan finns där, liksom odödlighet.

1996 förutspådde Yudkowsky en singularitet till 2021. Hans version av singularitet involverar intelligensexplosion: när AI:er gör forskningen för att förbättra sig, fördubblas hastigheten efter 2 år, sedan 1 ett år, sedan efter 6 månader, sedan efter 3 månader, sedan efter 1,5 månader, och efter fler iterationer, uppnås "singulariteten". Denna konstruktion innebär att hastigheten når oändligheten på ändlig tid.

År 2000 uttryckte Bill Joy , en framstående teknolog och en av grundarna av Sun Microsystems , oro över de potentiella farorna med robotik, genteknik och nanoteknik.

2005 publicerade Kurzweil The Singularity Is Near . Kurzweils reklamkampanj inkluderade ett framträdande på The Daily Show med Jon Stewart .

Från 2006 till 2012 anordnades den årliga Singularity Summit- konferensen av Machine Intelligence Research Institute , grundat av Eliezer Yudkowsky .

År 2007 föreslog Eliezer Yudkowsky att många av de olika definitionerna som har tilldelats "singularitet" är ömsesidigt oförenliga snarare än ömsesidigt stödjande. Kurzweil extrapolerar till exempel nuvarande tekniska banor förbi ankomsten av självförbättrande AI eller övermänsklig intelligens, vilket Yudkowsky hävdar representerar en spänning med både IJ Goods föreslagna diskontinuerliga uppsving i intelligens och Vinges tes om oförutsägbarhet.

2009 tillkännagav Kurzweil och X-Prize- grundaren Peter Diamandis etableringen av Singularity University , ett icke-ackrediterat privat institut vars uttalade uppdrag är "att utbilda, inspirera och ge ledare möjlighet att tillämpa exponentiell teknologi för att möta mänsklighetens stora utmaningar." Singularity University finansieras av Google , Autodesk , ePlanet Ventures och en grupp ledare inom teknikbranschen och är baserat på NASAs Ames Research Center i Mountain View , Kalifornien . Den ideella organisationen driver ett årligt tioveckors forskarutbildningsprogram under sommaren som täcker tio olika teknik- och allierade spår, och en serie executive-program under hela året.

I politiken

År 2007 släppte den gemensamma ekonomiska kommittén för USA:s kongress en rapport om framtiden för nanoteknik. Den förutspår betydande tekniska och politiska förändringar på medellång sikt, inklusive eventuell teknisk singularitet.

Förenta staternas tidigare president Barack Obama talade om singularitet i sin intervju med Wired 2016:

En sak som vi inte har pratat om för mycket, och jag vill bara gå tillbaka till, är att vi verkligen måste tänka igenom de ekonomiska konsekvenserna. Eftersom de flesta människor inte spenderar mycket tid just nu på att oroa sig för singularitet – de oroar sig för "Ja, kommer mitt jobb att ersättas av en maskin?"

Se även

- Accelererande förändring – Upplevd ökning i takten av tekniska förändringar genom historien

- Artificiellt medvetande – Fält inom kognitionsvetenskap

- Vapenkapplöpning med artificiell intelligens – Vapenkapplöpning för de mest avancerade AI-relaterade teknologierna

- Artificiell intelligens i skönlitteratur – Artificiell intelligens som avbildas i skönlitterära verk

- Hjärnsimulering – Koncept att skapa en fungerande datormodell av en hjärna eller del av en hjärna

- Hjärna–datorgränssnitt – Direkt kommunikationsväg mellan en förbättrad eller trådbunden hjärna och en extern enhet

- Framväxande teknologier – Teknologier vars utveckling, praktiska tillämpningar eller båda är fortfarande i stort sett orealiserade

- Efemeralisering – Teknologisk framstegsteori

- Fermi paradox – Brist på bevis för att utomjordingar existerar

- Flynn-effekten – 1900-talets ökning av den totala mänskliga intelligensen

- Framtidsstudier – Studie av att postulera möjliga, sannolika och föredragna framtider

- Global hjärna – Futuristiskt koncept för ett globalt sammankopplat nätverk

- Mänsklig intelligens § Förbättra intelligens

- Sinneuppladdning – Hypotetisk process för att digitalt emulera en hjärna

- Neuroförstärkning

- Robotinlärning

- Singularitarism – Tro på en begynnande teknisk singularitet

- Teknologisk determinism – reduktionistisk teori

- Teknisk revolution – Period av snabba tekniska förändringar

- Teknologisk arbetslöshet – Arbetslöshet orsakad av tekniska förändringar

- Transhumanism – Filosofisk rörelse

Citat

Källor

- Kurzweil, Ray (2005). Singulariteten är nära . New York, NY: Penguin Group. ISBN 9780715635612 .

- William D. Nordhaus , "Why Growth Will Fall" (en recension av Robert J. Gordon , The Rise and Fall of American Growth: The US Standard of Living Since the Civil War, Princeton University Press, 2016, ISBN 978-0691147727 , 762 s., $39,95), The New York Review of Books , vol. LXIII, nr. 13 (18 augusti 2016), s. 64, 66, 68.

- John R. Searle , "What Your Computer Can't Know" (recension av Luciano Floridi , The Fourth Revolution: How the Infosphere Is Reshaping Human Reality , Oxford University Press, 2014; och Nick Bostrom , Superintelligence: Paths, Dangers, Strategies , Oxford University Press, 2014), The New York Review of Books , vol. LXI, nej. 15 (9 oktober 2014), s. 52–55.

- Good, IJ (1965), "Spekulationer angående den första ultraintelligenta maskinen", i Franz L. Alt; Morris Rubinoff (red.), Advances in Computers Volym 6 , Advances in Computers, vol. 6, Academic Press , s. 31–88, doi : 10.1016 /S0065-2458(08)60418-0 , hdl : 10919/89424 , ISBN 9780120121069 , originalarkivet 020-020 hämtat 020-020 -08- 07 från

- Hanson, Robin (1998), Some Skepticism , Robin Hanson, arkiverad från originalet 2009-08-28 , hämtad 2009-06-19

- Berglas, Anthony (2008), Artificial Intelligence will Kill our Grandchildren , arkiverad från originalet 2014-07-23 , hämtad 2008-06-13

- Bostrom, Nick (2002), "Existential Risks" , Journal of Evolution and Technology , 9 , arkiverad från originalet 2011-04-27 , hämtad 2007-08-07

- Hibbard, Bill (5 november 2014). "Etisk artificiell intelligens". arXiv : 1411.1373 [ cs.AI ].

Vidare läsning

- Krüger, Oliver , Virtual Immortality. Gud, evolutionen och singulariteten i post- och transhumanism. , Bielefeld: avskrift 2021. ISBN 978-3-8376-5059-4

- Marcus, Gary , "Är jag människa?: Forskare behöver nya sätt att skilja artificiell intelligens från den naturliga sorten", Scientific American , vol. 316, nr. 3 (mars 2017), s. 58–63. Flera tester av artificiell intelligenss effektivitet behövs eftersom, "precis som det inte finns något enskilt test av atletisk skicklighet, kan det inte finnas ett ultimat test av intelligens." Ett sådant test, en "Construction Challenge", skulle testa perception och fysisk handling - "två viktiga delar av intelligent beteende som var helt frånvarande från det ursprungliga Turing-testet ." Ett annat förslag har varit att ge maskiner samma standardiserade test av naturvetenskap och andra discipliner som skolbarn gör. En hittills oöverstiglig stötesten för artificiell intelligens är en oförmåga till tillförlitlig disambiguering . "[V] nästan varje mening [som folk genererar] är tvetydig , ofta på flera sätt." Ett framträdande exempel är känt som "problemet med att disambiguera pronomen": en maskin har inget sätt att avgöra till vem eller vad ett pronomen i en mening - som "han", "hon" eller "det" - refererar till.

- Scaruffi, Piero , "Intelligence is not Artificial" (2016) för en kritik av singularitetsrörelsen och dess likheter med religiösa kulter.

externa länkar

- singularitet | teknologi , britannica.com

- The Coming Technological Singularity: How to Survive in the Post-Human Era (på Vernor Vinges webbplats, hämtad juli 2019)

- Intelligence Explosion FAQ från Machine Intelligence Research Institute

- Blogg om bootstrapping av artificiell intelligens av Jacques Pitrat

- Varför en underrättelseexplosion är trolig (mars 2011)

- Varför en intelligensexplosion är omöjlig (november 2017)

- Hur nära är vi teknisk singularitet och när?