Robust statistik

Robust statistik är statistik med bra prestanda för data hämtade från ett brett spektrum av sannolikhetsfördelningar , särskilt för fördelningar som inte är normala . Robusta statistiska metoder har utvecklats för många vanliga problem, som att uppskatta plats , skala och regressionsparametrar . En motivering är att ta fram statistiska metoder som inte påverkas i onödan av extremvärden . En annan motivering är att ge metoder med bra prestanda när det finns små avvikelser från en parametrisk fördelning . Till exempel fungerar robusta metoder bra för blandningar av två normalfördelningar med olika standardavvikelser ; under denna modell fungerar icke-robusta metoder som ett t-test dåligt.

Introduktion

Robust statistik försöker tillhandahålla metoder som efterliknar populära statistiska metoder, men som inte påverkas i onödan av extremvärden eller andra små avvikelser från modellantaganden . Inom statistiken bygger klassiska skattningsmetoder i hög grad på antaganden som ofta inte uppfylls i praktiken. Särskilt antas det ofta att datafelen är normalfördelade, åtminstone ungefärligt, eller att man kan lita på den centrala gränssatsen för att producera normalfördelade uppskattningar. Tyvärr, när det finns extremvärden i data, har klassiska estimatorer ofta mycket dåliga prestanda, när de bedöms med hjälp av nedbrytningspunkten och påverkansfunktionen , som beskrivs nedan.

Den praktiska effekten av problem som ses i påverkansfunktionen kan studeras empiriskt genom att undersöka provtagningsfördelningen av föreslagna estimatorer under en blandningsmodell , där man blandar in en liten mängd (1–5 % är ofta tillräckligt) av föroreningar. Till exempel kan man använda en blandning av 95 % normalfördelning och 5 % normalfördelning med samma medelvärde men betydligt högre standardavvikelse (representerar extremvärden).

Robust parametrisk statistik kan gå till på två sätt:

- genom att utforma estimatorer så att ett förvalt beteende hos påverkansfunktionen uppnås

- genom att ersätta estimatorer som är optimala under antagandet om en normalfördelning med estimatorer som är optimala för, eller åtminstone härledda för, andra distributioner: till exempel att använda t-fördelningen med låga frihetsgrader (hög kurtosis; frihetsgrader mellan 4 och 6 har ofta visat sig vara användbara i praktiken [ citat behövs ] ) eller med en blandning av två eller flera distributioner.

Robusta uppskattningar har studerats för följande problem:

- uppskatta platsparametrar [ citat behövs ]

- uppskatta skalparametrar [ citat behövs ]

- uppskatta regressionskoefficienter [ citat behövs ]

- uppskattning av modelltillstånd i modeller uttryckta i tillståndsrumsform , för vilka standardmetoden är likvärdig med ett Kalman-filter .

Definition

Det finns olika definitioner av "robust statistik ." Strängt taget är en robust statistik motståndskraftig mot fel i resultaten, producerade av avvikelser från antaganden (t.ex. om normalitet). Detta betyder att om antagandena endast är uppfyllda ungefär, kommer den robusta skattaren fortfarande att ha en rimlig effektivitet och en rimligt liten bias , samt vara asymptotiskt opartisk , vilket innebär att den har en bias som tenderar mot 0 eftersom urvalsstorleken tenderar mot oändlighet.

Vanligtvis är det viktigaste fallet distributionsmässig robusthet - robusthet mot att bryta antagandena om den underliggande fördelningen av data. Klassiska statistiska procedurer är vanligtvis känsliga för "långsvans" (t.ex. när distributionen av data har längre svansar än den antagna normalfördelningen). Detta innebär att de kommer att påverkas starkt av förekomsten av extremvärden i data, och uppskattningarna de producerar kan bli kraftigt förvrängda om det finns extrema extremvärden i data, jämfört med vad de skulle vara om extremvärdena inte inkluderades i data .

Däremot är mer robusta skattare som inte är så känsliga för distributionsförvrängningar som longtailedness också resistenta mot förekomsten av extremvärden. Sålunda, i samband med robust statistik, distributionsmässigt robust och avvikelsebeständig i praktiken synonyma. För ett perspektiv på forskning inom robust statistik fram till 2000, se Portnoy & He (2000) .

Vissa experter föredrar termen resistent statistik för distributionsrobusthet, och reserverar "robusthet" för icke-distributionsrobusthet, t.ex. robusthet mot brott mot antaganden om sannolikhetsmodellen eller skattaren, men detta är en minoritetsanvändning. Vanlig "robusthet" för att betyda "fördelningsstabilitet" är vanligt.

När man överväger hur robust en skattare är mot förekomsten av extremvärden, är det användbart att testa vad som händer när en extrem extremvärde läggs till i datasetet och att testa vad som händer när en extrem extremvärde ersätter en av de befintliga datapunkterna, och sedan överväga effekten av flera tillägg eller ersättningar.

Exempel

Medelvärdet är inte ett robust mått på central tendens . Om datauppsättningen t.ex. är värdena {2,3,5,6,9}, då om vi lägger till ytterligare en datapunkt med värde -1000 eller +1000 till data, kommer det resulterande medelvärdet att skilja sig mycket från medelvärdet av originaldata . På liknande sätt, om vi ersätter ett av värdena med en datapunkt med värdet -1000 eller +1000, kommer det resulterande medelvärdet att vara mycket annorlunda än medelvärdet för originaldata.

Medianen är ett robust mått på central tendens . Om vi tar samma datauppsättning {2,3,5,6,9}, om vi lägger till ytterligare en datapunkt med värdet -1000 eller +1000 kommer medianen att ändras något, men den kommer fortfarande att likna medianen för originaldata. Om vi ersätter ett av värdena med en datapunkt med värdet -1000 eller +1000 kommer den resulterande medianen fortfarande att likna medianen för den ursprungliga datan.

Beskrivet i termer av nedbrytningspunkter har medianen en nedbrytningspunkt på 50 %, vilket innebär att hälften av punkterna måste vara extremvärden innan medianen kan flyttas utanför intervallet för icke-avvikande värden, medan medelvärdet har en nedbrytningspunkt på 0, som en enda stor observation kan kasta av sig det.

Den absoluta medianavvikelsen och det interkvartila intervallet är robusta mått på statistisk spridning , medan standardavvikelsen och intervallet inte är det.

Trimmade estimatorer och Winsorised estimatorer är generella metoder för att göra statistik mer robust. L-estimatorer är en allmän klass av enkel statistik, ofta robust, medan M-estimatorer är en allmän klass av robust statistik, och är nu den föredragna lösningen, även om de kan vara ganska involverade att beräkna.

Ljushastighetsdata

Gelman et al. i Bayesian Data Analysis (2004) överväga en datauppsättning som relaterar till ljushastighetsmätningar gjorda av Simon Newcomb . Datauppsättningarna för den boken kan hittas via Klassiska datauppsättningar , och bokens webbplats innehåller mer information om data.

Även om huvuddelen av datan ser ut att vara mer eller mindre normalfördelad, finns det två uppenbara extremvärden. Dessa extremvärden har en stor effekt på medelvärdet, drar det mot dem och bort från mitten av huvuddelen av data. Således, om medelvärdet är avsett som ett mått på platsen för mitten av data, är det på sätt och vis partiskt när extremvärden finns.

Även fördelningen av medelvärdet är känd för att vara asymptotiskt normal på grund av den centrala gränssatsen. Dock kan extremvärden göra fördelningen av medelvärdet icke-normal även för ganska stora datamängder. Förutom denna icke-normalitet är medelvärdet också ineffektivt i närvaro av extremvärden och mindre varierande mått på plats är tillgängliga.

Uppskattning av plats

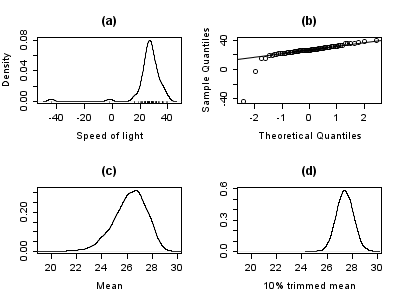

Diagrammet nedan visar en densitetsdiagram av ljushastighetsdata, tillsammans med en mattplot (panel (a)). En normal Q–Q-plot visas också (panel (b)). Avvikelserna är synliga i dessa tomter.

Panelerna (c) och (d) i diagrammet visar bootstrap-fördelningen av medelvärdet (c) och 10 % trimmat medelvärde (d). Det trimmade medelvärdet är en enkel robust uppskattning av lokalisering som raderar en viss procentandel av observationer (10 % här) från varje ände av data, och sedan beräknar medelvärdet på vanligt sätt. Analysen utfördes i R och 10 000 bootstrap -prover användes för var och en av de råa och trimmade medelvärdena.

Fördelningen av medelvärdet är klart mycket bredare än för det 10% trimmade medelvärdet (plotterna är på samma skala). Även om fördelningen av det trimmade medelvärdet verkar vara nära det normala, är fördelningen av det råa medelvärdet ganska skev åt vänster. Så i detta urval av 66 observationer är det bara 2 extremvärden som gör att den centrala gränssatsen inte är tillämplig.

Robusta statistiska metoder, där det trimmade medelvärdet är ett enkelt exempel, försöker överträffa klassiska statistiska metoder i närvaro av extremvärden, eller mer allmänt när underliggande parametriska antaganden inte är helt korrekta.

Även om det trimmade medelvärdet fungerar bra i förhållande till medelvärdet i detta exempel, finns bättre robusta uppskattningar tillgängliga. I själva verket är medelvärdet, medianen och trimmat medelvärde alla specialfall av M-skattare . Detaljer visas i avsnitten nedan.

Uppskattning av skala

Avvikelserna i ljushastighetsdata har mer än bara en negativ effekt på medelvärdet; den vanliga uppskattningen av skalan är standardavvikelsen, och denna kvantitet påverkas ännu värre av extremvärden eftersom kvadraterna på avvikelserna från medelvärdet går in i beräkningen, så att extremvärdens effekter förvärras.

Diagrammen nedan visar bootstrap-fördelningarna av standardavvikelsen, median absolut avvikelse (MAD) och Rousseeuw–Croux (Qn) estimator av skalan. Plotterna är baserade på 10 000 bootstrap-sampler för varje estimator, med visst Gaussiskt brus lagt till de omsamplade data ( smoothed bootstrap ) . Panel (a) visar fördelningen av standardavvikelsen, (b) för MAD och (c) för Qn.

Fördelningen av standardavvikelse är oberäknelig och bred, ett resultat av extremvärdena. MAD fungerar bättre och Qn är lite mer effektiv än MAD. Detta enkla exempel visar att när extremvärden finns kan standardavvikelsen inte rekommenderas som en uppskattning av skalan.

Manuell screening för extremvärden

Traditionellt skulle statistiker manuellt screena data för extremvärden och ta bort dem, vanligtvis kontrollerade datakällan för att se om extremvärdena registrerades felaktigt. I exemplet med ljushastighet ovan är det faktiskt lätt att se och ta bort de två extremvärdena innan du fortsätter med ytterligare analys. Men i modern tid består datauppsättningar ofta av ett stort antal variabler som mäts på ett stort antal experimentella enheter. Därför är manuell screening för extremvärden ofta opraktisk.

Outliers kan ofta interagera på ett sådant sätt att de maskerar varandra. Som ett enkelt exempel, betrakta en liten univariat datamängd som innehåller en blygsam och en stor extremvärde. Den uppskattade standardavvikelsen kommer att höjas kraftigt med den stora avvikelsen. Resultatet är att den blygsamma avvikelsen ser relativt normal ut. Så fort den stora avvikelsen tas bort, krymper den uppskattade standardavvikelsen, och den blygsamma avvikelsen ser nu ovanlig ut.

Detta problem med maskering blir värre när komplexiteten i data ökar. Till exempel, i regressionsproblem , används diagnostiska plotter för att identifiera extremvärden. Det är dock vanligt att när några extremvärden har tagits bort blir andra synliga. Problemet är ännu värre i högre dimensioner.

Robusta metoder ger automatiska sätt att upptäcka, nedvikta (eller ta bort) och flagga extremvärden, vilket till stor del tar bort behovet av manuell screening. Försiktighet måste iakttas; initiala data som visar att ozonhålet först uppträdde över Antarktis avvisades som extremvärden av icke-mänsklig screening.

Mängd applikationer

Även om denna artikel behandlar allmänna principer för univariata statistiska metoder, finns robusta metoder även för regressionsproblem, generaliserade linjära modeller och parameteruppskattning av olika distributioner.

Mått på robusthet

De grundläggande verktygen som används för att beskriva och mäta robusthet är nedbrytningspunkten , påverkansfunktionen och känslighetskurvan .

Nedbrytningspunkt

Intuitivt är nedbrytningspunkten för en estimator andelen felaktiga observationer (t.ex. godtyckligt stora observationer) en estimator kan hantera innan den ger ett felaktigt (t.ex. godtyckligt stort) resultat. Vanligtvis anges den asymptotiska (oändliga sampel) gränsen som nedbrytningspunkten, även om nedbrytningspunkten för det finita urvalet kan vara mer användbar. Till exempel, givet oberoende slumpvariabler och motsvarande realisationer , vi kan använda för att uppskatta medelvärdet. En sådan estimator har en nedbrytningspunkt på 0 (eller en ändlig samplingspunkt på ) eftersom vi kan göra godtyckligt stor bara genom att ändra någon av .

Ju högre nedbrytningspunkt en estimator har, desto mer robust är den. Intuitivt kan vi förstå att en nedbrytningspunkt inte kan överstiga 50 % eftersom om mer än hälften av observationerna är kontaminerade är det inte möjligt att skilja mellan den underliggande fördelningen och den kontaminerande distributionen. Rousseeuw & Leroy (1986) harvtxt-fel: inget mål . Därför är den maximala nedbrytningspunkten 0,5 och det finns estimatorer som uppnår en sådan nedbrytningspunkt. Till exempel har medianen en nedbrytningspunkt på 0,5. Det beskurna medelvärdet för X% har en nedbrytningspunkt på X%, för den valda nivån för X. (1981) och Maronna, Martin & Yohai (2006) ) innehåller fler detaljer. Nivån och effektnedbrytningspunkterna för tester undersöks i He, Simpson & Portnoy (1990) .

Statistik med höga nedbrytningspunkter kallas ibland resistent statistik.

Exempel: ljushastighetsdata

I exemplet med ljushastighet, gör att man tar bort de två lägsta observationerna att medelvärdet ändras från 26,2 till 27,75, en förändring på 1,55. Uppskattningen av skalan som produceras med Qn-metoden är 6,3. Vi kan dividera detta med kvadratroten av urvalsstorleken för att få ett robust standardfel, och vi finner att denna kvantitet är 0,78. Således är förändringen i medelvärdet till följd av att två extremvärden tas bort ungefär två gånger det robusta standardfelet.

Det 10 % trimmade medelvärdet för ljushastighetsdata är 27,43. Att ta bort de två lägsta observationerna och räkna om ger 27,67. Det trimmade medelvärdet påverkas mindre av extremvärdena och har en högre nedbrytningspunkt.

Om vi ersätter den lägsta observationen, −44, med −1000, blir medelvärdet 11,73, medan det 10 % trimmade medelvärdet fortfarande är 27,43. Inom många områden av tillämpad statistik är det vanligt att data log-transformeras för att göra dem nära symmetriska. Väldigt små värden blir stora negativa när de log-transformeras, och nollor blir negativt oändliga. Därför är detta exempel av praktiskt intresse.

Empirisk påverkansfunktion

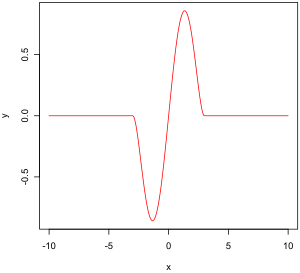

Den empiriska påverkansfunktionen är ett mått på estimatorns beroende av värdet av någon av punkterna i urvalet. Det är ett modellfritt mått i den meningen att det helt enkelt förlitar sig på att beräkna estimatorn igen med ett annat urval. Till höger finns Tukeys biviktsfunktion, som, som vi senare ska se, är ett exempel på hur en "bra" (i en mening definierad senare) empirisk påverkansfunktion ska se ut.

I matematiska termer definieras en påverkansfunktion som en vektor i estimatorns utrymme, som i sin tur definieras för ett urval som är en delmängd av populationen:

- är ett sannolikhetsutrymme,

- är ett mätbart utrymme (tillståndsutrymme),

- är ett parameterutrymme med dimensionen ,

- är ett mätbart utrymme,

Till exempel,

- är vilket sannolikhetsutrymme som helst,

- ,

- ,

Den empiriska påverkansfunktionen definieras enligt följande.

Låt och ( x 1 är ett urval från dessa variabler. är en estimator. Låt . Den empiriska påverkansfunktionen vid observation definieras av:

Vad detta betyder är att vi ersätter det i -te värdet i urvalet med ett godtyckligt värde och tittar på utdata från skattaren. Alternativt definieras EIF som effekten, skalad med n+1 istället för n, på estimatorn för att addera punkten x { till provet. [ citat behövs ]

Influensfunktion och känslighetskurva

Istället för att enbart förlita oss på data kan vi använda fördelningen av de slumpmässiga variablerna. Tillvägagångssättet är helt annorlunda än det i föregående stycke. Vad vi nu försöker göra är att se vad som händer med en skattare när vi ändrar fördelningen av data något: den antar en fördelning och mäter känsligheten för förändringar i denna fördelning. Däremot antar det empiriska inflytandet en provuppsättning och mäter känsligheten för förändringar i proverna.

Låt vara en konvex delmängd av mängden av alla finita tecken på . Vi vill uppskatta parametern för en fördelning i . Låt det funktionella vara det asymptotiska värdet av någon estimatorsekvens . Vi antar att denna funktion är Fisher-konsistent , dvs . Detta betyder att vid modellen mäter estimatorsekvensen asymptotiskt den korrekta kvantiteten.

Låt vara en viss fördelning i . Vad händer när data inte följer modellen exakt utan en annan, något annorlunda, "som går mot" ?

Vi tittar på:

- ,

som är den ensidiga Gateaux-derivatan av vid , i riktning mot .

Låt . är sannolikhetsmåttet som ger massan 1 till . Vi väljer . Inflytandefunktionen definieras sedan av:

Den beskriver effekten av en infinitesimal kontaminering vid punkten på den uppskattning vi söker, standardiserad av massan för kontamineringen (den asymptotiska bias orsakad av kontaminering i observationerna). För en robust estimator vill vi ha en begränsad påverkansfunktion, det vill säga en som inte går till oändlighet då x blir godtyckligt stort.

Önskvärda egenskaper

Egenskaper för en påverkansfunktion som ger den önskvärd prestanda är:

- Finit förkastningspunkt ,

- Liten känslighet för grovt fel ,

- Liten lokalförskjutningskänslighet .

Avslagspunkt

Känslighet för grovt fel

Lokal skiftkänslighet

Detta värde, som påminner mycket om en Lipschitz-konstant , representerar effekten av att en observation flyttas något från till en angränsande punkt , dvs. lägg till en observation vid och ta bort en vid .

M-uppskattare

(Det matematiska sammanhanget för detta stycke ges i avsnittet om empiriska påverkansfunktioner.)

Historiskt föreslogs flera tillvägagångssätt för robust uppskattning, inklusive R-skattare och L-uppskattningar . Emellertid tycks M-skattare nu dominera fältet som ett resultat av deras generella karaktär, höga nedbrytningspunkt och deras effektivitet. Se Huber (1981) .

M-estimatorer är en generalisering av maximum likelihood estimators (MLE). Vad vi försöker göra med MLE:s är att maximera eller, på motsvarande sätt, minimera . 1964 föreslog Huber att generalisera detta till minimering av där är någon funktion. MLE är därför ett specialfall av M-estimatorer (därav namnet: " M aximum likelihood type "-estimatorer).

Att minimera kan ofta göras genom att differentiera och lösa , där (om har en derivata).

Flera val av och har föreslagits. De två figurerna nedan visar fyra -funktioner och deras motsvarande -funktioner.

För kvadratiska fel ökar med en accelererande hastighet, medan den för absoluta fel ökar med en konstant hastighet. När Winsorizing används, introduceras en blandning av dessa två effekter: för små värden på x, med den kvadratiska hastigheten, men när den valda tröskeln har nåtts (1,5 i detta exempel), ökar hastigheten för ökningen blir konstant. Denna Winsorised estimator är också känd som Hubers förlustfunktion .

Tukeys biweight-funktion (även känd som bisquare) fungerar på ett liknande sätt som den kvadratiska felfunktionen till en början, men för större fel minskar funktionen.

Egenskaper hos M-skattare

M-estimatorer hänför sig inte nödvändigtvis till en sannolikhetstäthetsfunktion. Därför kan off-the-shelf metoder för slutledning som härrör från sannolikhetsteori i allmänhet inte användas.

Det kan visas att M-estimatorer är asymptotiskt normalfördelade så att så länge som deras standardfel kan beräknas finns en ungefärlig metod för slutledning tillgänglig.

Eftersom M-estimatorer endast är normala asymptotiskt, kan det för små provstorlekar vara lämpligt att använda ett alternativt tillvägagångssätt för slutledning, såsom bootstrap. M-uppskattningar är dock inte nödvändigtvis unika (dvs. det kan finnas mer än en lösning som uppfyller ekvationerna). Det är också möjligt att ett visst bootstrap-prov kan innehålla fler extremvärden än estimatorns nedbrytningspunkt. Därför krävs viss försiktighet när du designar bootstrap-scheman.

Naturligtvis, som vi såg med exemplet med ljushastighet, är medelvärdet endast normalfördelat asymptotiskt och när extremvärden finns kan approximationen vara mycket dålig även för ganska stora prover. Klassiska statistiska tester, inklusive de som baseras på medelvärdet, är dock vanligtvis begränsade ovanför av testets nominella storlek. Detsamma gäller inte M-estimatorer och felfrekvensen av typ I kan vara avsevärt över den nominella nivån.

Dessa överväganden "ogiltigförklarar" inte M-uppskattning på något sätt. De klargör bara att viss försiktighet behövs vid användningen, vilket är sant för alla andra uppskattningsmetoder.

Påverkansfunktion hos en M-skattare

Det kan visas att inflytandefunktionen för en M-estimator är proportionell mot , vilket betyder att vi kan härleda egenskaperna hos en sådan estimator (såsom dess förkastningspunkt, brutto- felkänslighet eller lokalförskjutningskänslighet) när vi känner till dess -funktion.

med som ges av:

Val av ψ och ρ

I många praktiska situationer är valet av -funktionen inte avgörande för att få en bra robust uppskattning, och många val kommer att ge liknande resultat som erbjuder stora förbättringar, i termer av effektivitet och bias, jämfört med klassiska uppskattningar i förekomsten av extremvärden.

Teoretiskt sett är funktioner att föredra, [ förtydligande behövs ] och Tukeys biweight (även känd som bisquare) funktion är ett populärt val. Maronna, Martin & Yohai (2006) rekommenderar biweight-funktionen med effektivitet vid normal inställning till 85%.

Robusta parametriska tillvägagångssätt

M-estimatorer relaterar inte nödvändigtvis till en densitetsfunktion och är därför inte helt parametriska. Fullständigt parametriska tillvägagångssätt för robust modellering och slutledning, både Bayesianska och sannolikhetsmetoder, handlar vanligtvis om tungsvansade distributioner som Students t -distribution.

För t -fördelningen med frihetsgrader kan det visas att

För t - fördelningen ekvivalent med Cauchy-fördelningen. Frihetsgraderna är ibland känd som kurtosisparametern . Det är parametern som styr hur tunga svansarna är. I princip uppskattas från data på samma sätt som vilken annan parameter som helst. I praktiken är det vanligt att det finns flera lokala maxima när tillåts variera. Som sådant är det vanligt att fixera till ett värde runt 4 eller 6. Figuren nedan visar -funktionen för 4 olika värden på .

Exempel: ljushastighetsdata

För ljushastighetsdata, som tillåter kurtosis-parametern att variera och maximerar sannolikheten, får vi

Att fixa och maximera sannolikheten ger

Relaterade begrepp

En pivotal kvantitet är en funktion av data, vars underliggande populationsfördelning är en medlem av en parametrisk familj, som inte är beroende av parametrarnas värden. En sidostatistik är en sådan funktion som också är en statistik, vilket innebär att den beräknas enbart utifrån data. Sådana funktioner är robusta mot parametrar i den meningen att de är oberoende av parametrarnas värden, men inte robusta mot modellen i den meningen att de antar en underliggande modell (parametrisk familj), och i själva verket är sådana funktioner ofta mycket känsliga. till överträdelser av modellens antaganden. Teststatistik , som ofta konstrueras utifrån dessa för att inte vara känslig för antaganden om parametrar, är fortfarande mycket känslig för modellantaganden.

Ersätter extremvärden och saknade värden

Att ersätta saknad data kallas imputering . Om det saknas relativt få punkter, finns det några modeller som kan användas för att uppskatta värden för att slutföra serien, till exempel att ersätta saknade värden med medelvärdet eller medianen av data. Enkel linjär regression kan också användas för att uppskatta saknade värden. [ ofullständig kort hänvisning ] Dessutom kan extremvärden ibland rymmas i data genom användning av trimmade medel, andra skalestimatorer förutom standardavvikelse (t.ex. MAD) och Winsorization. Vid beräkningar av ett trimmat medelvärde släpps en fast procentandel av data från varje ände av en beställd data, vilket eliminerar extremvärdena. Medelvärdet beräknas sedan med hjälp av återstående data. Winsorizing innebär att ta emot en extremvärde genom att ersätta den med det näst högsta eller näst minsta värdet efter behov.

Att använda dessa typer av modeller för att förutsäga saknade värden eller extremvärden i en lång tidsserie är dock svårt och ofta opålitligt, särskilt om antalet värden som ska fyllas i är relativt högt i jämförelse med den totala rekordlängden. Uppskattningens noggrannhet beror på hur bra och representativ modellen är och hur länge perioden med saknade värden sträcker sig. När dynamisk evolution antas i en serie, blir problemet med saknade datapunkter en övning i multivariat analys (snarare än den univariata metoden för de flesta traditionella metoder för att uppskatta saknade värden och extremvärden). I sådana fall kommer en multivariat modell att vara mer representativ än en univariat för att förutsäga saknade värden. Kohonens självorganiserande karta (KSOM) erbjuder en enkel och robust multivariat modell för dataanalys, vilket ger goda möjligheter att uppskatta saknade värden, med hänsyn till deras samband eller korrelation med andra relevanta variabler i dataposten.

Standard Kalman-filter är inte robusta mot extremvärden. För detta ändamål Ting, Theodorou & Schaal (2007) nyligen visat att en modifiering av Masreliez' teorem kan hantera extremvärden.

Ett vanligt tillvägagångssätt för att hantera extremvärden i dataanalys är att först utföra detektering av extremvärden, följt av en effektiv uppskattningsmetod (t.ex. minsta kvadrater). Även om detta tillvägagångssätt ofta är användbart, måste man ha två utmaningar i åtanke. För det första kan en metod för detektering av extremvärden som förlitar sig på en icke-robust initial passning drabbas av effekten av maskering, det vill säga en grupp av extremvärden kan maskera varandra och undkomma upptäckt. För det andra, om en initial passning med hög nedbrytning används för detektering av extremvärden, kan uppföljningsanalysen ärva en del av den initiala skattarens ineffektivitet.

Se även

Anteckningar

- Farcomeni, A.; Greco, L. (2013), Robusta metoder för datareduktion , Boca Raton, FL: Chapman & Hall/CRC Press, ISBN 978-1-4665-9062-5 .

- Hampel, Frank R.; Ronchetti, Elvezio M.; Rousseeuw, Peter J. ; Stahel, Werner A. (1986), Robust statistik , Wiley Series in Probability and Mathematical Statistics: Probability and Mathematical Statistics, New York: John Wiley & Sons, Inc., ISBN 0-471-82921-8 , MR 0829458 . Återpublicerad i pocketbok, 2005.

- Han, Xuming ; Portnoy, Stephen (1992), "Reweighted LS estimators converge at the same rate as the initial estimator", Annals of Statistics , 20 (4): 2161–2167, doi : 10.1214/aos/1176348910 , MR 3 319 .

- Han, Xuming ; Simpson, Douglas G.; Portnoy, Stephen L. (1990), "Breakdown robustness of tests", Journal of the American Statistical Association , 85 (410): 446–452, doi : 10.2307/2289782 , JSTOR 2289782 , MR 1141746 .

- Hettmansperger, TP; McKean, JW (1998), Robust nonparametric statistical methods , Kendall's Library of Statistics, vol. 5, New York: John Wiley & Sons, Inc., ISBN 0-340-54937-8 , MR 1604954 . 2:a upplagan, CRC Press, 2011.

- Huber, Peter J. (1981), Robust statistik , New York: John Wiley & Sons, Inc., ISBN 0-471-41805-6 , MR 0606374 . Återpublicerad i pocket, 2004. 2:a upplagan, Wiley, 2009.

- Maronna, Ricardo A.; Martin, R. Douglas; Yohai, Victor J.; Salibián-Barrera, Matías (2019), Robust statistik: Teori och metoder (med R) , Wiley Series in Probability and Statistics (2nd ed.), Chichester: John Wiley & Sons, Ltd., doi : 10.1002/9781119214656 , ISBN 978 -1-119-21468-7 .

- McBean, Edward A.; Rovers, Frank (1998), Statistiska procedurer för analys av miljöövervakningsdata och bedömning , Prentice-Hall .

- Portnoy, Stephen; He, Xuming (2000), "A robust journey in the new millennium", Journal of the American Statistical Association , 95 (452): 1331–1335, doi : 10.2307/2669782 , JSTOR 2669782 , MR 1825288 .

- Press, William H. ; Teukolsky, Saul A. ; Vetterling, William T.; Flannery, Brian P. (2007), "Section 15.7. Robust Estimation" , Numeriska recept: The Art of Scientific Computing (3:e upplagan), Cambridge University Press, ISBN 978-0-521-88068-8 , MR 2371990 .

- Rosen, C.; Lennox, JA ( oktober 2001), "Multivariate and multiscale monitoring of wastewater treatment operation", Water Research , 35 (14): 3402–3410, doi : 10.1016/s0043-1354(01)00069-0 1 , 5 PM ID

- Rousseeuw, Peter J. ; Croux, Christophe (1993), "Alternatives to the median absolute deviation", Journal of the American Statistical Association , 88 (424): 1273–1283, doi : 10.2307/2291267 , JSTOR 2291267 , MR 1245 .

- Rousseeuw, Peter J. ; Leroy, Annick M. (1987), Robust Regression and Outlier Detection , Wiley Series in Probability and Mathematical Statistics: Applied Probability and Statistics, New York: John Wiley & Sons, Inc., doi : 10.1002/0471725382 , ISBN 0-471-0-471-0-471-0-471 85233-3 , MR 0914792 . Återpublicerad i pocketbok, 2003.

- Rousseeuw, Peter J. ; Hubert, Mia (2011), "Robust statistics for outlier detection", Wiley Interdisciplinary Reviews: Data Mining and Knowledge Discovery , 1 (1): 73–79, doi : 10.1002/widm.2 , S2CID 17448982 . Förtryck

- Rustum, Rabee; Adeloye, Adebayo J. (september 2007), "Ersättande av extremvärden och saknade värden från aktiverat slamdata med hjälp av Kohonens självorganiserande karta", Journal of Environmental Engineering , 133 ( 9): 909–916, doi : 10.1061/(asce)0733 -9372(2007)133:9(909) .

- Stigler, Stephen M. (2010), "The changing history of robustness", The American Statistician , 64 (4): 277–281, doi : 10.1198/tast.2010.10159 , MR 2758558 , S2CID 10728417 .

- Ting, Jo-anne; Theodorou, Evangelos; Schaal, Stefan (2007), "A Kalman filter for robust outlier detection", International Conference on Intelligent Robots and Systems – IROS , s. 1514–1519 .

- von Mises, R. (1947), "On the asymptotic distribution of differentiable statistic functions", Annals of Mathematical Statistics , 18 (3): 309–348, doi : 10.1214/aoms/1177730385 , MR 0022330 .

- Wilcox, Rand (2012), Introduction to robust estimation and hypothesis testing , Statistical Modeling and Decision Science (3rd ed.), Amsterdam: Elsevier/Academic Press, s. 1–22, doi : 10.1016/B978-0-12-386983 -8.00001-9 , ISBN 978-0-12-386983-8 , MR 3286430 .

externa länkar

- Brian Ripleys robusta statistikkursanteckningar.

- Nick Fiellers kursanteckningar om statistisk modellering och beräkning innehåller material om robust regression.

- David Olives webbplats innehåller kursanteckningar om robust statistik och vissa datauppsättningar.

- Onlineexperiment med R och JSXGraph