Probabilistisk klassificering

| Del av en serie om |

|

maskininlärning och datautvinning |

|---|

|

I maskininlärning är en probabilistisk klassificerare en klassificerare som kan förutsäga, givet en observation av en ingång, en sannolikhetsfördelning över en uppsättning klasser, snarare än att bara mata ut den mest sannolika klassen som observationen ska tillhöra. Probabilistiska klassificerare tillhandahåller klassificering som kan vara användbar i sin egen rätt eller när man kombinerar klassificerare till ensembler .

Typer av klassificering

Formellt är en "vanlig" klassificerare någon regel, eller funktion , som tilldelar ett exempel x en klassetikett ŷ :

Proverna kommer från någon uppsättning X (t.ex. uppsättningen av alla dokument eller uppsättningen av alla bilder ), medan klassetiketterna bildar en ändlig uppsättning Y definierad före träning.

Probabilistiska klassificerare generaliserar denna uppfattning om klassificerare: istället för funktioner är de villkorsfördelningar vilket betyder att för en given , tilldelar de sannolikheter till alla (och dessa sannolikheter summerar till ett). "Hård" klassificering kan sedan göras med hjälp av den optimala beslutsregeln

eller, på engelska, är den förutsagda klassen den som har högst sannolikhet.

Binära probabilistiska klassificerare kallas även för binära regressionsmodeller i statistik . Inom ekonometri kallas probabilistisk klassificering i allmänhet för diskret val .

Vissa klassificeringsmodeller, såsom naiva Bayes , logistisk regression och flerskiktsperceptroner (när de tränas under en lämplig förlustfunktion ) är naturligt sannolikt. Andra modeller som stödvektormaskiner är det inte, men det finns metoder för att förvandla dem till probabilistiska klassificerare.

Generativ och villkorad träning

Vissa modeller, såsom logistisk regression , är villkorligt tränade: de optimerar den villkorliga sannolikheten direkt på en träningsuppsättning (se empirisk riskminimering ). Andra klassificerare, såsom naiva Bayes, tränas generativt : vid träningstid, den klassvillkorliga fördelningen och klassens prior hittas, och den villkorliga fördelningen härleds med Bayes regel .

Sannolikhetskalibrering

Alla klassificeringsmodeller är inte naturligt probabilistiska, och vissa som är, särskilt naiva Bayes-klassificerare, beslutsträd och förstärkningsmetoder , producerar förvrängda klasssannolikhetsfördelningar. När det gäller beslutsträd, där Pr( y | x ) är andelen träningsprover med etikett y i bladet där x hamnar, uppstår dessa förvrängningar eftersom inlärningsalgoritmer som C4.5 eller CART uttryckligen syftar till att producera homogena blad (som ger sannolikheter nära noll eller ett, och därmed hög bias ) samtidigt som man använder få stickprov för att uppskatta den relevanta andelen (hög varians ).

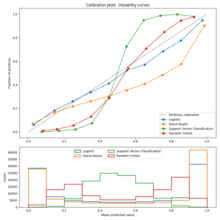

Kalibrering kan bedömas med hjälp av ett kalibreringsdiagram (även kallat ett tillförlitlighetsdiagram ). En kalibreringsplot visar andelen objekt i varje klass för band med förutspådd sannolikhet eller poäng (som en förvrängd sannolikhetsfördelning eller det "signerade avståndet till hyperplanet" i en stödvektormaskin). Avvikelser från identitetsfunktionen indikerar en dåligt kalibrerad klassificerare för vilken de förutsagda sannolikheterna eller poängen inte kan användas som sannolikheter. I det här fallet kan man använda en metod för att omvandla dessa poäng till korrekt kalibrerade sannolikheter för klassmedlemskap.

För det binära fallet är ett vanligt tillvägagångssätt att tillämpa Platt-skalning , som lär sig en logistisk regressionsmodell på poängen. En alternativ metod som använder isotonisk regression är i allmänhet överlägsen Platts metod när tillräcklig träningsdata finns tillgänglig.

I multiklassfallet kan man använda en reduktion till binära uppgifter, följt av univariat kalibrering med en algoritm som beskrivits ovan och ytterligare tillämpning av den parvisa kopplingsalgoritmen av Hastie och Tibshirani.

Utvärdera probabilistisk klassificering

Vanligt använda förlustfunktioner för sannolikhetsklassificering inkluderar logförlust och Brier-poängen mellan den förutsagda och den sanna sannolikhetsfördelningen. Den förra av dessa används ofta för att träna logistiska modeller.

En metod som används för att tilldela poäng till par av predikterade sannolikheter och faktiska diskreta utfall, så att olika prediktiva metoder kan jämföras, kallas en poängregel .

Programvaruimplementeringar

- MoRPE är en träningsbar probabilistisk klassificerare som använder isotonisk regression för sannolikhetskalibrering. Det löser multiklassfallet genom att reducera till binära uppgifter. Det är en typ av kärnmaskin som använder en inhomogen polynomkärna.