Lasso (statistik)

Inom statistik och maskininlärning är lasso ( operator för minsta absoluta krympning och urval ; även Lasso eller LASSO ) en regressionsanalysmetod som utför både variabelselektion och regularisering för att förbättra prediktionsnoggrannheten och tolkningsbarheten av den resulterande statistiska modellen . Det introducerades ursprungligen inom geofysiken och senare av Robert Tibshirani , som myntade termen.

Lasso formulerades ursprungligen för linjära regressionsmodeller . Detta enkla fall avslöjar en betydande mängd om estimatorn. Dessa inkluderar dess förhållande till åsregression och bästa delmängdsurval och sambanden mellan lassokoefficientuppskattningar och så kallad mjuk tröskel. Det avslöjar också att (liksom standard linjär regression) koefficientuppskattningarna inte behöver vara unika om kovariater är kolinjära .

Även om den ursprungligen definierades för linjär regression, kan lasso-regularisering lätt utökas till andra statistiska modeller inklusive generaliserade linjära modeller , generaliserade skattningsekvationer , proportionella riskmodeller och M-estimatorer . Lassos förmåga att utföra urval av delmängder förlitar sig på formen av begränsningen och har en mängd olika tolkningar, inklusive i termer av geometri , Bayesiansk statistik och konvex analys .

LASSO är nära besläktat med denoising av basjakt .

Historia

Lasso introducerades för att förbättra prediktionsnoggrannheten och tolkningsbarheten av regressionsmodeller. Den väljer en reducerad uppsättning av kända kovariater för användning i en modell.

Lasso utvecklades oberoende i geofysisk litteratur 1986, baserat på tidigare arbete som använde ℓ straff för både anpassning och bestraffning av koefficienterna. Statistikern Robert Tibshirani återupptäckte och populariserade den självständigt 1996, baserat på Breimans icke-negativa garrote.

Före lassot var den mest använda metoden för att välja kovariater stegvis urval . Det tillvägagångssättet förbättrar bara prediktionsnoggrannheten i vissa fall, till exempel när endast ett fåtal kovariater har ett starkt samband med resultatet. Men i andra fall kan det öka prediktionsfelet.

På den tiden var åsregression den mest populära tekniken för att förbättra prediktionsnoggrannheten. Ridge-regression förbättrar förutsägelsefelet genom att krympa summan av kvadraterna av regressionskoefficienterna till att vara mindre än ett fast värde för att minska överanpassning , men den utför inte samvariatval och hjälper därför inte till att göra modellen mer tolkningsbar.

Lasso uppnår båda dessa mål genom att tvinga summan av det absoluta värdet av regressionskoefficienterna att vara mindre än ett fast värde, vilket tvingar vissa koefficienter till noll, vilket utesluter dem från att påverka förutsägelse. Denna idé liknar åsregression, som också krymper storleken på koefficienterna; åsregression ställer dock inte koefficienterna till noll (och utför därför inte variabelval ).

Grundform

Minst kvadrater

Betrakta ett urval som består av N fall, som vart och ett består av p kovariater och ett enda utfall. Låt vara resultatet och vara kovariatvektorn för det i: te fallet. Då är målet med lasso att lösa

Här är den konstanta koefficienten, är koefficientvektorn, och är en fördefinierad fri parameter som bestämmer graden av regularisering.

Låter vara den kovariata matrisen, så att och är den i: te raden av , uttrycket kan skrivas mer kompakt som

där är standard norm .

Betecknar det skalära medelvärdet av datapunkterna med och medelvärdet av svarsvariablerna med , den resulterande uppskattningen för är så att

och därför är det standard att arbeta med variabler som har gjorts noll-medelvärde. Dessutom är kovariaterna vanligtvis standardiserade så att lösningen inte beror på mätskalan.

Det kan vara bra att skriva om

i den så kallade lagrangiska formen

där det exakta förhållandet mellan och är databeroende.

Ortonormala kovariater

Några grundläggande egenskaper hos lassoskattaren kan nu övervägas.

Antag först att kovariaterna är ortonormala så att där är Kronecker-deltatet , eller motsvarande , då kan man med hjälp av subgradientmetoder visa att

hänvisas till som den mjuka tröskeloperatorn , eftersom den översätter värden mot noll (gör dem exakt noll om de är tillräckligt små) istället för att sätta mindre värden till noll och lämna större orörda som den hårda tröskeloperatorn , ofta betecknad , skulle.

Vid åsregression är målet att minimera

Använder och åsregressionsformeln: :

Ridge-regression krymper alla koefficienter med en enhetlig faktor på och sätter inga koefficienter till noll. [ citat behövs ] .

Det kan också jämföras med regression med val av bästa delmängd , där målet är att minimera

där är " -normen", som definieras som om exakt m komponenter i z inte är noll. I det här fallet kan det visas

där är den så kallade hårda tröskelfunktionen och är en indikatorfunktion (den är 1 om dess argument är sant och 0 annars).

Därför delar lassouppskattningarna egenskaper hos både ås- och bästa delmängdselektionsregression eftersom de båda krymper storleken på alla koefficienter, som åsregression, och ställer några av dem till noll, som i det bästa delmängdselektionsfallet. Dessutom, medan åsregression skalar alla koefficienter med en konstant faktor, översätter lasso istället koefficienterna mot noll med ett konstant värde och sätter dem till noll om de når det.

I ett specialfall är två kovariater, säg j och k , identiska för varje observation, så att där . Då är värdena för och som minimerar lassoobjektivfunktionen inte unikt bestämda. Faktum är att om några där , då om ersätter av β av , samtidigt som alla andra hålls fasta, ger en ny lösning, så lassomålet Funktionen har då ett kontinuum av giltiga minimerare. Flera varianter av lassot, inklusive elastisk nätreglering , har utformats för att åtgärda denna brist.

Allmän form

Lasso-regularisering kan utvidgas till andra objektiva funktioner såsom de för generaliserade linjära modeller , generaliserade skattningsekvationer , proportionella riskmodeller och M-estimatorer . Med tanke på den objektiva funktionen

den lasso-reguljäriserade versionen av estimatorn är lösningen på

där endast straffas medan är fri att ta vilket tillåtet värde som helst, precis som inte straffades i grundfallet.

Tolkningar

Geometrisk tolkning

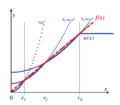

Lasso kan sätta koefficienter till noll, medan den ytligt likartade åsregressionen inte kan. Detta beror på skillnaden i formen på deras begränsningsgränser. Både lasso- och åsregression kan tolkas som att samma objektiva funktion minimeras

men med hänsyn till olika begränsningar: för lasso och för ås. Figuren visar att begränsningsområdet som definieras av -normen är en kvadrat som roteras så att dess hörn ligger på axlarna (i allmänhet en korspolytop ), medan regionen som definieras av norm är en cirkel (i allmänhet en n -sfär ), som är rotationsinvariant och därför inte har några hörn. Som framgår av figuren kommer sannolikt ett konvext objekt som tangerar gränsen, såsom linjen som visas, att möta ett hörn (eller en högre dimensionell motsvarighet) av en hyperkub, för vilken vissa komponenter i β {\ är identiskt noll, medan i fallet med en n -sfär, särskiljs inte punkterna på gränsen för vilka några av komponenterna i är noll från de andra och det konvexa objektet är inte längre kommer sannolikt att kontakta en punkt där vissa komponenter i är noll än en för vilken ingen av dem är det.

Gör λ lättare att tolka med en kompromiss mellan precision och enkelhet

Lasso kan skalas om så att det blir lätt att förutse och påverka graden av krympning som är förknippad med ett givet värde på . Det antas att är standardiserad med z-poäng och att är centrerad (noll medelvärde). Låt representera de hypoteserade regressionskoefficienterna och låt hänvisa till de dataoptimerade vanliga minsta kvadraters lösningar. Vi kan sedan definiera Lagrangian som en avvägning mellan noggrannheten i stickprovet för de dataoptimerade lösningarna och enkelheten att hålla sig till de hypotesvärden. Detta resulterar i

där anges nedan. Den första bråkdelen representerar relativ noggrannhet, den andra bråkdelen relativ enkelhet och balanserar mellan de två.

Givet en enda regressor kan relativ enkelhet definieras genom att specificera som , vilket är den maximala mängden avvikelse från när . Om vi antar att kan lösningsvägen definieras i termer av :

Om används den vanliga minsta kvadratlösningen (OLS). Det antagna värdet på väljs om är större än . Dessutom, om , så representerar det proportionella inflytandet av . Med andra ord, mäter procentuellt den minimala mängden påverkan av det antagna värdet i förhållande till den dataoptimerade OLS-lösningen.

Om en -norm används för att straffa avvikelser från noll givet en enskild regressor, ges lösningsvägen av

. Som , rör sig i punktens riktning när är nära noll; men till skillnad från påverkan av i om ökar (se figur). Givet flera regressorer, bestäms det ögonblick då en parameter aktiveras (dvs tillåts avvika från ) också av en regressors bidrag till noggrannhet. Först,

En på 75 % betyder att noggrannheten i urvalet förbättras med 75 % om de obegränsade OLS-lösningarna används istället för de hypoteserade -värdena. Det individuella bidraget för att avvika från varje hypotes kan beräknas med x -matrisen

där . Om när beräknas, så summerar de diagonala elementen i till . De diagonala värdena kan vara mindre än 0 eller, mer sällan, större än 1. Om regressorer är okorrelerade, då det diagonalelementet av motsvarar helt enkelt -värdet mellan och .

En omskalad version av det adaptiva lassot av kan erhållas genom att ställa in . Om regressorer är okorrelerade, ges det ögonblick då aktiveras av det diagonalelementet i . Om vi antar för enkelhetens skull att är en vektor med nollor,

Det vill säga, om regressorer är okorrelerade, anger återigen den minimala påverkan av . Även när regressorer är korrelerade, inträffar första gången som en regressionsparameter aktiveras när är lika med det högsta diagonala elementet i .

Dessa resultat kan jämföras med en omskalad version av lassot genom att definiera , vilket är den genomsnittliga absoluta avvikelsen för från . Om man antar att regressorer är okorrelerade, så ges tidpunkten för aktivering av

För ges aktiveringsmomentet återigen av . Om är en vektor med nollor och en delmängd av är relevanta parametrar lika ansvariga för en perfekt passning av , då aktiveras denna delmängd vid ett -värde på . Momentet för aktivering av en relevant regressor är då lika med . Med andra ord, inkluderingen av irrelevanta regressorer fördröjer det ögonblick då relevanta regressorer aktiveras av detta omskalade lasso. Det adaptiva lassot och lassot är specialfall av en '1ASTc'-estimator. Den senare grupperar bara parametrar om den absoluta korrelationen mellan regressorer är större än ett användarspecificerat värde.

Bayesiansk tolkning

Precis som åsregression kan tolkas som linjär regression för vilken koefficienterna har tilldelats normala tidigare fördelningar , kan lasso tolkas som linjär regression för vilken koefficienterna har Laplace-fördelningar . Laplacefördelningen har en skarp topp vid noll (dess första derivata är diskontinuerlig vid noll) och den koncentrerar sin sannolikhetsmassa närmare noll än vad normalfördelningen gör. Detta ger en alternativ förklaring till varför lasso tenderar att sätta vissa koefficienter till noll, medan åsregression inte gör det.

Konvex avslappningstolkning

Lasso kan också ses som en konvex relaxation av det bästa delmängdselektionsregressionsproblemet, vilket går ut på att hitta delmängden av kovariater som resulterar i det minsta värdet av objektivfunktionen för vissa fasta , där n är det totala antalet kovariater. " -normen", , (antalet poster som inte är noll i en vektor), är det begränsande fallet för " normer", av formen är normer för eftersom inte är konvex för , så triangelolikheten håller inte). Därför, eftersom p = 1 är det minsta värdet för vilket " normen" är konvex (och därför faktiskt en norm), är lasso i någon mening den bästa konvexa approximationen till det bästa urvalsproblemet för delmängd, eftersom regionen som definieras av är det konvexa skrovet i regionen som definieras av för .

Generaliseringar

Lasso-varianter har skapats för att avhjälpa begränsningar i den ursprungliga tekniken och för att göra metoden mer användbar för särskilda problem. Nästan alla dessa fokuserar på att respektera eller utnyttja beroenden bland kovariaterna.

Elastisk nettoregularisering lägger till en ytterligare åsregressionsliknande straff som förbättrar prestandan när antalet prediktorer är större än urvalsstorleken, gör att metoden kan välja starkt korrelerade variabler tillsammans och förbättrar den totala prediktionsnoggrannheten.

Grupplasso tillåter grupper av relaterade kovariater att väljas som en enda enhet, vilket kan vara användbart i inställningar där det inte är meningsfullt att inkludera vissa kovariater utan andra. Ytterligare utökningar av grupplasso utför variabelval inom individuella grupper (gles grupplasso) och tillåter överlappning mellan grupper (överlappsgrupplasso).

Fused lasso kan redogöra för de rumsliga eller tidsmässiga egenskaperna hos ett problem, vilket resulterar i uppskattningar som bättre matchar systemstrukturen. Lasso-regulariserade modeller kan anpassas med hjälp av tekniker inklusive subgradientmetoder , minsta vinkelregression (LARS) och proximala gradientmetoder . Att fastställa det optimala värdet för regulariseringsparametern är en viktig del för att säkerställa att modellen fungerar bra; det väljs vanligtvis med hjälp av korsvalidering .

Elastiskt nät

2005 introducerade Zou och Hastie det elastiska nätet . När p > n (antalet kovariater är större än urvalsstorleken) kan lasso endast välja n kovariater (även när fler är associerade med resultatet) och den tenderar att välja en kovariat från vilken uppsättning av högkorrelerade kovariater som helst. Dessutom, även när n > p , tenderar åsregression att prestera bättre givet starkt korrelerade kovariater.

Det elastiska nätet förlänger lasso genom att lägga till ytterligare strafftid som ger

vilket motsvarar att lösa

Detta problem kan skrivas i en enkel lassoform

uthyrning

- , ,

Sedan vilket, när kovariaterna är ortogonala mot varandra, ger

Så resultatet av den elastiska nettostraffen är en kombination av effekterna av lasso- och ridge-straffen.

För att återgå till det allmänna fallet, det faktum att strafffunktionen nu är strikt konvex betyder att om , vilket är en förändring från lasso. I allmänhet, om

är provkorrelationsmatrisen eftersom är normaliserade.

Därför tenderar högkorrelerade kovariater att ha liknande regressionskoefficienter, med graden av likhet beroende på både och , som skiljer sig från lasso. Detta fenomen, där starkt korrelerade kovariater har liknande regressionskoefficienter, kallas för grupperingseffekten. Gruppering är önskvärt eftersom det i tillämpningar som att knyta gener till en sjukdom är att hitta alla associerade kovariater att föredra, snarare än att välja en från varje uppsättning av korrelerade kovariater, som lasso ofta gör. Att välja endast en från varje grupp resulterar dessutom vanligtvis i ökat prediktionsfel, eftersom modellen är mindre robust (vilket är anledningen till att åsregression ofta överträffar lasso).

Grupplasso

2006 introducerade Yuan och Lin grupplassot för att tillåta fördefinierade grupper av kovariater att gemensamt väljas in i eller ut ur en modell. Detta är användbart i många sammanhang, kanske mest uppenbart när en kategorisk variabel kodas som en samling binära kovariater. I det här fallet kan grupplasso säkerställa att alla variabler som kodar för den kategoriska kovariaten inkluderas eller exkluderas tillsammans. En annan miljö där gruppering är naturlig är i biologiska studier. Eftersom gener och proteiner ofta ligger i kända vägar, kan vilka vägar som är relaterade till ett utfall vara mer betydelsefulla än om enskilda gener är det. Objektivfunktionen för grupplassot är en naturlig generalisering av standardlassomålet

där designmatrisen och kovariatvektorn har ersatts av en samling designmatriser och kovariatvektorerna , en för var och en av J-grupperna. Dessutom är strafftermen nu en summa över normer definierade av de positiva definitiva matriserna . Om varje kovariat är i sin egen grupp och reduceras detta till standardlassot, medan om det bara finns en enda grupp och , det reduceras till åsregression. Eftersom straffet minskar till en -norm på de delrymden som definieras av varje grupp, kan den inte välja ut endast några av kovariaterna från en grupp, precis som åsregression inte kan. Men eftersom straffet är summan över de olika delrumsnormerna, som i standardlassot, har begränsningen några icke-differentiella punkter, som motsvarar att vissa delrum är identiskt noll. Därför kan den ställa in koefficientvektorerna som motsvarar vissa delrum till noll, medan andra bara krymper. Det är dock möjligt att utöka grupplassot till det så kallade sparse grupplassot, som kan välja individuella kovariater inom en grupp, genom att lägga till ytterligare straff till varje gruppdelrum. En annan förlängning, grupplasso med överlappning tillåter att kovariater delas mellan grupper, t.ex. om en gen skulle förekomma i två vägar.

Smält lasso

I vissa fall kan fenomenet som studeras ha en viktig rumslig eller tidsmässig struktur som måste beaktas vid analys, såsom tidsserier eller bildbaserad data. 2005 introducerade Tibshirani och kollegor det sammansmälta lassot för att utöka användningen av lasso till denna typ av data. Den sammansmälta lassoobjektivfunktionen är

Den första begränsningen är lasso-begränsningen, medan den andra direkt straffar stora förändringar med avseende på den tidsmässiga eller rumsliga strukturen, vilket tvingar koefficienterna att variera smidigt för att återspegla systemets underliggande logik. Clustered lasso är en generalisering av fused lasso som identifierar och grupperar relevanta kovariater baserat på deras effekter (koefficienter). Den grundläggande idén är att straffa skillnaderna mellan koefficienterna så att ettor som inte är noll kluster. Detta kan modelleras med hjälp av följande regularisering:

Däremot kan variabler klustras i högkorrelerade grupper, och sedan kan en enda representativ kovariat extraheras från varje kluster.

Algoritmer finns som löser det sammansmälta lassoproblemet, och några generaliseringar av det. Algoritmer kan lösa det exakt i ett begränsat antal operationer.

Kvasinormer och broregression

Lasso, elastiskt nät, grupp och smält lasso konstruerar strafffunktionerna från och -normerna (med vikter, om det behövs). Bryggegressionen använder allmänna normer ( ) och kvasinormer ( ). Till exempel, för p =1/2 är analogen till lassoobjektiv i lagrangisk form att lösa

var

Det hävdas att bråkkvasinormerna ( ) ger mer meningsfulla resultat i dataanalys både teoretiskt och empiriskt. Icke-konvexiteten hos dessa kvasinormer komplicerar optimeringsproblemet. För att lösa detta problem utvecklas och implementeras en förväntningsminimeringsprocedur för minimering av funktion

där är en godtyckligt konkav monotont ökande funktion (till exempel ger lassostraffet och ℓ straff).

Den effektiva algoritmen för minimering är baserad på bitvis kvadratisk approximation av subquadratic growth (PQSQ).

Adaptivt lasso

Det adaptiva lassot introducerades av Zou 2006 för linjär regression och av Zhang och Lu 2007 för proportionell riskregression.

Tidigare lasso

Det tidigare lassot introducerades för generaliserade linjära modeller av Jiang et al. under 2016 för att införliva förhandsinformation, såsom vikten av vissa kovariater. I föregående lasso sammanfattas sådan information till pseudosvar (kallade tidigare svar) och sedan läggs en ytterligare kriteriumfunktion till det vanliga målet fungera med en lassostraff. Utan förlust av generalitet, i linjär regression, kan den nya objektiva funktionen skrivas som

vilket motsvarar

den vanliga lasso objektivfunktionen där svaren ersätts av ett viktat medelvärde av de observerade svaren och de tidigare svaren svarsvärdena av tidigare information).

kallas parametern I extremfallet reduceras föregående lasso till lasso. Om , kommer tidigare lasso enbart att förlita sig på tidigare information för att passa modellen. Dessutom har balanseringsparametern en annan tilltalande tolkning: den styr variansen av i dess tidigare fördelning från en Bayesiansk synvinkel.

Prior lasso är effektivare vid parameteruppskattning och förutsägelse (med ett mindre uppskattningsfel och förutsägningsfel) när förhandsinformationen är av hög kvalitet, och är robust mot förhandsinformation av låg kvalitet med ett bra val av balanseringsparametern η { .

Datorlassolösningar

Förlustfunktionen hos lassot är inte differentierbar, men en mängd olika tekniker från konvex analys och optimeringsteori har utvecklats för att beräkna lassots lösningsväg. Dessa inkluderar koordinatnedstigning, subgradientmetoder, minsta vinkelregression (LARS) och proximala gradientmetoder. Subgradientmetoder är den naturliga generaliseringen av traditionella metoder som gradient descent och stokastisk gradient descent till det fall där den objektiva funktionen inte är differentierbar på alla punkter. LARS är en metod som är nära knuten till lassomodeller, och i många fall tillåter dem att passa effektivt, även om den kanske inte fungerar bra under alla omständigheter. LARS genererar kompletta lösningsvägar. Proximala metoder har blivit populära på grund av sin flexibilitet och prestanda och är ett område för aktiv forskning. Valet av metod kommer att bero på den specifika lassovarianten, data och tillgängliga resurser. Men proximala metoder fungerar i allmänhet bra.

Val av regulariseringsparameter

Att välja regulariseringsparametern ( ) är en grundläggande del av lasso. Ett bra värde är väsentligt för prestanda hos lassot eftersom det styr styrkan av krympning och variabelt urval, vilket med måtta kan förbättra både prediktionsnoggrannheten och tolkningsbarheten. Men om regulariseringen blir för stark kan viktiga variabler utelämnas och koefficienter kan krympas överdrivet, vilket kan skada både prediktiv kapacitet och inferens. Korsvalidering används ofta för att hitta regulariseringsparametern.

Informationskriterier som det Bayesianska informationskriteriet (BIC) och Akaike informationskriteriet (AIC) kan vara att föredra framför korsvalidering, eftersom de är snabbare att beräkna och deras prestanda är mindre flyktiga i små urval. Ett informationskriterium väljer skattarens regulariseringsparameter genom att maximera en modells noggrannhet i urvalet samtidigt som dess effektiva antal parametrar/frihetsgrader straffas. Zou et al. föreslagit att mäta de effektiva frihetsgraderna genom att räkna antalet parametrar som avviker från noll. Tillvägagångssättet för frihetsgrader ansågs vara felaktigt av Kaufman och Rosset och Janson et al., eftersom en modells frihetsgrader kan öka även när den straffas hårdare av regulariseringsparametern. Som ett alternativ kan det relativa enkelhetsmåttet som definierats ovan användas för att räkna det effektiva antalet parametrar. För lassot ges detta mått av

- ,

som monotont ökar från noll till när regulariseringsparametern minskar från till noll.

Utvalda applikationer

LASSO har använts inom ekonomi och finans, och visade sig förbättra förutsägelser och välja ibland försummade variabler, till exempel i litteratur om företagskonkurser eller förutsägelser av företag med hög tillväxt.

![{\displaystyle s\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aff1a54fbbee4a2677039524a5139e952fa86eb9)

![{\displaystyle {\begin{aligned}&\min _{\beta }\left\{{\frac {1}{N}}\sum _{i=1}^{N}\left(y_{i}-x_{i}^{t}\beta \right)^{2}\right\}\\[4pt]&{\text{ subject to }}\sum _{j=1}^{p}|\beta _{j}|\leq t_{1}{\text{ and }}\sum _{j=2}^{p}|\beta _{j}-\beta _{j-1}|\leq t_{2}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a75f99fe3b19232504b470197d1158638ad10255)