Kunskapsgrafinbäddning

Inom representationsinlärning är kunskapsgrafinbäddning ( KGE ) , även kallad kunskapsrepresentationsinlärning ( KRL ), eller multi-relation learning , en maskininlärningsuppgift för att lära sig en lågdimensionell representation av en kunskapsgrafs entiteter och relationer samtidigt som bevara sin semantiska betydelse. Genom att utnyttja sin inbäddade representation kan kunskapsgrafer (KG) användas för olika applikationer som länkförutsägelse , trippelklassificering, enhetsigenkänning, klustring och utvinning av relationer .

Definition

En kunskapsgraf är en samling entiteter , relationer , och fakta . Ett faktum är en trippel som anger en länk mellan huvudet och svansen av trippeln. En annan notation som ofta används i litteraturen för att representera en trippel (eller faktum) är . Denna notation kallas resursbeskrivningsramverk (RDF). En kunskapsgraf representerar kunskapen relaterad till en specifik domän; genom att utnyttja denna strukturerade representation är det möjligt att dra slutsatser om en ny kunskap från den efter några förfiningssteg. Men nuförtiden måste människor hantera sparsamheten med data och den beräkningsmässiga ineffektiviteten för att använda dem i en verklig tillämpning.

Inbäddningen av en kunskapsgraf översätter varje entitet och relation för en kunskapsgraf, till en vektor med en given dimension , kallad inbäddningsdimension. I det allmänna fallet kan vi ha olika inbäddningsdimensioner för entiteterna och relationerna . Samlingen av inbäddningsvektorer för alla entiteter och relationer i kunskapsgrafen är en mer tät och effektiv representation av domänen som lättare kan användas för många olika uppgifter.

En kunskapsgrafinbäddning kännetecknas av fyra olika aspekter:

- Representationsrum: Det lågdimensionella utrymme där enheterna och relationerna är representerade.

- Poängfunktion: Ett mått på hur bra en trippel inbäddad representation är.

- Kodningsmodeller: Den modalitet i vilken den inbäddade representationen av enheterna och relationerna interagerar med varandra.

- Ytterligare information: All ytterligare information som kommer från kunskapsdiagrammet som kan berika den inbäddade representationen. Vanligtvis är en ad hoc-poängfunktion integrerad i den allmänna poängfunktionen för varje ytterligare information.

Inbäddningsprocedur

Alla de olika inbäddningsmodellerna för kunskapsgrafer följer ungefär samma procedur för att lära sig den semantiska innebörden av fakta. Först och främst, för att lära sig en inbäddad representation av en kunskapsgraf, initieras inbäddningsvektorerna för enheterna och relationerna till slumpmässiga värden. Sedan, med start från en träningsuppsättning tills ett stoppvillkor uppnås, optimerar algoritmen kontinuerligt inbäddningarna. Vanligtvis ges stoppvillkoret av överpassningen över träningssetet. För varje iteration samplas en sats av storlek från träningsuppsättningen, och för varje trippel av satsen samplas ett slumpmässigt korrupt faktum - dvs en trippel som inte representerar ett sant faktum i kunskapsgrafen . Korruptionen av en trippel innebär att trippelns huvud eller svans (eller båda) ersätts med en annan enhet som gör faktumet falskt. Den ursprungliga trippeln och den skadade trippeln läggs till i träningsbatchen, och sedan uppdateras inbäddningarna, vilket optimerar en poängfunktion. I slutet av algoritmen borde de inlärda inbäddningarna ha extraherat den semantiska betydelsen från trippeln och bör korrekt osynliga sanna fakta i kunskapsgrafen.

Pseudokod

Följande är pseudokoden för den allmänna inbäddningsproceduren.

algoritm Beräkna entitets- och relationsinbäddningar matas in: Träningsuppsättningen , entitetsuppsättning , relationsuppsättning , inbäddningsdimension utdata: Entitets- och relationsinbäddningar initialisering: entiteterna och relationer inbäddningar (vektorer) initieras slumpmässigt medan stop skick do // Ur träningssetet slumpmässigt ta ett parti av storlek b för varje i gör // sample a corrupted fact of triple slut för Uppdatera inbäddningar genom att minimera förlustfunktionen end while

Resultatindikatorer

Dessa index används ofta för att mäta inbäddningskvaliteten hos en modell. Indexens enkelhet gör dem mycket lämpliga för att utvärdera prestandan för en inbäddningsalgoritm även i stor skala. Givet som uppsättningen av alla rankade förutsägelser av en modell, är det möjligt att definiera tre olika prestandaindex: Hits@K, MR och MRR.

Hits@K

Hits@K eller kort och gott, H@K, är ett prestationsindex som mäter sannolikheten att hitta rätt förutsägelse i de första K-modellförutsägelserna. Vanligtvis används det . Hits@K återspeglar noggrannheten hos en inbäddningsmodell för att förutsäga förhållandet mellan två givna trippel korrekt.

Hits@K

Större värden innebär bättre prediktiva prestationer.

Genomsnittlig rang (MR)

Medelrankning är den genomsnittliga rankningspositionen för objekten som förutspås av modellen bland alla möjliga objekt.

Ju mindre värde, desto bättre modell.

Mean reciprocal rank (MRR)

Genomsnittlig reciprok rang mäter antalet trippel som förutspås korrekt. Om den första förutsagda trippeln är korrekt, läggs 1 till, om den andra är korrekt summeras

Mean reciprocal rank används vanligtvis för att kvantifiera effekten av sökalgoritmer.

Ju större index, desto bättre modell.

Ansökningar

Maskininlärningsuppgifter

Knowledge graph completion (KGC) är en samling tekniker för att härleda kunskap från en inbäddad kunskapsgrafrepresentation. I synnerhet fullbordar denna teknik en trippel slutsats av den saknade enheten eller relationen. Motsvarande deluppgifter kallas länk- eller entitetsprediktion (dvs. att gissa en entitet från inbäddningen givet den andra entiteten av trippeln och relationen), och relationsprediktion (dvs. att prognostisera den mest troliga relationen som förbinder två entiteter).

Trippelklassificering är ett binärt klassificeringsproblem. Givet en trippel utvärderar den tränade modellen sannolikheten för trippeln med hjälp av inbäddningen för att avgöra om en trippel är sann eller falsk. Beslutet tas med modellpoängfunktionen och en given tröskel. Clustering är en annan applikation som utnyttjar den inbäddade representationen av en gles kunskapsgraf för att kondensera representationen av liknande semantiska enheter nära i ett 2D-utrymme.

Verkliga applikationer

Användningen av inbäddning av kunskapsgrafer är alltmer genomgripande i många applikationer. När det gäller rekommendatorsystem kan användningen av kunskapsgrafinbäddning övervinna begränsningarna med den vanliga förstärkningsinlärningen . Att träna denna typ av rekommendationssystem kräver en enorm mängd information från användarna; Kunskapsgraftekniker kan dock lösa detta problem genom att använda en graf som redan är konstruerad över en tidigare kunskap om artikelkorrelationen och genom att använda inbäddningen för att härleda rekommendationen. Återanvändning av läkemedel är användningen av ett redan godkänt läkemedel, men för ett terapeutiskt syfte som skiljer sig från det som det ursprungligen utformades för. Det är möjligt att använda uppgiften att förutsäga länkar för att sluta sig till ett nytt samband mellan ett redan existerande läkemedel och en sjukdom genom att använda en biomedicinsk kunskapsgraf byggd som utnyttjar tillgången på massiv litteratur och biomedicinska databaser. Kunskapsgrafinbäddning kan också användas inom socialpolitikens domän.

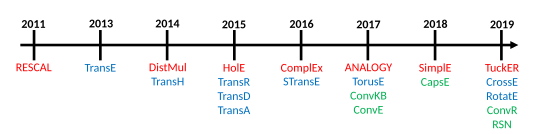

Modeller

samling trippel (eller fakta) , producerar kunskapsgrafens inbäddningsmodell, för varje entitet och relation som finns i kunskapsgrafen, en kontinuerlig vektorrepresentation. är motsvarande inbäddning av en trippel med och där är inbäddningsdimensionen för entiteterna, och för relationerna. Poängfunktionen för en given modell betecknas med och mäter avståndet mellan huvudets inbäddning och inbäddningen av svans med tanke på inbäddningen av relationen, eller med andra ord, den kvantifierar rimligheten i den inbäddade representationen av ett givet faktum.

Rossi et al. föreslå en taxonomi av inbäddningsmodellerna och identifierar tre huvudfamiljer av modeller: tensorupplösningsmodeller, geometriska modeller och modeller för djupinlärning.

Tensornedbrytningsmodell

Tensorupplösningen är en familj av kunskapsgrafmodeller som använder en flerdimensionell matris för att representera en kunskapsgraf, som delvis är kännbar på grund av luckorna i kunskapsgrafen som beskriver en viss domän noggrant. I synnerhet använder dessa modeller en trevägs (3D) tensor , som sedan faktoriseras till lågdimensionella vektorer som är entiteter och relationsinbäddningar. Tredje ordningens tensor är en lämplig metod för att representera en kunskapsgraf eftersom den endast registrerar existensen eller frånvaron av en relation mellan enheter, och av denna anledning är den enkel, och det finns inget behov av att på förhand känna till nätverksstrukturen, vilket gör denna klass av inbäddningsmodeller är lätta och lätta att träna även om de lider av högdimensionella och sparsamma data.

Bilinjära modeller

Denna familj av modeller använder en linjär ekvation för att bädda in kopplingen mellan enheterna genom en relation. I synnerhet är den inbäddade representationen av relationerna en tvådimensionell matris. Dessa modeller, under inbäddningsproceduren, använder endast de enskilda fakta för att beräkna den inbäddade representationen och ignorerar de andra associationerna till samma enhet eller relation.

- DistMult : Eftersom relationens inbäddningsmatris är en diagonal matris, kan poängfunktionen inte särskilja asymmetriska fakta.

- ComlEx : Eftersom DistMult använder en diagonal matris för att representera relationernas inbäddning men lägger till en representation i det komplexa vektorrummet och den hermitiska produkten , kan den särskilja symmetriska och asymmetriska fakta. Detta tillvägagångssätt är skalbart till en stor kunskapsgraf i termer av tids- och platskostnad.

- ANALOGI : Denna modell kodar i inbäddningen av den analoga strukturen av kunskapsgrafen för att simulera induktivt resonemang. Genom att använda en differentierbar objektiv funktion har ANALOGI god teoretisk generalitet och beräkningsmässig skalbarhet. Det är bevisat att inbäddningen som produceras av ANALOGY helt återställer inbäddningen av DistMult, ComlEx och HolE.

- Enkel : Denna modell är förbättringen av kanonisk polyadisk nedbrytning (CP), där en inbäddningsvektor för relationen och två oberoende inbäddningsvektorer för varje entitet lärs in, beroende på om det är ett huvud eller en svans i kunskapsgraffaktumet. SimplE löser problemet med oberoende inlärning av de två entitetsinbäddningarna med hjälp av en omvänd relation och genomsnittet av CP-poängen för och . På detta sätt samlar SimplE relationen mellan entiteter medan de uppträder i rollen som subjekt eller objekt inuti ett faktum, och det kan bädda in asymmetriska relationer.

Icke-bilinjära modeller

- HolE: HolE använder cirkulär korrelation för att skapa en inbäddad representation av kunskapsgrafen, som kan ses som en komprimering av matrisprodukten, men är mer beräkningseffektiv och skalbar samtidigt som den behåller förmågan att uttrycka asymmetrisk relation eftersom den cirkulära korrelationen inte är kommutativ . HolE länkar holografiska och komplexa inbäddningar eftersom de, om de används tillsammans med Fourier , kan ses som ett specialfall av ComplEx.

- TuckER: TuckER ser kunskapsgrafen som en tensor som skulle kunna dekomponeras med hjälp av Tucker-nedbrytningen i en samling vektorer – dvs inbäddningar av entiteter och relationer – med en delad kärna. Vikterna för kärntensorn lärs in tillsammans med inbäddningarna och representerar nivån på interaktionen mellan posterna. Varje entitet och relation har sin egen inbäddningsdimension, och storleken på kärntensorn bestäms av formen på de entiteter och relationer som samverkar. Inbäddningen av ämnet och objektet för ett faktum summeras på samma sätt, vilket gör TuckER fullt uttrycksfullt, och andra inbäddningsmodeller som RESCAL, DistMult, ComlEx och SimplE kan uttryckas som en speciell formulering av TuckER.

- MEI: MEI introducerar interaktionstekniken för inbäddning av flera partier med blocktermens tensorformat, som är en generalisering av CP-nedbrytning och Tucker-nedbrytning. Den delar in inbäddningsvektorn i flera partitioner och lär sig de lokala interaktionsmönstren från data istället för att använda fasta specialmönster som i ComlEx- eller SimplE-modeller. Detta gör det möjligt för MEI att uppnå optimal effektivitet - en avvägning mellan uttrycksfullhet, inte bara att vara helt uttrycksfull. Tidigare modeller som TuckER, RESCAL, DistMult, ComplEx och SimplE är suboptimala begränsade specialfall av MEI.

- MEIM: MEIM går utöver blocktermens tensorformat för att introducera den oberoende kärntensorn för ensembleförstärkande effekter och den mjuka ortogonaliteten för max-rank relationell mappning, förutom multi-partition inbäddningsinteraktion. MEIM generaliserar flera tidigare modeller som MEI och dess underordnade modeller, RotaE och QuatE. MEIM förbättrar uttrycksförmågan samtidigt som den är mycket effektiv i praktiken, vilket hjälper den att uppnå bra resultat med relativt små modellstorlekar.

Geometriska modeller

Det geometriska utrymmet som definieras av denna familj av modeller kodar för relationen som en geometrisk transformation mellan huvudet och svansen av ett faktum. Av denna anledning, för att beräkna inbäddningen av svansen, är det nödvändigt att tillämpa en transformation på huvudinbäddningen, och en avståndsfunktion används för att mäta godheten hos inbäddning eller för att bedöma ett faktums tillförlitlighet.

Geometriska modeller liknar tensorupplösningsmodellen, men den största skillnaden mellan de två är att de måste bevara tillämpligheten av transformationen i det geometriska utrymme där den definieras.

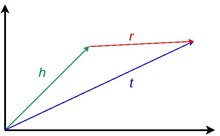

Rena translationsmodeller

Denna klass av modeller är inspirerad av idén om översättningsinvarians som introducerades i word2vec . En ren translationsmodell förlitar sig på det faktum att entiteternas inbäddningsvektor är nära varandra efter att ha tillämpat en korrekt relationsöversättning i det geometriska utrymme där de definieras. Med andra ord, givet ett faktum, när inbäddningen av huvudet läggs till inbäddningen av relationen, bör det förväntade resultatet vara inbäddningen av svansen. Närheten hos de inbäddade enheterna ges av något avståndsmått och kvantifierar tillförlitligheten av ett faktum.

- TransE : Denna modell använder en poängfunktion som tvingar inbäddningarna att uppfylla en enkel vektorsummekvation i varje fakta där de förekommer: . Inbäddningen kommer att vara exakt om varje entitet och relation förekommer i endast ett faktum, och av denna anledning, i praktiken inte representerar en-till-många , många-till-en och asymmetriska relationer.

- TransH : Det är en utveckling av TransE som introducerar ett hyperplan som geometriskt utrymme för att lösa problemet med att korrekt representera typerna av relationer. I TransH har varje relation en annan inbäddad representation, på ett annat hyperplan, baserat på vilka entiteter den interagerar med. Därför, för att beräkna, till exempel, poängfunktionen för ett faktum, måste den inbäddade representationen av huvudet och svansen projiceras med hjälp av en relationsprojektionsmatris på det korrekta hyperplanet av relationen.

- TransR : TransR är en utveckling av TransH eftersom den använder två olika utrymmen för att representera den inbäddade representationen av enheterna och relationerna, och helt separera det semantiska rummet av enheter och relationer. TransR använder också en relationsprojektionsmatris för att översätta inbäddningen av enheterna till relationsutrymmet.

- TransD : Givet ett faktum, i TransR, kan huvudet och svansen på ett faktum tillhöra två olika typer av enheter, till exempel i faktumet Obama och USA är två enheter men den ena är en person och den andra är ett land. Matrismultiplikationen är också en dyr procedur i TransR för att beräkna projektionen. I detta sammanhang använder TransD två vektorer för varje entitetsrelationspar för att beräkna en dynamisk mappning som ersätter projektionsmatrisen samtidigt som den dimensionella komplexiteten reduceras. Den första vektorn används för att representera den semantiska betydelsen av enheterna och relationerna, den andra för att beräkna mappningsmatrisen.

- TransA: Alla translationella modeller definierar en poängfunktion i sitt representationsutrymme, men de förenklar denna metriska förlust. Eftersom vektorrepresentationen av enheterna och relationerna inte är perfekt, kan en ren översättning av vara avlägsen från , och ett sfäriskt ekvipotentiellt euklidiskt avstånd gör det svårt att urskilja vilka är den närmaste enheten. TransA introducerar istället ett adaptivt Mahalanobis-avstånd för att väga inbäddningsdimensionerna, tillsammans med elliptiska ytor för att ta bort tvetydigheten.

Translationella modeller med ytterligare inbäddningar

Det är möjligt att associera ytterligare information till varje element i kunskapsdiagrammet och deras gemensamma representationsfakta. Varje enhet och relation kan berikas med textbeskrivningar, vikter, begränsningar och annat för att förbättra den övergripande beskrivningen av domänen med en kunskapsgraf. Under inbäddningen av kunskapsgrafen kan denna information användas för att lära sig specialiserade inbäddningar för dessa egenskaper tillsammans med den vanliga inbäddade representationen av entiteter och relationer, med kostnaden för att lära sig ett mer betydande antal vektorer.

- STransE: Denna modell är resultatet av kombinationen av TransE och av strukturens inbäddning på ett sådant sätt att den bättre kan representera en-till-många-, många-till-en- och många-till-många- relationerna . För att göra det involverar modellen ytterligare två oberoende matriser och för varje inbäddad relation i KG. Varje ytterligare matris används baserat på det faktum att den specifika relationen interagerar med huvudet eller svansen av faktumet. Med andra ord, givet ett faktum , innan vektoröversättningen tillämpas, multipliceras huvudet och svansen multipliceras med .

- CrossE : Crossover-interaktioner kan användas för relaterat informationsval och kan vara mycket användbart för inbäddningsproceduren. Crossover-interaktioner ger två distinkta bidrag i informationsurvalet: interaktioner från relationer till enheter och interaktioner från enheter till relationer. Detta innebär att en relation, t.ex. 'president_of', automatiskt väljer de typer av enheter som kopplar subjektet till objektet för ett faktum. På ett liknande sätt avgör entiteten av ett faktum indirekt vilken som är inferensväg som måste väljas för att förutsäga objektet för en relaterad trippel. CrossE, för att göra det, lär sig en ytterligare interaktionsmatris , använder den elementmässiga produkten för att beräkna interaktionen mellan och . Även om CrossE inte förlitar sig på en neural nätverksarkitektur, visas det att denna metod kan kodas i en sådan arkitektur.

Roto-translationsmodeller

Denna familj av modeller, utöver eller som ersättning för en translation, använder de en rotationsliknande transformation.

- TorusE: Reguleringstermen för TransE gör att entiteten bäddas in i ett byggt sfäriskt utrymme och förlorar följaktligen översättningsegenskaperna för det geometriska utrymmet. För att lösa detta problem utnyttjar TorusE användningen av en kompakt Lie-grupp som i detta specifika fall är n-dimensionell torusrymd , och undviker användningen av regularisering. TorusE definierar avståndsfunktionerna för att ersätta L1- och L2-normerna för TransE.

- RotatE: RotatE är inspirerad av Eulers identitet och involverar användningen av Hadmard-produkten för att representera en relation som en rotation från huvudet till svansen i komplexet Plats. För varje element i trippeln beskriver den komplexa delen av inbäddningen en moturs rotation i förhållande till en axel, som kan beskrivas med Eulers identitet, medan modulen för relationsvektorn är 1. Det visas att modellen kan inbädda symmetriska, asymmetriska, inversions- och sammansättningsrelationer från kunskapsgrafen.

Modeller för djupinlärning

Denna grupp av inbäddningsmodeller använder djupa neurala nätverk för att lära sig mönster från kunskapsdiagrammet som är indata. Dessa modeller har generelliteten att särskilja typen av entitet och relation, tidsinformation, väginformation, underliggande strukturerad information och lösa begränsningarna hos avståndsbaserade och semantiskt matchningsbaserade modeller när det gäller att representera alla funktioner i en kunskapsgraf. Användningen av djupinlärning för inbäddning av kunskapsgrafer har visat bra prediktiv prestanda även om de är dyrare i träningsfasen, arga på data och ofta krävde en förtränad inbäddningsrepresentation av kunskapsgraf som kommer från en annan inbäddningsmodell.

Konvolutionella neurala nätverk

Denna familj av modeller, istället för att använda helt anslutna lager, använder ett eller flera faltningslager som konvolverar indata genom att applicera ett lågdimensionellt filter som kan bädda in komplexa strukturer med få parametrar genom att lära sig icke-linjära egenskaper.

- ConvE: ConvE är en inbäddningsmodell som representerar en bra avvägningsuttrycksförmåga för modeller för djupinlärning och beräkningskostnad, i själva verket har det visat sig att den använde 8 gånger färre parametrar jämfört med DistMult. ConvE använder en endimensionell -storlek för att representera entiteterna och relationerna i en kunskapsgraf. För att beräkna poängfunktionen för en trippel använder ConvE en enkel procedur: sammanfogar och slår först samman inbäddningarna av trippelns huvud och relationen i en enda data då används denna matris som indata för 2D-faltningsskiktet. Resultatet passerar sedan genom ett tätt lager som tillämpar en linjär transformation parametriserad av matrisen och i slutet, med den inre produkten kopplad till svanstrippeln. ConvE är också särskilt effektivt i utvärderingsproceduren: med en 1-N-poängning matchar modellen, givet ett huvud och en relation, alla svansar samtidigt, vilket sparar mycket utvärderingstid jämfört med 1-1-utvärderingen program för de andra modellerna.

- ConvR: ConvR är ett adaptivt faltningsnätverk som syftar till att djupt representera alla möjliga interaktioner mellan enheterna och relationerna. För denna uppgift beräknar ConvR faltningsfilter för varje relation, och, när så krävs, tillämpar dessa filter på entiteten av intresse för att extrahera slingrande funktioner. Proceduren för att beräkna poängen för trippel är densamma som ConvE.

- ConvKB: ConvKB, för att beräkna poängfunktionen för en given trippel , producerar den en indata av dimensionen utan att omforma och skickar den till serier av faltningsfilter av storlek . Detta resultat matar ett tätt lager med endast en neuron som producerar slutresultatet. Den enda slutliga neuronen gör denna arkitektur som en binär klassificerare där faktumet kan vara sant eller falskt. En skillnad med ConvE är att entiteternas dimensionalitet inte ändras.

Kapsel neurala nätverk

Denna familj av modeller använder kapselneurala nätverk för att skapa en mer stabil representation som kan känna igen en funktion i inmatningen utan att förlora rumslig information. Nätverket är sammansatt av faltningslager, men de är organiserade i kapslar, och det övergripande resultatet av en kapsel skickas till en högre kapsel som bestäms av en dynamisk processrutin.

- CapsE: CapsE implementerar ett kapselnätverk för att modellera ett faktum . Liksom i ConvKB är varje trippelelement sammanlänkade för att bygga en matris och används för att mata till ett faltningslager för att extrahera faltningsfunktionerna. Dessa funktioner omdirigeras sedan till en kapsel för att producera en kontinuerlig vektor, mer är vektorn lång, mer faktum är sant.

Återkommande neurala nätverk

Denna klass av modeller utnyttjar användningen av återkommande neurala nätverk . Fördelen med denna arkitektur är att memorera en sekvens av fakta, snarare än att bara utarbeta enskilda händelser.

- RSN: Under inbäddningsproceduren antas vanligtvis att liknande enheter har liknande relationer. I praktiken utnyttjas inte denna typ av information, eftersom inbäddningen beräknas bara på det undergående faktumet snarare än en historia av fakta. Recurrent skipping networks (RSN) använder ett återkommande neuralt nätverk för att lära sig relationsvägar med hjälp av ett slumpmässigt urval.

Modellens prestanda

Maskininlärningsuppgiften för kunskapsgrafinbäddning som oftare används för att utvärdera modellernas inbäddningsprecision är länkförutsägelsen. Rossi et al. tagit fram ett omfattande riktmärke av modellerna, men även andra undersökningar ger liknande resultat. Riktmärket , WN18RR och YAGO3-10. På senare tid har det diskuterats att dessa datauppsättningar är långt borta från verkliga applikationer, och andra datauppsättningar bör integreras som ett standardriktmärke.

| Datauppsättningens namn | Antal olika enheter | Antal olika relationer | Antal trippel |

|---|---|---|---|

| FB15k | 14951 | 1345 | 584,113 |

| WN18 | 40943 | 18 | 151,442 |

| FB15k-237 | 14541 | 237 | 310,116 |

| WN18RR | 40943 | 11 | 93 003 |

| YAGO3-10 | 123182 | 37 | 1 089 040 |

| Modellnamn | Minneskomplexitet | FB15K (Hits@10) | FB15K (MR) | FB15K (MRR) | FB15K - 237 (Träffar@10) | FB15K - 237 (MR) | FB15K - 237 (MRR) | WN18 (Träffar@10) | WN18 (MR) | WN18 (MRR) | WN18RR (Träffar@10) | WN18RR (MR) | WN18RR (MRR) | YAGO3-10 (Träffar@10) | YAGO3-10 (MR) | YAGO3-10 (MRR) |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| DistMul | 0,863 | 173 | 0,784 | 0,490 | 199 | 0,313 | 0,946 | 675 | 0,824 | 0,502 | 5913 | 0,433 | 0,661 | 1107 | 0,501 | |

| Komplex | 0,905 | 34 | 0,848 | 0,529 | 202 | 0,349 | 0,955 | 3623 | 0,949 | 0,521 | 4907 | 0,458 | 0,703 | 1112 | 0,576 | |

| Hål | 0,867 | 211 | 0,800 | 0,476 | 186 | 0,303 | 0,949 | 650 | 0,938 | 0,487 | 8401 | 0,432 | 0,651 | 6489 | 0,502 | |

| ANALOGI | 0,837 | 126 | 0,726 | 0,353 | 476 | 0,202 | 0,944 | 808 | 0,934 | 0,380 | 9266 | 0,366 | 0,456 | 2423 | 0,283 | |

| Enkel | 0,836 | 138 | 0,726 | 0,343 | 651 | 0,179 | 0,945 | 759 | 0,938 | 0,426 | 8764 | 0,398 | 0,631 | 2849 | 0,453 | |

| TuckER | 0,888 | 39 | 0,788 | 0,536 | 162 | 0,352 | 0,958 | 510 | 0,951 | 0,514 | 6239 | 0,459 | 0,680 | 2417 | 0,544 | |

| MEI | 0,552 | 145 | 0,365 | 0,551 | 3268 | 0,481 | 0,709 | 756 | 0,578 | |||||||

| MEIM | 0,557 | 137 | 0,369 | 0,577 | 2434 | 0,499 | 0,716 | 747 | 0,585 | |||||||

| TransE | 0,847 | 45 | 0,628 | 0,497 | 209 | 0,310 | 0,948 | 279 | 0,646 | 0,495 | 3936 | 0,206 | 0,673 | 1187 | 0,501 | |

| STransE | 0,796 | 69 | 0,543 | 0,495 | 357 | 0,315 | 0,934 | 208 | 0,656 | 0,422 | 5172 | 0,226 | 0,073 | 5797 | 0,049 | |

| CrossE | 0,862 | 136 | 0,702 | 0,470 | 227 | 0,298 | 0,950 | 441 | 0,834 | 0,449 | 5212 | 0,405 | 0,654 | 3839 | 0,446 | |

| TorusE | 0,839 | 143 | 0,746 | 0,447 | 211 | 0,281 | 0,954 | 525 | 0,947 | 0,535 | 4873 | 0,463 | 0,474 | 19455 | 0,342 | |

| Rotera | 0,881 | 42 | 0,791 | 0,522 | 178 | 0,336 | 0,960 | 274 | 0,949 | 0,573 | 3318 | 0,475 | 0,570 | 1827 | 0,498 | |

| ConvE | 0,849 | 51 | 0,688 | 0,521 | 281 | 0,305 | 0,956 | 413 | 0,945 | 0,507 | 4944 | 0,427 | 0,657 | 2429 | 0,488 | |

| ConvKB | 0,408 | 324 | 0,211 | 0,517 | 309 | 0,230 | 0,948 | 202 | 0,709 | 0,525 | 3429 | 0,249 | 0,604 | 1683 | 0,420 | |

| ConvR | 0,885 | 70 | 0,773 | 0,526 | 251 | 0,346 | 0,958 | 471 | 0,950 | 0,526 | 5646 | 0,467 | 0,673 | 2582 | 0,527 | |

| CapsE | 0,217 | 610 | 0,087 | 0,356 | 405 | 0,160 | 0,950 | 233 | 0,890 | 0,559 | 720 | 0,415 | 0 | 60676 | 0,000 | |

| RSN | 0,870 | 51 | 0,777 | 0,444 | 248 | 0,280 | 0,951 | 346 | 0,928 | 0,483 | 4210 | 0,395 | 0,664 | 1339 | 0,511 |

Bibliotek

- KGE på GitHub

- MEI-KGE på GitHub

- Pykg2vec på GitHub

- DGL-KE på GitHub

- PyKEEN på GitHub

- TorchKGE på GitHub

- AmpliGraph på GitHub

- OpenKE på GitHub

- scikit-kge på GitHub

- Fast-TransX på GitHub

- MEIM-KGE på GitHub

Se även

- Kunskapsdiagram

- Inbäddning

- Maskininlärning

- Kunskapsbas

- Kunskapsutvinning

- Statistiskt relationellt lärande

- Representationsinlärning

- Grafinbäddning

- ^ a b c d e f g h i j k l m n o p q r s t u v w x y z aa Ji, Shaoxiong; Pan, Shirui; Cambria, Erik; Marttinen, Pekka; Yu, Philip S. (2021). "En undersökning om kunskapsdiagram: representation, förvärv och tillämpningar" . IEEE-transaktioner på neurala nätverk och inlärningssystem . PP (2): 494–514. arXiv : 2002.00388 . doi : 10.1109/TNNLS.2021.3070843 . hdl : 10072/416709 . ISSN 2162-237X . PMID 33900922 . S2CID 211010433 .

- ^ Mohamed, Sameh K; Nováček, Vít; Nounu, Aayah (2019-08-01). Cowen, Lenore (red.). "Upptäcka proteinläkemedelsmål med hjälp av kunskapsdiagraminbäddningar" . Bioinformatik . 36 (2): 603–610. doi : 10.1093/bioinformatics/btz600 . hdl : 10379/15375 . ISSN 1367-4803 . PMID 31368482 .

- ^ a b c d Lin, Yankai; Han, Xu; Xie, Ruobing; Liu, Zhiyuan; Sun, Maosong (2018-12-28). "Kunskapsrepresentation Learning: A Quantitative Review". arXiv : 1812.10901 [ cs.CL ].

- ^ a b c Abu-Salih, Bilal; Al-Tawil, Marwan; Aljarah, Ibrahim; Faris, Hossam; Wongthongtham, Pornpit; Chan, Kit Yan; Beheshti, Amin (2021-05-12). "Relationellt lärande analys av socialpolitik med hjälp av inbäddning av kunskapsdiagram" . Data Mining och Knowledge Discovery . 35 (4): 1497–1536. arXiv : 2006.01626 . doi : 10.1007/s10618-021-00760-w . ISSN 1573-756X . S2CID 219179556 .

- ^ a b c d e f g h i j k l m n o p q r s t u v w x y z aa ab ac ad ae af ag ah ai aj ak al am an ao ap aq ar som Rossi, Andrea; Barbosa, Denilson; Firmani, Donatella; Matinata, Antonio; Merialdo, Paolo (2020). "Kunskapsgrafinbäddning för länkförutsägelse: en jämförande analys" . ACM-transaktioner på kunskapsupptäckt från data . 15 (2): 1–49. arXiv : 2002.00819 . doi : 10.1145/3424672 . ISSN 1556-4681 . S2CID 211011226 .

- ^ a b Paulheim, Heiko (2016-12-06). Cimiano, Philipp (red.). "Kunskapsgrafförfining: En undersökning av tillvägagångssätt och utvärderingsmetoder" . Semantisk webb . 8 (3): 489–508. doi : 10.3233/SW-160218 .

- ^ a b c d e f g h i j k l m n o p q r s t u v w x y z aa ab ac Dai, Yuanfei; Wang, Skeppning; Xiong, Neal N.; Guo, Wenzhong (maj 2020). "En undersökning om inbäddning av kunskapsdiagram: tillvägagångssätt, tillämpningar och benchmarks" . Elektronik . 9 (5): 750. doi : 10.3390/electronics9050750 .

- ^ Guo, Shu; Wang, Quan; Wang, Bin; Wang, Lihong; Guo, Li (2015). "Semantiskt jämn inbäddning av kunskapsdiagram" . Handlingar från det 53:e årsmötet för Association for Computational Linguistics och den 7:e internationella gemensamma konferensen om naturlig språkbehandling (Volume 1: Long Papers) . Peking, Kina: Association for Computational Linguistics: 84–94. doi : 10.3115/v1/P15-1009 . S2CID 205692 .

- ^ a b c d e f g Bordes, Antoine; Usunier, Nicolas; Garcia-Durán, Alberto; Weston, Jason; Yakhnenko, Oksana (maj 2013). "Översätta inbäddningar för modellering av multirelationella data" . Proceedings of the 26th International Conference on Neural Information Processing Systems - Volym 2 . NIPS'13. Lake Tahoe, Nevada: Curran Associates Inc.: 2787–2795.

- ^ a b c d e f g h i j k l Chen, Zhe; Wang, Yuehan; Zhao, Bin; Cheng, Jing; Zhao, Xin; Duan, Zongtao (2020). "Färdigställande av kunskapsdiagram: En recension" . IEEE Access . 8 : 192435–192456. doi : 10.1109/ACCESS.2020.3030076 . ISSN 2169-3536 . S2CID 226230006 .

- ^ a b c d e Cai, Hongyun; Zheng, Vincent W.; Chang, Kevin Chen-Chuan (2018-02-02). "En omfattande undersökning av grafinbäddning: problem, tekniker och tillämpningar". arXiv : 1709.07604 [ cs.AI ].

- ^ a b Zhou, Sijin; Dai, Xinyi; Chen, Haokun; Zhang, Weinan; Ren, Kan; Tang, Ruiming; Han, Xiuqiang; Yu, Yong (2020-06-18). "Interactive Recommender System via Knowledge Graph-enhanced Reinforcement Learning". arXiv : 2006.10389 [ cs.IR ].

- ^ Liu, Chan; Li, Lun; Yao, Xiaolu; Tang, Lin (augusti 2019). "En undersökning av rekommendationsalgoritmer baserade på inbäddning av kunskapsdiagram" . 2019 IEEE International Conference on Computer Science and Educational Informatization (CSEI) : 168–171. doi : 10.1109/CSEI47661.2019.8938875 . ISBN 978-1-7281-2308-0 . S2CID 209459928 .

- ^ a b Sosa, Daniel N.; Derry, Alexander; Guo, Margaret; Wei, Eric; Brinton, Connor; Altman, Russ B. (2020). "En litteraturbaserad metod för inbäddning av kunskapsdiagram för att identifiera möjligheter för återanvändning av droger vid sällsynta sjukdomar" . Pacific Symposium on Biocomputing. Pacific Symposium on Biocomputing . 25 : 463-474. ISSN 2335-6936 . PMC 6937428 . PMID 31797619 .

- ^ a b Nickel, Maximilian; Tresp, Volker; Kriegel, Hans-Peter (2011-06-28). "En trevägsmodell för kollektivt lärande på multirelationella data" . Proceedings of the 28th International Conference on International Conference on Machine Learning . ICML'11. Bellevue, Washington, USA: Omnipress: 809–816. ISBN 978-1-4503-0619-5 .

- ^ Nickel, Maximilian; Tresp, Volker; Kriegel, Hans-Peter (2012-04-16). "Factorizing YAGO: skalbar maskininlärning för länkad data" . Proceedings från den 21:a internationella konferensen om World Wide Web . WWW '12. Lyon, Frankrike: Association for Computing Machinery: 271–280. doi : 10.1145/2187836.2187874 . ISBN 978-1-4503-1229-5 . S2CID 6348464 .

- ^ a b c d e f g h i j Alshahrani, Mona; Thafar, Maha A.; Essack, Magbubah (2021-02-18). "Tillämpning och utvärdering av kunskapsgrafinbäddningar i biomedicinsk data" . PeerJ datavetenskap . 7 : e341. doi : 10.7717/peerj-cs.341 . ISSN 2376-5992 . PMC 7959619 . PMID 33816992 .

- ^ a b c d e f g h i j k Wang, Meihong; Qiu, Linling; Wang, Xiaoli (2021-03-16). "En undersökning om inbäddningar av kunskapsdiagram för länkförutsägelse" . Symmetri . 13 (3): 485. Bibcode : 2021Symm...13..485W . doi : 10.3390/sym13030485 . ISSN 2073-8994 .

- ^ a b Yang, Bishan; Yih, Wen-tau; Han, Xiaodong; Gao, Jianfeng; Deng, Li (2015-08-29). "Inbädda enheter och relationer för lärande och slutledning i kunskapsbaser". arXiv : 1412.6575 [ cs.CL ].

- ^ a b c Trouillon, Théo; Welbl, Johannes; Riedel, Sebastian; Gaussier, Éric; Bouchard, Guillaume (2016-06-20). "Komplexa inbäddningar för enkel länkförutsägelse". arXiv : 1606.06357 [ cs.AI ].

- ^ a b c d e Liu, Hanxiao; Wu, Yuexin; Yang, Yiming (2017-07-06). "Analogisk slutledning för multi-relationella inbäddningar". arXiv : 1705.02426 [ cs.LG ].

- ^ a b c Kazemi, Seyed Mehran; Poole, David (2018-10-25). "Enkel inbäddning för länkförutsägelse i kunskapsdiagram". arXiv : 1802.04868 [ stat.ML ].

- ^ a b c Nickel, Maximilian; Rosasco, Lorenzo; Poggio, Tomaso (2015-12-07). "Holografiska inbäddningar av kunskapsdiagram". arXiv : 1510.04935 [ cs.AI ].

- ^ a b c d Balažević, Ivana; Allen, Carl; Hospedales, Timothy M. (2019). "TuckER: Tensorfaktorisering för färdigställande av kunskapsdiagram". Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP): 5184–5193. arXiv : 1901.09590 . doi : 10.18653/v1/D19-1522 . S2CID 59316623 .

- ^ a b Ali, Mehdi; Berrendorf, Max; Hoyt, Charles Tapley; Vermue, Laurent; Galkin, Mikhail; Sharifzadeh, Sahand; Fischer, Asja; Tresp, Volker; Lehmann, Jens (2021). "Bringing Light into the Dark: A Large-scale Evaluation of Knowledge Graph Embedding Models under a Unified Framework". IEEE-transaktioner på mönsteranalys och maskinintelligens . PP (12): 8825–8845. arXiv : 2006.13365 . doi : 10.1109/TPAMI.2021.3124805 . PMID 34735335 . S2CID 220041612 .

- ^ a b c Tran, Hung Nghiep; Takasu, Atsuhiro (2020). "Multi-Partition Inbäddning Interaktion med Block Term Format för färdigställande av kunskapsdiagram" . I Proceedings of the European Conference on Artificiell Intelligens (ECAI) : 833–840. doi : 10.3233/FAIA200173 . S2CID 220265751 .

- ^ a b c Tran, Hung-Nghiep; Takasu, Atsuhiro (2022-07-16). "MEIM: Multi-partition Embedding Interaction Beyond Block Term Format for Efficiency and Expressive Link Prediction" . I Proceedings of the International Joint Conference on Artificial Intelligence (IJCAI) . 3 : 2262-2269. doi : 10.24963/ijcai.2022/314 . ISBN 978-1-956792-00-3 . S2CID 250635995 .

- ^ a b Wang, Zhen (2014). "Inbäddning av kunskapsdiagram genom att översätta på hyperplan" . AAAI Publications, tjugoåttonde AAAI-konferensen om artificiell intelligens . 28 . doi : 10.1609/aaai.v28i1.8870 . S2CID 15027084 .

- ^ Lin, Yankai; Liu, Zhiyuan; Sun, Maosong; Liu, Yang; Zhu, Xuan (2015-01-25). "Lärande entitets- och relationsinbäddningar för färdigställande av kunskapsdiagram" . Proceedings från den tjugonionde AAAI-konferensen om artificiell intelligens . AAAI'15. Austin, Texas: AAAI Press: 2181–2187. ISBN 978-0-262-51129-2 .

- ^ a b c d e Ji, Guoliang; Han, Shizhu; Xu, Liheng; Liu, Kang; Zhao, juni (juli 2015). "Inbäddning av kunskapsdiagram via dynamisk kartläggningsmatris" . Handlingar från det 53:e årsmötet för Association for Computational Linguistics och den 7:e internationella gemensamma konferensen om naturlig språkbehandling (Volume 1: Long Papers) . Peking, Kina: Association for Computational Linguistics: 687–696. doi : 10.3115/v1/P15-1067 . S2CID 11202498 .

- ^ a b c d Xiao, Han; Huang, Minlie; Hao, Yu; Zhu, Xiaoyan (2015-09-27). "TransA: An Adaptive Approach for Knowledge Graph Embedding". arXiv : 1509.05490 [ cs.CL ].

- ^ a b c d e Nguyen, Dat Quoc; Sirts, Kairit; Qu, Lizhen; Johnson, Mark (juni 2016). "STransE: en ny inbäddningsmodell av enheter och relationer i kunskapsbaser" . Proceedings of the 2016 Conference of the North American Chapter of Association for Computational Linguistics: Human Language Technologies . San Diego, Kalifornien: Association for Computational Linguistics: 460–466. arXiv : 1606.08140 . doi : 10.18653/v1/N16-1054 . S2CID 9884935 .

- ^ a b c d e f g Zhang, Wen; Paudel, Bibek; Zhang, Wei; Bernstein, Abraham; Chen, Huajun (2019-01-30). "Interaktionsinbäddningar för förutsägelse och förklaring i kunskapsdiagram". Proceedings of the Twelfth ACM International Conference on Web Search and Data Mining : 96–104. arXiv : 1903.04750 . doi : 10.1145/3289600.3291014 . ISBN 9781450359405 . S2CID 59516071 .

- ^ a b c d Ebisu, Takuma; Ichise, Ryutaro (2017-11-15). "TorusE: Knowledge Graph Embedding on a Lie Group". arXiv : 1711.05435 [ cs.AI ].

- ^ a b c d e Sun, Zhiqing; Deng, Zhi-Hong; Nie, Jian-Yun; Tang, Jian (2019-02-26). "RotateE: Knowledge Graph Embedding by Relational Rotation in Complex Space". arXiv : 1902.10197 [ cs.LG ].

- ^ a b c d e f Dettmers, Tim; Minervini, Pasquale; Stenetorp, Pontus; Riedel, Sebastian (2018-07-04). "Convolutional 2D Knowledge Graph Inbäddningar". arXiv : 1707.01476 [ cs.LG ].

- ^ a b c d Jiang, Xiaotian; Wang, Quan; Wang, Bin (juni 2019). "Adaptiv konvolution för multi-relationellt lärande" . Proceedings of the 2019 Conference of the North American Chapter of Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers) . Minneapolis, Minnesota: Association for Computational Linguistics: 978–987. doi : 10.18653/v1/N19-1103 . S2CID 174800352 .

- ^ a b c d Nguyen, Dai Quoc; Nguyen, Tu Dinh; Nguyen, Dat Quoc; Phung, Dinh (2018). "En ny inbäddningsmodell för färdigställande av kunskapsbas baserad på konvolutionellt neuralt nätverk". Proceedings of the 2018 Conference of the North American Chapter of Association for Computational Linguistics: Human Language Technologies, Volym 2 (Short Papers) : 327–333. arXiv : 1712.02121 . doi : 10.18653/v1/N18-2053 . S2CID 3882054 .

- ^ a b c d e Nguyen, Dai Quoc; Vu, Thanh; Nguyen, Tu Dinh; Nguyen, Dat Quoc; Phung, Dinh (2019-03-06). "En kapselnätverksbaserad inbäddningsmodell för färdigställande av kunskapsdiagram och sökanpassning". arXiv : 1808.04122 [ cs.CL ].

- ^ a b c d e f Guo, Lingbing; Sun, Zequn; Hu, Wei (2019-05-13). "Lära sig att utnyttja långsiktiga relationella beroenden i kunskapsdiagram". arXiv : 1905.04914 [ cs.AI ].

- ^ a b Toutanova, Kristina; Chen, Danqi (juli 2015). "Observerade kontra latenta egenskaper för kunskapsbas och textinferens" . Proceedings of the 3rd Workshop on Continuous Vector Space Models and their compositionality . Peking, Kina: Association for Computational Linguistics: 57–66. doi : 10.18653/v1/W15-4007 . S2CID 5378837 .

- ^ a b Mahdisoltani, F.; Biega, J.; Suchanek, Fabian M. (2015). "YAGO3: En kunskapsbas från flerspråkiga Wikipedias" . CIDR . S2CID 6611164 .

- ^ Hu, Weihua; Fey, Matthias; Zitnik, Marinka; Dong, Yuxiao; Ren, Hongyu; Liu, Bowen; Catasta, Michele; Leskovec, Jure (2021-02-24). "Open Graph Benchmark: Dataset för maskininlärning på grafer". arXiv : 2005.00687 [ cs.LG ].

![{\displaystyle ={\frac {|\{q\in Q:q<k\}|}{|Q|}}\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cd0b504a6a4026009b8f5a0c39ad0ce4c88e5977)

![{\displaystyle MRR={\frac {1}{|Q|}}\sum _{q\in Q}{\frac {1}{q}}\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/adf9b1771d7ac872c4d3082c26b15e8eb9f3e512)

![{\displaystyle {\ce {[h;{\mathcal {r}}]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4754a8e29d7b4ccd4cf13de3052aef0922840171)

![{\displaystyle {\ce {[h;{\mathcal {r}};t]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fb32c4cfc9fa12eb799777f7234990ce33b3d544)