Katastrofal störning

| Del av en serie om |

|

maskininlärning och datautvinning |

|---|

|

Katastrofal störning , även känd som katastrofal glömning , är tendensen hos ett artificiellt neuralt nätverk att plötsligt och drastiskt glömma tidigare inlärd information när man lär sig ny information. Neurala nätverk är en viktig del av nätverksansatsen och det konnektionistiska förhållningssättet till kognitionsvetenskap . Med dessa nätverk kan mänskliga förmågor som minne och inlärning modelleras med hjälp av datorsimuleringar.

Katastrofal störning är en viktig fråga att tänka på när man skapar konnektionistiska minnesmodeller. Den uppmärksammades ursprungligen av forskarsamhället genom forskning från McCloskey och Cohen (1989) och Ratcliff (1990). Det är en radikal manifestation av "känslighet-stabilitet"-dilemmat eller "stabilitet-plasticitet"-dilemmat. Specifikt hänvisar dessa problem till utmaningen att skapa ett artificiellt neuralt nätverk som är känsligt för, men inte störs av, ny information.

Uppslagstabeller och anslutningsnätverk ligger på motsatta sidor av stabilitetsplasticitetsspektrumet. Den förra förblir helt stabil i närvaro av ny information men saknar förmågan att generalisera , dvs härleda allmänna principer, från nya input. Å andra sidan kan anslutningsnätverk som standardnätverket för backpropagation generalisera till osynliga indata, men de är mycket känsliga för ny information. Backpropagation-modeller kan analogiseras med mänskligt minne i den mån de speglar människans förmåga att generalisera [ enligt vem? ] [ citat behövs ] men dessa nätverk uppvisar ofta mindre stabilitet än mänskligt minne. Särskilt är dessa backpropagation-nätverk mottagliga för katastrofala störningar. Detta är ett problem när man modellerar mänskligt minne, för till skillnad från dessa nätverk visar människor vanligtvis inte katastrofala glömska.

Historien om katastrofala störningar

Termen katastrofal interferens myntades ursprungligen av McCloskey och Cohen (1989) men uppmärksammades också av forskarvärlden genom forskning från Ratcliff (1990).

The Sequential Learning Problem : McCloskey och Cohen (1989)

McCloskey och Cohen (1989) noterade problemet med katastrofal interferens under två olika experiment med modellering av neurala nätverk med bakåtpropagation.

- Experiment 1: Lär dig fakta om ettor och tvåor

I sitt första experiment tränade de ett neuralt standardnätverk för bakåtpropagation på en enda träningsuppsättning bestående av 17 ensiffriga problem (dvs 1 + 1 till 9 + 1 och 1 + 2 till 1 + 9) tills nätverket kunde representera och svara ordentligt på dem alla. Felet mellan den faktiska produktionen och den önskade produktionen minskade stadigt över utbildningssessioner, vilket återspeglade att nätverket lärde sig att representera målresultaten bättre under försök. Därefter tränade de nätverket på en enda träningsuppsättning bestående av 17 ensiffriga tvåor (dvs 2 + 1 till 2 + 9 och 1 + 2 till 9 + 2) tills nätverket kunde representera, svara korrekt på alla dem. De noterade att deras procedur liknade hur ett barn skulle lära sig sina tilläggsfakta. Efter varje inlärningsförsök om tvåns fakta, testades nätverket för sina kunskaper om både ettor och tvås additionsfakta. Precis som dessa fakta, lärde sig de tvås fakta lätt av nätverket. Emellertid noterade McCloskey och Cohen att nätverket inte längre kunde svara ordentligt på dessa additionsproblem även efter en inlärningsförsök av tvåns additionsproblem. Utmatningsmönstret som producerades som svar på dessa fakta liknade ofta ett utmatningsmönster för ett felaktigt tal närmare än utmatningsmönstret för ett korrekt tal. Detta anses vara en drastisk mängd fel. Dessutom visade problemen 2+1 och 2+1, som ingick i båda träningsuppsättningarna, till och med dramatiska störningar under de första inlärningsförsöken av de tvås fakta.

- Experiment 2: Replikering av Barnes och Underwood (1959) studie

I sin andra kopplingsmodell försökte McCloskey och Cohen replikera studien om retroaktiv interferens hos människor av Barnes och Underwood (1959). De tränade modellen på AB- och AC-listor och använde ett kontextmönster i ingångsvektorn (indatamönster), för att skilja mellan listorna. Nätverket tränades specifikt att svara med rätt B-svar när A-stimulans- och AB-kontextmönstret visades och att svara med korrekt C-svar när A-stimulus och AC-kontextmönstret visades. När modellen tränades samtidigt på AB- och AC-objekten lärde nätverket sig lätt alla associationer korrekt. Vid sekventiell träning tränades AB-listan först, följt av AC-listan. Efter varje presentation av AC-listan mättes prestanda för både AB- och AC-listorna. De fann att mängden träning på AC-listan i Barnes och Underwood-studien som leder till 50 % korrekta svar, leder till nästan 0 % korrekta svar från backpropagation-nätverket. Dessutom fann de att nätverket tenderade att visa svar som såg ut som C-svarsmönstret när nätverket uppmanades att ge B-svarsmönstret. Detta tydde på att AC-listan uppenbarligen hade skrivit över AB-listan. Detta kan liknas vid att lära sig ordet hund, följt av att lära sig ordet pall och sedan upptäcka att man inte kan känna igen ordet katt bra utan istället tänker på ordet pall när det presenteras med ordet hund.

McCloskey och Cohen försökte minska störningar genom ett antal manipulationer inklusive att ändra antalet dolda enheter, ändra värdet på parametern inlärningshastighet, överträning på AB-listan, frysa vissa anslutningsvikter, ändra målvärdena 0 och 1 istället 0,1 och 0,9 . Ingen av dessa manipulationer reducerade dock på ett tillfredsställande sätt den katastrofala störningen som uppvisades av nätverken.

Sammantaget drog McCloskey och Cohen (1989) slutsatsen att:

- åtminstone vissa störningar kommer att inträffa när ny inlärning ändrar vikterna som representerar

- ju större mängd nytt lärande, desto större störning i gammal kunskap

- interferens var katastrofal i backpropagation-nätverken när inlärningen var sekventiell men inte samtidig

Restriktioner införda av att lära sig och glömma funktioner : Ratcliff (1990)

Ratcliff (1990) använde flera uppsättningar av backpropagation-modeller som tillämpades på standardigenkänningsminnesprocedurer, där objekten sekventiellt lärdes in. Efter att ha inspekterat modellerna för erkännandeprestanda fann han två stora problem:

- Välinärd information glömdes katastrofalt bort då ny information lärdes in i både små och stora nätverk för återförökning.

Även en inlärningsförsök med ny information resulterade i en betydande förlust av den gamla informationen, parallellt med upptäckten av McCloskey och Cohen (1989). Ratcliff fann också att de resulterande utgångarna ofta var en blandning av den tidigare ingången och den nya ingången. I större nätverk var objekt inlärda i grupper (t.ex. AB sedan CD) mer motståndskraftiga mot att glömma än objekt som lärdes var för sig (t.ex. A sedan B sedan C...). Men glömskan för saker som lärts i grupper var fortfarande stor. Att lägga till nya dolda enheter i nätverket minskade inte störningar.

- Diskrimineringen mellan de studerade objekten och tidigare osynliga objekt minskade när nätverket lärde sig mer.

Detta fynd strider mot studier om mänskligt minne, som indikerade att diskriminering ökar med inlärning. Ratcliff försökte lindra detta problem genom att lägga till "svarsnoder" som selektivt skulle svara på gamla och nya ingångar. Denna metod fungerade dock inte eftersom dessa svarsnoder skulle bli aktiva för alla ingångar. En modell som använde ett kontextmönster lyckades inte heller öka diskrimineringen mellan nya och gamla föremål.

Lösningsförslag

Den främsta orsaken till katastrofal interferens verkar vara överlappning i representationerna vid det dolda lagret av distribuerade neurala nätverk. I en distribuerad representation tenderar varje ingång att skapa förändringar i vikterna för många av noderna. Katastrofal glömska uppstår eftersom när många av vikterna där "kunskap lagras" ändras, är det osannolikt att förkunskaper hålls intakta. Under sekventiell inlärning blandas ingångarna, där de nya ingångarna läggs ovanpå de gamla. Ett annat sätt att konceptualisera detta är genom att visualisera lärande som en rörelse genom ett viktutrymme. Detta viktutrymme kan liknas vid en rumslig representation av alla möjliga kombinationer av vikter som nätverket kan ha. När ett nätverk först lär sig att representera en uppsättning mönster, hittar det en punkt i viktutrymmet som gör att det kan känna igen alla dessa mönster. Men när nätverket sedan lär sig en ny uppsättning mönster, kommer det att flytta till en plats i viktutrymmet där det enda problemet är att känna igen de nya mönstren. För att känna igen båda uppsättningarna av mönster måste nätverket hitta en plats i viktutrymmet som är lämplig för att känna igen både de nya och de gamla mönstren.

Nedan finns ett antal tekniker som har empiriskt stöd för att framgångsrikt minska katastrofal interferens i neurala nätverk för bakåtpropagation:

Ortogonalitet

Många av de tidiga teknikerna för att reducera representativ överlappning involverade att göra antingen inmatningsvektorerna eller de dolda enhetsaktiveringsmönstren ortogonala mot varandra. Lewandowsky och Li (1995) noterade att interferensen mellan sekventiellt inlärda mönster minimeras om ingångsvektorerna är ortogonala mot varandra. Indatavektorer sägs vara ortogonala mot varandra om den parvisa produkten av deras element över de två vektorerna summeras till noll. Till exempel sägs mönstren [0,0,1,0] och [0,1,0,0] vara ortogonala eftersom (0×0 + 0×1 + 1×0 + 0×0) = 0. En av teknikerna som kan skapa ortogonala representationer vid de dolda lagren involverar bipolär funktionskodning (dvs kodning med -1 och 1 snarare än 0 och 1). Ortogonala mönster tenderar att producera mindre interferens med varandra. Alla inlärningsproblem kan dock inte representeras med dessa typer av vektorer och vissa studier rapporterar att graden av interferens fortfarande är problematisk med ortogonala vektorer.

Nodskärpningsteknik

Enligt French (1991) uppstår katastrofal interferens i feedforward- backpropagation-nätverk på grund av interaktionen av nodaktiveringar, eller aktiveringsöverlappning, som sker i distribuerade representationer vid det dolda lagret. Neurala nätverk som använder mycket lokaliserade representationer visar inte katastrofala störningar på grund av bristen på överlappning vid det dolda lagret. French föreslog därför att en minskning av värdet av aktiveringsöverlappning vid det dolda lagret skulle minska katastrofala störningar i distribuerade nätverk. Specifikt föreslog han att detta skulle kunna göras genom att ändra de distribuerade representationerna vid det dolda lagret till "halvfördelade" representationer. En "halvfördelad" representation har färre dolda noder som är aktiva, och/eller ett lägre aktiveringsvärde för dessa noder, för varje representation, vilket gör att representationerna av de olika ingångarna överlappar mindre i det dolda lagret. French rekommenderade att detta kunde göras genom "aktiveringsskärpning", en teknik som något ökar aktiveringen av ett visst antal av de mest aktiva noderna i det dolda lagret, något minskar aktiveringen av alla andra enheter och sedan ändrar ingången till -dolda lagervikter för att återspegla dessa aktiveringsändringar (liknande felåterförökning).

Nyhetsregel

Kortge (1990) föreslog en inlärningsregel för att träna neurala nätverk, kallad "nyhetsregeln", för att hjälpa till att lindra katastrofala störningar. Som namnet antyder hjälper denna regel det neurala nätverket att bara lära sig komponenterna i en ny ingång som skiljer sig från en gammal ingång. Följaktligen ändrar nyhetsregeln endast de vikter som inte tidigare var dedikerade till att lagra information, vilket minskar överlappningen i representationer vid de dolda enheterna. För att tillämpa nyhetsregeln, under inlärning ersätts inmatningsmönstret med en nyhetsvektor som representerar de komponenter som skiljer sig åt. När nyhetsregeln används i ett standardnätverk för återförökning sker ingen eller minskad glömning av gamla artiklar när nya artiklar presenteras sekventiellt. En begränsning är dock att denna regel endast kan användas med autokodare eller autoassociativa nätverk, där målsvaret för utlagret är identiskt med inmatningsmönstret.

Förträningsnätverk

McRae och Hetherington (1993) hävdade att människor, till skillnad från de flesta neurala nätverk, inte tar på sig nya inlärningsuppgifter med en slumpmässig uppsättning vikter. Snarare tenderar människor att ta med sig en mängd förkunskaper till en uppgift och detta hjälper till att undvika problemet med störningar. De visade att när ett nätverk är förtränat på ett slumpmässigt urval av data innan man påbörjar en sekventiell inlärningsuppgift att dessa förkunskaper naturligtvis kommer att begränsa hur den nya informationen kan införlivas. Detta skulle inträffa eftersom ett slumpmässigt urval av data från en domän som har en hög grad av intern struktur, som det engelska språket, utbildning skulle fånga de regelbundenheter eller återkommande mönster som finns inom den domänen. Eftersom domänen är baserad på regelbundenhet, tenderar ett nyinlärt objekt att likna den tidigare inlärda informationen, vilket gör att nätverket kan införliva ny data med liten störning av befintliga data. Specifikt bör en indatavektor som följer samma mönster av regelbundenheter som tidigare tränade data inte orsaka ett drastiskt annorlunda aktiveringsmönster vid det dolda lagret eller drastiskt ändra vikter.

Repetition

Robins (1995) beskrev att katastrofal glömska kan förhindras genom repetitionsmekanismer. Detta innebär att när ny information läggs till, tränas det neurala nätverket om på en del av den tidigare inlärda informationen. I allmänhet kan dock tidigare inlärd information inte vara tillgänglig för sådan omskolning. En lösning för detta är "pseudo-repetition", där nätverket inte tränas om på faktiska tidigare data utan på representationer av dem. Flera metoder är baserade på denna allmänna mekanism.

Pseudo-återkommande nätverk

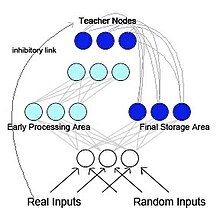

French (1997) föreslog ett pseudo-återkommande återförökningsnätverk (se figur 2). I denna modell är nätverket uppdelat i två funktionellt distinkta men interagerande delnätverk. Denna modell är biologiskt inspirerad och bygger på forskning från McClelland et al. (1995) McClelland och kollegor föreslog att hippocampus och neocortex fungerar som separerbara men komplementära minnessystem, med hippocampus för korttidsminne och neocortex för långtidsminne . Information som initialt lagrats i hippocampus kan "överföras" till neocortex med hjälp av reaktivering eller replay. I det pseudo-återkommande nätverket fungerar ett av undernätverken som ett tidigt bearbetningsområde, likt hippocampus, och fungerar för att lära sig nya inmatningsmönster. Det andra undernätverket fungerar som ett slutlagringsområde, besläktat med neocortex. Men till skillnad från i McClelland et al. (1995) modell skickar det slutliga lagringsområdet internt genererad representation tillbaka till det tidiga bearbetningsområdet. Detta skapar ett återkommande nätverk. French föreslog att denna sammanflätning av gamla representationer med nya representationer är det enda sättet att minska radikal glömska. Eftersom hjärnan sannolikt inte skulle ha tillgång till de ursprungliga inmatningsmönstren, skulle mönstren som skulle matas tillbaka till neocortex vara internt genererade representationer som kallas pseudo-mönster . Dessa pseudomönster är approximationer av tidigare indata och de kan interfolieras med inlärning av nya indata.

Självuppfriskande minne

Inspirerad av och oberoende av Ans och Rousset (1997) föreslog också en artificiell neural arkitektur med två nätverk med självuppfriskande minne som övervinner katastrofala störningar när sekventiella inlärningsuppgifter utförs i distribuerade nätverk som tränas av backpropagation. Principen är att lära sig nya externa mönster samtidigt med internt genererade pseudomönster, eller "pseudo-minnen", som återspeglar den tidigare inlärda informationen. Det som huvudsakligen skiljer denna modell från de som använder klassisk pseudorepetition i feedforward flerskiktsnätverk är en efterklangsprocess [ ytterligare förklaring behövs] som används för att generera pseudopatern . Efter ett antal återinjektioner av aktivitet från ett enda slumpmässigt frö, tenderar denna process att gå upp till olinjära nätverksatttraktorer som är mer lämpade för att på ett optimalt sätt fånga den djupa strukturen av kunskap fördelad inom anslutningsvikter än den enstaka framkopplingen av aktivitet som används i pseudo -repetition. Proceduren för självuppfriskande minne visade sig vara mycket effektiv i överföringsprocesser och i seriell inlärning av temporala mönstersekvenser utan katastrofal glömning.

Generativ repris

Under de senaste åren har pseudo-repetitioner återvunnit i popularitet tack vare framstegen i kapaciteten hos djupa generativa modeller . När sådana djupa generativa modeller används för att generera "pseudodata" som ska repeteras, kallas denna metod vanligtvis generativ repris. Sådan generativ repris kan effektivt förhindra katastrofal glömning, speciellt när reprisen utförs i de dolda lagren snarare än på ingångsnivån.

Latent lärande

Latent Learning är en teknik som används av Gutstein & Stump (2015) för att mildra katastrofala störningar genom att dra fördel av överföringsinlärning . Detta tillvägagångssätt försöker hitta optimala kodningar för alla nya klasser som ska läras in, så att de är minst benägna att katastrofalt störa befintliga svar. Med tanke på ett nätverk som har lärt sig att skilja mellan en uppsättning klasser med hjälp av Error Correcting Output Codes (ECOC) (i motsats till 1 hot codes ), väljs optimala kodningar för nya klasser genom att observera nätverkets genomsnittliga svar på dem. Eftersom dessa genomsnittliga svar uppstod när man lärde sig den ursprungliga uppsättningen av klasser utan någon exponering för de nya klasserna, hänvisas de till som "Latently Learned Encodings". Denna terminologi lånar från begreppet latent lärande, som introducerades av Tolman 1930. I själva verket använder denna teknik överföringsinlärning för att undvika katastrofal interferens, genom att göra ett nätverks svar på nya klasser så konsekventa som möjligt med befintliga svar på klasser som redan lärts in.

Elastisk viktkonsolidering

Kirkpatrick et al. (2017) föreslog elastisk viktkonsolidering (EWC), en metod för att sekventiellt träna ett enda artificiellt neuralt nätverk på flera uppgifter. Denna teknik förutsätter att vissa vikter av det tränade neurala nätverket är viktigare för tidigare inlärda uppgifter än andra. Under träning av det neurala nätverket på en ny uppgift, görs förändringar i nätverkets vikter mindre sannolika ju större deras betydelse är. För att uppskatta betydelsen av nätverksvikterna använder EWC probabilistiska mekanismer, i synnerhet Fisher informationsmatrisen, men detta kan göras på andra sätt också.