Informationsflaskhalsmetod

Informationsflaskhalsmetoden är en teknik inom informationsteori introducerad av Naftali Tishby , Fernando C. Pereira och William Bialek . Den är utformad för att hitta den bästa avvägningen mellan noggrannhet och komplexitet ( komprimering ) när man summerar (t.ex. klustring ) en slumpvariabel X , givet en gemensam sannolikhetsfördelning p(X,Y) mellan X och en observerad relevant variabel Y - och självbeskriven som att tillhandahålla "ett förvånansvärt rikt ramverk för att diskutera en mängd olika problem inom signalbehandling och inlärning" .

Tillämpningar inkluderar distributionskluster och dimensionsreduktion , och på senare tid har det föreslagits som en teoretisk grund för djupt lärande . Den generaliserade den klassiska uppfattningen om minimal tillräcklig statistik från parametrisk statistik till godtyckliga fördelningar, inte nödvändigtvis av exponentiell form. Den gör det genom att slappna av villkoret för att fånga en del av den ömsesidiga informationen med den relevanta variabeln Y .

Informationsflaskhalsen kan också ses som ett hastighetsförvrängningsproblem , med en distorsionsfunktion som mäter hur väl Y förutsägs från en komprimerad representation T jämfört med dess direkta förutsägelse från X . Denna tolkning tillhandahåller en allmän iterativ algoritm för att lösa informationsflaskhalsavvägningen och beräkna informationskurvan från fördelningen p(X,Y) .

Låt den komprimerade representationen ges av slumpvariabeln . Algoritmen minimerar följande funktionalitet med avseende på villkorlig fördelning :

där och är den ömsesidiga informationen för och , och av respektive , och är en Lagrange-multiplikator .

Minimal tillräcklig statistik

Självständiga ekvationer

Lärande teori

Fasövergångar

Informationsteori om djupinlärning

Theory of Information Bottleneck används nyligen för att studera Deep Neural Networks (DNN). Betrakta respektive som ingångs- och utgångsskikt för en DNN, och låt vara vilket dolt lager i nätverket som helst. Shwartz-Ziv och föreslog informationsflaskhalsen som uttrycker avvägningen mellan de ömsesidiga informationsmåtten och . I detta fall kvantifierar respektive mängden information som det dolda lagret innehåller om input och output. De förmodade att utbildningsprocessen för en DNN består av två separata faser; 1) en initial passningsfas i vilken ökar, och 2) en efterföljande kompressionsfas i vilken minskar. Saxe et al. i motsatte sig påståendet från Shwartz-Ziv och Tishby, och angav att detta komprimeringsfenomen i DNN inte är heltäckande, och det beror på den särskilda aktiveringsfunktionen. I synnerhet hävdade de att komprimeringen inte sker med ReLu-aktiveringsfunktioner. Shwartz-Ziv och Tishby bestred dessa påståenden och hävdade att Saxe et al inte hade observerat komprimering på grund av svaga uppskattningar av den ömsesidiga informationen. Nyligen har Noshad et al. använde en hastighetsoptimal estimator av ömsesidig information för att utforska denna kontrovers, och observerade att den optimala hash-baserade estimatorn avslöjar komprimeringsfenomenet i ett bredare utbud av nätverk med ReLu- och maxpooling-aktiveringar. Å andra sidan har nyligen Goldfeld et al. har hävdat att den observerade kompressionen är ett resultat av geometriska, och inte av informationsteoretiska fenomen, en syn som har delats även i.

Varierande flaskhals

Gaussisk flaskhals

Den Gaussiska flaskhalsen, nämligen att tillämpa informationsflaskhalsmetoden på Gaussiska variabler, leder till lösningar relaterade till kanonisk korrelationsanalys . Antag att tillsammans är multivariata nollmedelnormalvektorer med kovarianser och är en komprimerad version av som måste bibehålla ett givet värde för ömsesidig information med . Det kan visas att den optimala är en normalvektor som består av linjära kombinationer av elementen i där matris har ortogonala rader.

Projektionsmatrisen innehåller faktiskt rader valda från de viktade vänstra egenvektorerna för singularvärdesuppdelningen av matrisen (vanligen asymmetrisk)

Definiera singularvärdesuppdelningen

och de kritiska värdena

då ges antalet för aktiva egenvektorer i projektionen, eller approximationsordningen, av

Och vi får äntligen

I vilken vikterna ges av

där

Att tillämpa den Gaussiska informationsflaskhalsen på tidsserier (processer), ger lösningar relaterade till optimal prediktiv kodning. Denna procedur är formellt likvärdig med linjär Slow Feature Analysis.

Optimala tidsstrukturer i linjära dynamiska system kan avslöjas i den så kallade tidigare-framtidsinformationsflaskhalsen, en tillämpning av flaskhalsmetoden på icke-Gaussisk samplade data. Konceptet, som behandlats av Creutzig, Tishby et al., är inte utan komplikationer eftersom två oberoende faser utgörs av övningen: för det första uppskattning av de okända modersannolikhetstätheterna från vilka datasamplen är dragna och för det andra användningen av dessa tätheter inom den informationsteoretiska ramen för flaskhalsen.

Densitetsuppskattning

Eftersom flaskhalsmetoden är inramad i probabilistiska snarare än statistiska termer, måste den underliggande sannolikhetstätheten vid provpunkterna uppskattas. Detta är ett välkänt problem med flera lösningar som beskrivs av Silverman . I den föreliggande metoden hittas sannolikheter för gemensamma prov genom användning av en Markov-övergångsmatrismetod och detta har viss matematisk synergi med själva flaskhalsmetoden.

Det godtyckligt ökande avståndsmåttet mellan alla sampelpar och avståndsmatrisen är . Övergångssannolikheter mellan sampelparen för vissa måste beräknas. Behandling av sampel som tillstånd och en normaliserad version av som en Markov-tillståndsövergångssannolikhetsmatris, vektorn av sannolikheter för 'tillstånden' efter steg, betingad av den initiala tillstånd , är . Jämviktssannolikhetsvektorn given, på vanligt sätt, av den dominanta egenvektorn för matrisen som är oberoende av den initialiserande vektorn . Denna Markov-övergångsmetod fastställer en sannolikhet vid provpunkterna som påstås vara proportionell mot sannolikheternas densiteter där.

Andra tolkningar av användningen av egenvärdena för avståndsmatris diskuteras i Silverman's Density Estimation for Statistics and Data Analysis .

Kluster

I följande mjuka klustringsexempel innehåller referensvektorn exempelkategorier och den gemensamma sannolikheten antas vara känd. Ett mjukt kluster definieras av dess sannolikhetsfördelning över datasamplen . Tishby et al. presenterade följande iterativa uppsättning ekvationer för att bestämma klustren som i slutändan är en generalisering av Blahut-Arimoto-algoritmen, utvecklad inom hastighetsförvrängningsteorin . Tillämpningen av denna typ av algoritm i neurala nätverk verkar ha sitt ursprung i entropiargument som uppstår vid tillämpningen av Gibbs-distributioner vid deterministisk glödgning.

Funktionen för varje rad i iterationen expanderar som

Rad 1: Detta är en matrisvärderad uppsättning villkorliga sannolikheter

Kullback –Leibler-divergensen mellan vektorerna som genereras av exempeldatan och de som genereras av dess reducerade information proxy används för att bedöma den komprimerade vektorns trohet med avseende på referensdata (eller kategoriska) data i enlighet med den grundläggande flaskhalsekvationen. är Kullback–Leibler-divergensen mellan distributionerna

och är en skalär normalisering. Viktningen av avståndets negativa exponent innebär att tidigare klustersannolikheter nedviktas i rad 1 när Kullback–Leibler-divergensen är stor, så framgångsrika kluster växer i sannolikhet medan misslyckade sönderfaller.

Rad 2: Andra matrisvärderade uppsättningen villkorade sannolikheter. Per definition

där Bayes-identiteterna används.

Rad 3: denna linje hittar marginalfördelningen av klustren

Detta är ett standardresultat.

Ytterligare indata till algoritmen är marginalsampelfördelningen som redan har bestämts av den dominanta egenvektorn för och den matrisvärderade Kullback–Leibler-divergensen fungera

härledd från urvalsavstånden och övergångssannolikheter.

Matrisen kan initieras slumpmässigt eller med en rimlig gissning, medan matrisen behöver inga tidigare värden. Även om algoritmen konvergerar kan det finnas flera minima som skulle behöva lösas.

Definiera beslutskonturer

För att kategorisera ett nytt prov utanför träningsuppsättningen , hittar det föregående distansmåttet övergångssannolikheterna mellan och alla sampel i , med en normalisering. För det andra tillämpa de två sista raderna i 3-radsalgoritmen för att få kluster- och villkorskategorisannolikheter.

Till sist

Parametern måste hållas under noggrann övervakning eftersom, när den ökas från noll, ökar antalet funktioner, i kategorins sannolikhetsutrymme, i fokus vid vissa kritiska trösklar.

Ett exempel

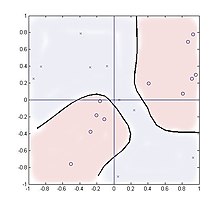

Följande fall undersöker klustring i en multiplikator med fyra kvadranter med slumpmässiga ingångar och två kategorier av utdata, , genererad av . Denna funktion har två rumsligt separerade kluster för varje kategori och visar på så sätt att metoden kan hantera sådana distributioner.

20 prover tas, jämnt fördelade på kvadraten . Antalet kluster som används utöver antalet kategorier, två i detta fall, har liten effekt på prestandan och resultaten visas för två kluster med parametrarna .

Avståndsfunktionen x medan den villkorliga fördelningen är en 2 × 20 matris

och noll någon annanstans.

Summeringen i rad 2 innehåller endast två värden som representerar träningsvärdena +1 eller −1, men fungerar ändå bra. Figuren visar placeringen av de tjugo proverna där '0' representerar Y = 1 och 'x' representerar Y = −1. Konturen vid enhetssannolikhetsförhållandet visas,

som ett nytt exempel skannas Teoretiskt sett bör konturen vara i linje med koordinaterna och men för så små provnummer har de istället följt sampelpunkternas falska klustringar.

Analogier av neurala nätverk/suddig logik

Denna algoritm är något analog med ett neuralt nätverk med ett enda dolt lager. De interna noderna representeras av klustren och det första och andra lagret av nätverksvikter är de villkorliga sannolikheterna respektive . Men till skillnad från ett standardneuralt nätverk, bygger algoritmen helt på sannolikheter som indata snarare än själva provvärdena, medan interna och utgående värden alla är villkorade sannolikhetstäthetsfördelningar. Icke-linjära funktioner är inkapslade i avståndsmetriska (eller influensfunktioner/radialbasfunktioner ) och övergångssannolikheter istället för sigmoidfunktioner.

Blahut-Arimoto treradiga algoritm konvergerar snabbt, ofta i tiotals iterationer, och genom att variera λ och och kardinalitet av klustren, kan olika nivåer av fokus på funktioner uppnås.

Den statistiska mjuka klustringsdefinitionen verbala fuzzy medlemskapskonceptet för fuzzy logic .

Tillägg

En intressant förlängning är fallet med informationsflaskhals med sidoinformation. Här maximeras information om en målvariabel och minimeras om en annan, och lär sig en representation som är informativ om utvalda aspekter av data. Formellt

Bibliografi

- Weiss, Y. (1999), "Segmentation using eigenvectors: a unifying view", Proceedings IEEE International Conference on Computer Vision (PDF) , s. 975–982

- P. Harremoës och N. Tishby "The Information Bottleneck Revisited or How to Choose a Good Distortion Measure". I handlingar från International Symposium on Information Theory (ISIT) 2007

![{\displaystyle A=[w_{1}U_{1},\dots ,w_{M}U_{M}]^{T}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2452fbcc21043b263e6427f67922d2f3794ed0da)

![{\displaystyle {\begin{cases}p(c|x)=Kp(c)\exp {\Big (}-\beta \,D^{KL}{\Big [}p(y|x)\,||\,p(y|c){\Big ]}{\Big )}\\p(y|c)=\textstyle \sum _{x}p(y|x)p(c|x)p(x){\big /}p(c)\\p(c)=\textstyle \sum _{x}p(c|x)p(x)\\\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f9b29faec038fbb2da40e4ba191be82a2fd73760)

![{\displaystyle A_{i,j}=p(c_{i}|x_{j})=Kp(c_{i})\exp {\Big (}-\beta \,D^{KL}{\Big [}p(y|x_{j})\,||\,p(y|c_{i}){\Big ]}{\Big )}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6f287e6823ebfa39f521fe993a875691ff778fdc)

![{\displaystyle D_{i,j}^{KL}=D^{KL}{\Big [}p(y|x_{j})\,||\,p(y|c_{i}){\Big ]}{\Big )}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3589cf4b3fe5eeb605388c57058dfb558db84576)

![{\displaystyle [-1,1]^{2}\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a4376d6f93ed4561418bc9e39a4992b97da77bc0)