METEOR

METEOR ( mått för utvärdering av översättning med explicit beställning ) är ett mått för utvärdering av maskinöversättningsutdata . Måttet är baserat på det harmoniska medelvärdet av unigramprecision och recall , med recall viktad högre än precision. Den har också flera funktioner som inte finns i andra mätvärden, till exempel härkomst- och synonymmatchning , tillsammans med standardexakt ordmatchning. Måttet utformades för att åtgärda några av problemen som finns i det mer populära BLEU- måttet, och även producera bra korrelation med mänskligt omdöme på menings- eller segmentnivå. Detta skiljer sig från BLEU-måttet genom att BLEU söker korrelation på korpusnivå.

Resultat har presenterats som ger en korrelation på upp till 0,964 med mänskligt omdöme på korpusnivå, jämfört med BLEU :s prestation på 0,817 på samma datamängd. På straffnivån var den maximala korrelationen med mänskligt omdöme 0,403.

Algoritm

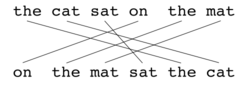

Precis som med BLEU , är den grundläggande utvärderingsenheten meningen, algoritmen skapar först en anpassning (se illustrationer) mellan två meningar , kandidatöversättningssträngen och referensöversättningssträngen. Linjen är en uppsättning mappningar mellan unigram . En mappning kan ses som en linje mellan ett unigram i en sträng och ett unigram i en annan sträng. Begränsningarna är följande; varje unigram i kandidatöversättningen måste mappas till noll eller ett unigram i referensen. Mappningar väljs för att skapa en justering enligt definitionen ovan. Om det finns två linjer med samma antal mappningar, väljs anpassningen med minst kors , det vill säga med färre skärningar av två mappningar. Från de två visade uppriktningarna skulle inriktning (a) väljas vid denna punkt. Stadier körs i följd och varje steg lägger bara till de unigram som inte har matchats i tidigare steg till justeringen. När den slutliga justeringen har beräknats, beräknas poängen enligt följande: Unigrams precision P beräknas som:

| Modul | Kandidat | Referens | Match |

|---|---|---|---|

| Exakt | Bra | Bra | Ja |

| Stemmer | Varor | Bra | Ja |

| Synonymi | väl | Bra | Ja |

Där m är antalet unigram i kandidatöversättningen som också finns i referensöversättningen, och är antalet unigram i kandidatöversättningen. Unigram recall R beräknas som:

Där m är som ovan, och är antalet unigram i referensöversättningen. Precision och återkallelse kombineras med det harmoniska medelvärdet på följande sätt, med återkallning vägd 9 gånger mer än precision:

De mått som hittills har införts tar endast hänsyn till överensstämmelse med avseende på enstaka ord men inte med avseende på större segment som förekommer i både referens- och kandidatsatsen. För att ta hänsyn till dessa används längre n -gram-matchningar för att beräkna ett straff p för inriktningen. Ju fler mappningar det finns som inte ligger intill i referensen och kandidatsatsen, desto högre blir straffet.

För att beräkna detta straff, grupperas unigram i minsta möjliga bitar , där en bit definieras som en uppsättning unigram som ligger intill i hypotesen och i referensen. Ju längre intilliggande mappningar mellan kandidaten och referensen, desto färre bitar finns det. En översättning som är identisk med referensen ger bara en bit. Straffet p beräknas enligt följande,

Där c är antalet bitar och är antalet unigram som har kartlagts. Slutpoängen för ett segment beräknas som M nedan. Straffet har effekten att minska med upp till 50 % om det inte finns några bigram eller längre matchningar.

För att beräkna en poäng över en hel korpus , eller samling av segment , tas de aggregerade värdena för P , R och p och kombineras sedan med samma formel. Algoritmen fungerar också för att jämföra en kandidatöversättning mot mer än en referensöversättning. I det här fallet jämför algoritmen kandidaten med var och en av referenserna och väljer den högsta poängen.

Exempel

| Referens | de | katt | satt | på | de | matta |

|---|---|---|---|---|---|---|

| Hypotes | på | de | matta | satt | de | katt |

| Göra | ||||||

| Fmean | ||||||

| Straff | ||||||

| Splittring | ||||||

| Referens | de | katt | satt | på | de | matta |

|---|---|---|---|---|---|---|

| Hypotes | de | katt | satt | på | de | matta |

| Göra | ||||||

| Fmean | ||||||

| Straff | ||||||

| Splittring | ||||||

| Referens | de | katt | satt | på | de | matta | |

|---|---|---|---|---|---|---|---|

| Hypotes | de | katt | var | satt | på | de | matta |

| Göra | |||||||

| Fmean | |||||||

| Straff | |||||||

| Splittring | |||||||

Se även

- BLEU

- F-mått

- NIST (mått)

- ROUGE (metrisk)

- Word Error Rate (WER)

- LEPOR

- Substantiv-fras Chunking

Anteckningar

- ^ Banerjee, S. och Lavie, A. (2005)

- Banerjee, S. och Lavie, A. (2005) "METEOR: An Automatic Metric for MT Evaluation with Improved Correlation with Human Judgments" i Proceedings of Workshop on Intrinsic and Extrinsic Evaluation Measures for MT och/eller sammanfattning vid det 43:e årsmötet i Association of Computational Linguistics (ACL-2005), Ann Arbor, Michigan, juni 2005

- Lavie, A., Sagae, K. och Jayaraman, S. (2004) "The Significance of Recall in Automatic Metrics for MT Evaluation" i Proceedings of AMTA 2004, Washington DC. september 2004

externa länkar

- METEOR Automatic Machine Translation Evaluation System (inklusive länk för nedladdning)